批量导入数据库是数据处理中常见的操作,尤其在需要初始化数据、迁移数据或定期更新数据时,高效的批量导入命令能显著提升工作效率,不同数据库管理系统(如MySQL、PostgreSQL、SQL Server、Oracle等)提供了不同的批量导入工具和命令,但核心逻辑均围绕“高效读取文件并写入数据库”展开,以下将以MySQL、PostgreSQL、SQL Server和Oracle为例,详细介绍批量导入数据库的命令及操作要点。

MySQL批量导入命令

MySQL中最常用的批量导入工具是mysqlimport和LOAD DATA INFILE语句。mysqlimport是命令行工具,适用于从文本文件(如CSV、TSV)导入数据,而LOAD DATA INFILE则直接在SQL语句中执行,灵活性更高。

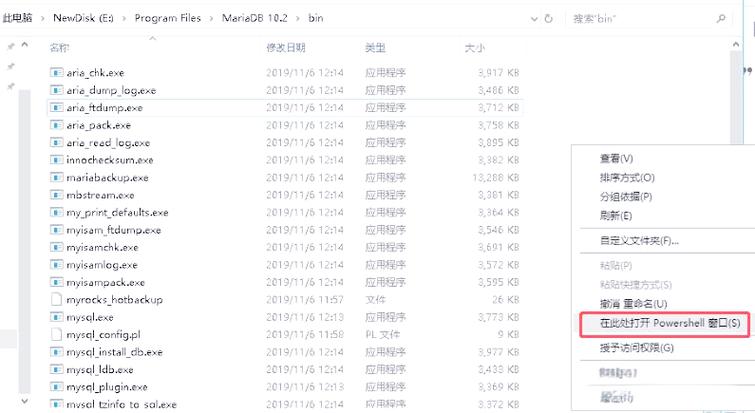

使用mysqlimport命令

mysqlimport的基本语法为:

mysqlimport [选项] 数据库名 文件名

常用选项包括:

-u:用户名-p:密码(会提示输入)-h:主机名-P:端口号--local:从客户端本地文件导入(避免服务器端文件权限问题)--ignore-lines=N:跳过文件前N行(适用于含标题行的CSV)--fields-terminated-by=分隔符:指定字段分隔符(如、\t)

导入CSV文件users.csv到test_db数据库的users表(表名与文件名去掉扩展名相同):

mysqlimport -u root -p --local test_db users.csv --fields-terminated-by=,

使用LOAD DATA INFILE语句

该语句需要具备FILE权限,语法为:

LOAD DATA INFILE '文件路径' INTO TABLE 表名 FIELDS TERMINATED BY '分隔符' LINES TERMINATED BY '\n' IGNORE 1 ROWS -- 跳过标题行 (字段1, 字段2, ...);

LOAD DATA INFILE '/var/lib/mysql-files/users.csv' INTO TABLE users FIELDS TERMINATED BY ',' LINES TERMINATED BY '\n' IGNORE 1 ROWS (id, name, email);

PostgreSQL批量导入命令

PostgreSQL常用COPY命令进行批量导入,该命令支持从标准输入或文件读取数据,效率较高,语法为:

COPY 表名 (字段1, 字段2, ...) FROM '文件路径' WITH (FORMAT CSV, HEADER, DELIMITER ',');

关键参数说明:

FORMAT CSV:以CSV格式解析,自动处理引号和转义HEADER:跳过文件第一行(标题行)DELIMITER:指定字段分隔符NULL '':将空字符串视为NULL

导入CSV文件到users表:

COPY users (id, name, email) FROM '/tmp/users.csv' WITH (FORMAT CSV, HEADER, DELIMITER ',');

SQL Server批量导入命令

SQL Server支持bcp工具(命令行)和BULK INSERT语句(T-SQL)。

使用bcp工具

bcp是轻量级命令行工具,语法为:

bcp 数据库名.表名 IN 文件路径 -S 服务器名 -U 用户名 -P 密码 -c -t 分隔符 -T

bcp test_db.dbo.users IN 'C:\data\users.csv' -S localhost -U sa -P password -c -t , -T

使用BULK INSERT语句

需在SQL Server中执行,语法为:

BULK INSERT 表名

FROM '文件路径'

WITH (

FIELDTERMINATOR = ',',

ROWTERMINATOR = '\n',

FIRSTROW = 2 -- 从第二行开始导入(跳过标题)

);

Oracle批量导入命令

Oracle常用SQL*Loader工具进行批量导入,通过控制文件(.ctl)定义导入规则,控制文件示例:

LOAD DATA INFILE 'users.csv' INTO TABLE users FIELDS TERMINATED BY "," (id, name, email)

执行命令:

sqlldr username/password@db control=users.ctl

批量导入的通用注意事项

- 文件格式匹配:确保文件编码(如UTF-8)、字段分隔符、行终止符与数据库配置一致。

- 数据类型兼容:文件中的数据需与目标表字段类型匹配(如字符串不能直接导入数值字段)。

- 索引与约束:批量导入前可临时禁用索引和外键约束,导入完成后重建,提升速度。

- 事务处理:大文件导入时建议分批提交事务,避免长事务占用资源。

- 错误处理:部分工具支持错误日志记录(如MySQL的

LOAD DATA可指定ERRFILE)。

相关问答FAQs

Q1: 批量导入时如何处理数据格式不匹配的问题?

A1: 首先检查文件数据与目标表字段的类型是否一致,例如日期字段需符合YYYY-MM-DD格式,数值字段不能包含非数字字符,若格式不匹配,可通过预处理工具(如Python的pandas库)转换数据格式,或在导入时使用数据库函数转换(如MySQL的STR_TO_DATE)。

LOAD DATA INFILE 'data.csv' INTO TABLE orders FIELDS TERMINATED BY ',' (order_id, order_date STR_TO_DATE(@date, '%Y/%m/%d'));

Q2: 批量导入速度慢如何优化?

A2: 可从以下方面优化:

- 禁用索引和约束:导入前执行

ALTER TABLE DISABLE INDEX(MySQL)或ALTER TABLE NOLOGGING(Oracle),导入后重建。 - 调整批量大小:将大文件拆分为多个小文件分批导入,避免单次数据量过大。

- 使用并行导入:如PostgreSQL的

COPY命令支持并发,Oracle的SQL*Loader可通过PARALLEL参数并行处理。 - 优化数据库配置:临时增加

innodb_buffer_pool_size(MySQL)或work_mem(PostgreSQL)等参数。