搜索引擎功能的制作是一个复杂但系统化的工程,涉及多个技术模块的协同工作,其核心目标是实现对互联网上海量信息的抓取、存储、索引和检索,最终为用户提供快速、准确的相关结果,以下从技术架构、关键模块实现及优化方向等方面详细说明搜索引擎的制作过程。

整体架构设计

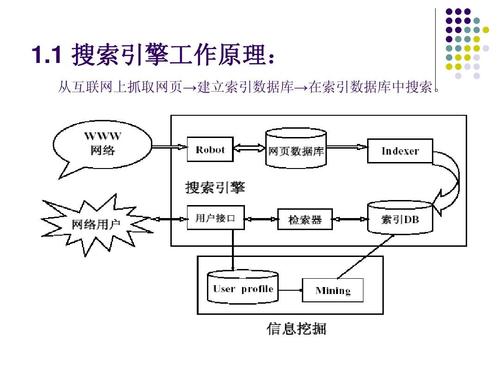

搜索引擎通常由四个核心部分组成:爬虫模块、索引模块、检索模块和用户接口模块,各模块之间通过数据流连接,形成完整的“抓取-索引-检索”闭环,以分布式架构为例,系统会使用多台服务器分别承担不同任务,以提高处理效率和系统稳定性,爬虫模块通过分布式爬虫系统并行抓取网页,索引模块采用分布式计算框架(如Hadoop、Spark)处理海量数据,检索模块则通过负载均衡策略分散查询请求。

关键模块实现

爬虫模块

爬虫是搜索引擎的“数据采集器”,负责从互联网上抓取网页内容,其实现步骤包括:

- 种子URL选择:初始阶段手动输入一批高质量URL作为起点,后续通过链接发现机制扩展抓取范围。

- URL去重:使用布隆过滤器(Bloom Filter)或哈希表存储已抓取的URL,避免重复抓取。

- 网页下载:通过HTTP请求获取网页源码,需处理动态加载内容(如JavaScript渲染),可采用无头浏览器(如Headless Chrome)技术。

- polite爬取策略:设置抓取间隔(如1秒/页),遵守robots.txt协议,避免对目标网站造成过大压力。

索引模块

索引模块将爬取的原始数据转化为可快速检索的结构化数据,核心步骤包括:

- 文本预处理:对网页内容进行分词(如使用jieba、IKAnalyzer等中文分词工具)、去除停用词(如“的”“是”)、词干提取(如“running”转为“run”)。

- 建立倒排索引:这是索引模块的核心,通过“词典+倒排列表”结构实现快速检索,词典记录所有词条,倒排列表记录每个词条出现过的文档ID及位置信息。 | 词条 | 倒排列表 | |--------|------------------------------| | 人工智能 | [(doc1, [3, 8]), (doc3, [5])] | | 搜索引擎 | [(doc1, [1]), (doc2, [7])] |

- 索引压缩与存储:采用倒排索引压缩算法(如变长编码、位图压缩)减少存储空间,并通过索引分区策略(如按文档ID分片)提升索引加载效率。

检索模块

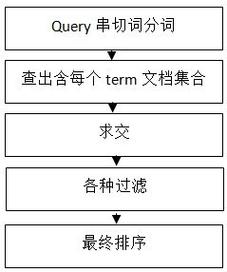

检索模块负责响应用户查询,从索引中匹配相关文档并返回结果,实现要点包括:

- 查询处理:对用户查询进行分词、拼写纠错(如基于编辑距离的算法),并构建查询语句。

- 文档相关性排序:通过排序算法(如TF-IDF、BM25、PageRank)计算文档与查询的相关度,BM25算法在TF-IDF基础上引入文档长度归一化,是目前主流的相关性计算方法。

- 结果优化:实现摘要生成(如高亮显示查询词在文档中的位置)、分页展示、个性化推荐(基于用户历史行为)等功能。

用户接口模块

用户接口是用户与搜索引擎交互的入口,包括搜索框、结果页、筛选器等前端组件,以及接收查询请求、返回结果的后端API,前端需优化响应速度(如异步加载),后端需处理高并发请求(如使用Nginx反向代理、Redis缓存热门查询结果)。

技术选型与优化

- 分布式技术:爬虫使用Scrapy-Redis实现分布式抓取,索引模块采用Elasticsearch(基于Lucene的分布式搜索引擎)简化倒排索引构建,检索模块通过微服务架构(如Spring Cloud)解耦模块依赖。

- 性能优化:通过多级缓存(本地缓存+分布式缓存)减少重复计算,使用CDN加速静态资源加载,通过索引预热技术(如提前加载热门查询的索引)降低查询延迟。

- 反作弊机制:针对垃圾链接、内容农场等问题,引入链接分析算法(如TrustRank)和内容质量评分模型,过滤低质量结果。

相关问答FAQs

Q1: 如何解决搜索引擎中的“关键词歧义”问题?

A: 关键词歧义可通过以下方法缓解:1)上下文分析:结合用户查询的上下文(如搜索“苹果”时区分“水果”和“科技公司”);2)个性化推荐:根据用户历史搜索记录调整结果排序;3)知识图谱引入:利用实体识别技术关联多义词的语义信息,例如通过“苹果公司-乔布斯-iPhone”等关系链明确查询意图。

**Q2: 搜索引擎如何保证实时性(如新网页被快速收录)?

A: 实时性优化需从爬虫和索引两方面入手:1)爬虫优先级调度:对高频更新网站(如新闻门户)提高抓取频率,使用增量爬虫(仅抓取变化内容)减少资源消耗;2)近实时索引:采用“主索引+增量索引”双结构,新网页先写入增量索引并快速合并到主索引,或使用Elasticsearch的Near Real-Time(NRT)特性实现秒级索引更新。