在当前大数据技术生态中,Hadoop作为分布式存储与计算的基础框架,仍是企业级数据处理的核心技术之一,尤其在阿里巴巴这样的大型互联网企业中,Hadoop相关岗位的招聘需求持续保持旺盛,阿里作为国内大数据技术的领军者,其Hadoop岗位招聘不仅要求候选人掌握核心技术原理,更强调工程实践能力、场景化应用经验以及对技术架构的深度理解,以下从岗位需求、技能要求、招聘流程及职业发展等方面展开详细分析。

Hadoop岗位在阿里的核心需求方向

阿里巴巴的业务场景涵盖电商、金融、物流、云计算等多个领域,每天产生的数据量以PB级别计算,这决定了Hadoop岗位的招聘需围绕大规模数据处理、实时计算、数据治理等核心方向展开,主要岗位类型包括:

-

Hadoop开发工程师

负责基于Hadoop生态(如HDFS、MapReduce、YARN)的数据平台开发,构建离线数据处理 pipeline,优化作业性能,支持业务方的数据提取、清洗与转换需求,典型场景包括双11大促期间的订单数据处理、用户行为日志分析等。 -

Hadoop运维工程师

专注于Hadoop集群的部署、监控、调优与故障处理,需确保集群高可用、高并发,同时结合容器化(如Kubernetes)和云原生技术提升资源利用率,阿里内部广泛使用自研的Hadoop发行版(如Aliware Hadoop),因此对运维工程师的定制化能力要求较高。 -

Hadoop架构师

负责设计企业级大数据架构,需结合业务需求规划存储、计算、资源调度等模块的选型与演进,例如从传统批处理向Lambda架构、Kappa架构升级,平衡实时性与一致性要求,架构师岗位通常要求8年以上相关经验,且有主导千万级节点集群设计的案例。 (图片来源网络,侵删)

(图片来源网络,侵删) -

实时计算工程师(Hadoop+Spark/Flink方向)

虽然实时计算更多依赖Spark、Flink等框架,但Hadoop仍是底层存储基石,该岗位需设计基于HDFS的实时数据接入方案,整合流批一体能力,例如实时推荐系统、风控预警系统等。

Hadoop岗位的核心技能要求

阿里对Hadoop岗位的技能要求可分为“基础硬技能”与“进阶软实力”两部分,具体如下:

(一)基础硬技能

-

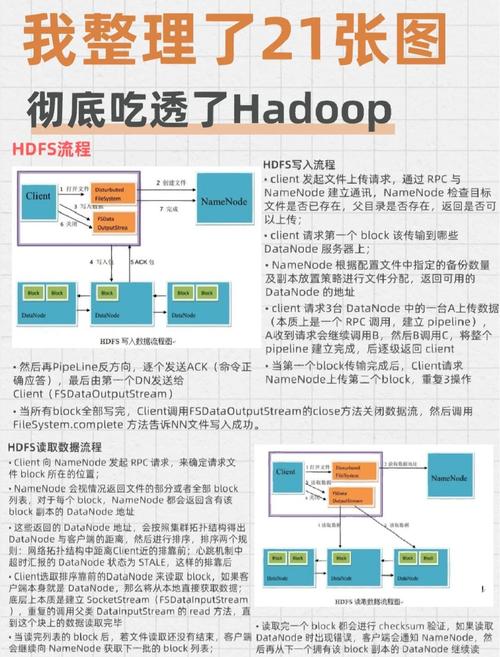

Hadoop生态深度掌握

- 存储层:HDFS架构原理(NameNode、DataNode工作机制、联邦机制)、块存储优化、纠删码技术应用;

- 计算层:MapReduce编程模型(Combiner、Partitioner优化)、YARN资源调度(Capacity Scheduler、Fair Scheduler配置);

- 生态组件:Hive(查询优化、物化视图、UDF开发)、HBase(Rowkey设计、Region分裂机制)、ZooKeeper(分布式锁、选举机制)、Kafka(消息积压处理、分区策略)等。

-

性能优化与故障排查

(图片来源网络,侵删)

(图片来源网络,侵删)- 能通过GC日志、JVM调优、MapReduce倾斜分析等手段解决作业性能瓶颈;

- 熟悉常见故障场景(如NameNode脑裂、DataNode掉线)的应急处理方案,掌握阿里云ARMS、AHAS等监控工具的使用。

-

编程与工具能力

- 熟练掌握Java(多线程、并发编程)、Scala(Spark开发),至少一种脚本语言(Python/Shell);

- 熟悉SQL(Hive SQL、Impala SQL),了解执行计划优化;

- 掌握Linux系统操作、Shell脚本编写,具备一定的C/C++阅读能力(如Hadoop源码级问题排查)。

(二)进阶软实力

-

场景化业务理解

需结合阿里的业务场景(如电商交易、用户增长、供应链优化)理解数据需求,例如通过用户行为日志构建漏斗分析模型,或通过交易数据设计实时反欺诈规则。 -

技术架构视野

关注大数据技术趋势,如存算分离(Alluxio、JuiceFS)、湖仓一体(Iceberg、Hudi)、云原生大数据等,并能结合实际需求推动架构升级。 -

团队协作与沟通

阿里强调“技术赋能业务”,需与算法、产品、运维团队高效协作,例如配合算法团队特征工程平台的数据支撑,或与产品团队对齐数据指标口径。

Hadoop岗位的招聘流程与考察重点

阿里的Hadoop岗位招聘通常包含5个环节,每个环节的考察重点如下:

| 招聘环节 | |

|---|---|

| 简历初筛 | 学历(本科及以上,985/211优先)、工作年限、项目经验(需标注Hadoop具体应用场景,如“千万级TPS数据处理”)、技术栈匹配度。 |

| 技术笔试 | Hadoop原理(如HDFS写入流程、MapReduce Shuffle阶段)、SQL优化题、Java编程题(如设计分布式锁)、场景题(如“如何处理数据倾斜”)。 |

| 一面(技术面) | 深度项目复盘(如“某集群性能优化从30分钟降至5分钟的具体措施”)、技术原理追问(如“Hive的向量化执行原理”)、场景设计题(如“设计一个日志实时分析系统”)。 |

| 二面(业务面) | 业务理解能力(如“阿里如何利用Hadoop支撑双11实时交易监控”)、技术视野(如“对比Hadoop与Spark的适用场景”)、团队协作案例。 |

| HR面 | 职业规划、抗压能力、价值观匹配(如“是否认同客户第一、拥抱变化”的阿里文化)。 |

Hadoop岗位的职业发展路径

在阿里内部,Hadoop技术岗位的职业发展路径清晰,通常分为P5-P11级(对应初级到资深专家),具体方向包括:

- 技术专家路线:P5(初级开发)→ P6(中级开发)→ P7(高级开发/技术专家)→ P8(资深专家)→ P9(研究员)→ P10(首席科学家);

- 架构师路线:P7(技术专家)→ P8(架构师)→ P9(首席架构师),负责企业级技术架构设计;

- 管理路线:P7(技术专家)→ P8(技术经理)→ P9(技术总监),带领团队完成大型项目交付。

阿里为Hadoop岗位提供完善的培养体系,如“阿里云大数据认证”“内部技术分享会”“海外技术交流”等,同时鼓励员工参与开源社区(如Apache Hadoop、Apache Flink)贡献代码,提升技术影响力。

相关问答FAQs

Q1:非科班出身,如何提升Hadoop技术竞争力以进入阿里?

A:非科班候选人需重点弥补“理论基础+项目实践”短板:

- 系统学习:通过《Hadoop权威指南》《大数据技术原理与应用》等书籍掌握核心原理,结合Coursera、慕课网等课程学习实战技能;

- 项目积累:搭建个人Hadoop集群(如伪分布式集群),完成“用户行为分析日志处理”“离线数据仓库构建”等小项目,并上传至GitHub撰写详细文档;

- 场景适配:研究阿里业务场景(如淘宝、天猫的数据需求),在项目设计中体现“高并发”“低延迟”等阿里关注的技术指标,面试时突出“解决实际问题的能力”。

Q2:阿里Hadoop岗位对“云原生大数据技术”(如K8s+Hadoop)的要求高吗?

A:要求较高,随着阿里云原生战略的推进,Hadoop集群越来越多地与Kubernetes、Service Mesh等技术结合,例如基于K8s的Hadoop资源调度、容器化部署等,候选人需了解:

- K8s核心组件(Pod、Deployment、StatefulSet)与Hadoop集群的适配方案;

- 云原生工具(如Kubeflow、Apache Airflow)在批处理任务中的应用;

- 阿里内部自研的云原生大数据平台(如阿里云EMR)的使用经验,建议通过阿里云官方文档、开源社区案例(如Apache Bigtop)提前学习,面试时可主动提及对“存算分离”“弹性伸缩”等云原生架构的理解。