搭建一个搜索类网站是一个复杂但极具价值的项目,涉及技术架构、数据处理、用户体验和商业运营等多个层面,以下从核心功能、技术选型、开发流程、优化方向等方面详细阐述搭建过程。

核心功能模块设计

搜索类网站的核心是提供高效、精准的信息检索服务,需围绕用户需求和技术可行性构建功能模块,基础模块包括:

- 数据采集模块:负责从互联网或其他数据源获取原始信息,常见方式包括爬虫技术(如Scrapy、Selenium)、API对接(如社交媒体开放平台)、用户上传(如文档分享平台)等,需设计采集策略(定向爬取或全网爬取)、反爬应对机制(IP代理池、User-Agent轮换)及数据去重算法(如MD5哈希、布隆过滤器)。

- 数据存储模块:根据数据类型和查询需求选择存储方案,结构化数据(如用户信息、商品数据)可采用MySQL、PostgreSQL等关系型数据库;非结构化数据(如文本、图片、视频)需搭配Elasticsearch、MongoDB等NoSQL数据库;大规模分布式场景下可使用Hadoop HDFS或对象存储(如AWS S3)。

- 索引构建模块:将原始数据转化为可检索的索引结构,文本类数据需分词处理(如IK分词器、Jieba)、去除停用词、构建倒排索引;多媒体数据需提取特征向量(如图片的CNN特征、音频的MFCC特征),并建立向量索引(如Faiss、Annoy),索引需定期更新,可采用增量索引(只处理新增数据)或全量重建(保证索引一致性)。

- 查询处理模块:接收用户查询请求,返回匹配结果,包括查询解析(关键词提取、拼写纠错、语义扩展,如基于BERT的模型)、查询优化(布尔逻辑运算、相关性排序算法如BM25、机器学习排序如LR、GBDT)、结果聚合(去重、分类筛选)等环节。

- 前端展示模块:提供用户交互界面,需兼顾易用性和性能,核心组件包括搜索框(支持联想输入、历史记录)、结果列表(分页加载、高亮显示)、筛选器(时间、类型、来源等)、排序选项(相关度、时间、热度),响应式设计适配PC端和移动端,采用AJAX异步加载提升体验。

- 后台管理模块:用于维护网站运行,包括用户管理(权限控制、行为日志)、数据监控(索引状态、查询延迟、错误率)、内容审核(违规过滤、敏感词过滤)、系统配置(爬虫规则、算法参数调整)等。

技术选型与架构搭建

技术选型需平衡性能、成本和开发效率,以下是典型架构组合:

| 层级 | 技术选型示例 | 作用说明 |

|----------------|----------------------------------------------------------------------------------|----------------------------------------------------------------------------|

| 前端 | React/Vue.js + Ant Design/Element UI + Nginx | 构建动态界面,Nginx负责静态资源缓存和反向代理。 |

| 后端 | Python(Django/Flask + Celery异步任务)或 Java(Spring Boot + Spring Cloud) | 处理业务逻辑,如查询请求、索引更新、用户认证。 |

| 搜索引擎 | Elasticsearch(核心搜索) + Solr(轻量级场景)或自研搜索引擎(如基于Lucene) | 提供分布式索引、实时搜索和复杂查询能力。 |

| 数据库 | MySQL(用户/订单数据) + Redis(缓存/会话管理) + MongoDB(非结构化日志存储) | 分层存储数据,Redis缓存热点查询结果(如热门搜索词)降低后端压力。 |

| 数据采集 | Scrapy(Python爬虫框架) + Puppeteer(动态页面渲染) + IP代理池(如快代理) | 爬取目标数据,支持JavaScript渲染页面,应对反爬策略。 |

| 部署运维 | Docker容器化 + Kubernetes(K8s)集群管理 + Prometheus(监控) + ELK日志分析 | 实现弹性扩缩容、自动化部署和故障告警,保障服务稳定性。 |

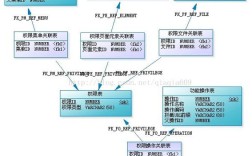

分布式架构设计:为支撑高并发和海量数据,需采用微服务架构,将搜索服务、用户服务、数据服务等拆分为独立模块,通过API网关统一入口,数据层采用分库分表(如Sharding-JDBC)和分片策略(如哈希分片、范围分片),存储层可结合CDN加速静态资源分发。

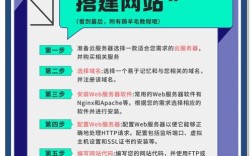

开发流程与关键步骤

- 需求分析与规划:明确搜索目标(如通用搜索、垂直领域搜索)、目标用户群体(如C端用户或企业客户)、核心指标(如查询响应时间<500ms、准确率>90%)。

- 技术验证与原型开发:搭建最小可行产品(MVP),验证核心功能(如文本搜索、分页),测试搜索引擎性能(如单节点QPS、集群扩展性)。

- 数据采集与清洗:编写爬虫脚本,设定爬取频率(如每日增量更新),对原始数据进行清洗(去除HTML标签、统一编码、过滤低质量内容)。

- 索引构建与优化:根据数据量选择索引策略(如千万级数据可按时间分片),通过调整分词器、设置字段权重(如标题权重高于正文)提升相关性。

- 服务开发与测试:实现后端API接口,编写单元测试(如查询逻辑测试)和压力测试(使用JMeter模拟高并发),优化数据库查询(如添加索引、避免全表扫描)。

- 上线与迭代:采用灰度发布逐步放量,监控线上指标(如错误率、用户停留时间),通过A/B测试优化排序算法和界面交互,定期迭代更新功能。

优化方向与挑战应对

- 搜索准确性优化:引入自然语言处理(NLP)技术,如基于BERT的语义搜索(理解用户查询意图)、知识图谱(丰富实体关联信息),结合用户行为数据(如点击率、停留时长)训练排序模型。

- 性能优化:通过缓存策略(Redis缓存热门查询结果)、索引优化(Elasticsearch的segment合并)、异步处理(消息队列削峰填谷)降低延迟;对大数据量场景采用列式存储(如Parquet格式)和分布式计算(如Spark)。

- 反爬与合规:遵守robots协议,设置爬虫访问频率(如每秒请求数≤10),对敏感数据脱敏处理;引入验证码(如reCAPTCHA)和账号限制机制防止恶意爬取。

- 个性化推荐:基于用户画像(如历史搜索、浏览记录)实现个性化排序,协同过滤(如UserCF)或深度学习模型(如DeepFM)提升用户粘性。

相关问答FAQs

Q1: 搭建搜索类网站时,如何选择自研搜索引擎还是使用开源方案(如Elasticsearch)?

A1: 需根据业务复杂度和团队技术能力权衡,若需求为通用文本搜索、高实时性且团队熟悉Java生态,Elasticsearch是首选(内置分词、聚合、分布式功能);若涉及特殊场景(如非结构化数据向量搜索、定制化排序算法),或需降低成本,可基于Lucene自研,但需投入更多开发资源维护索引和查询性能,初期建议优先测试开源方案,满足需求后再考虑自研优化。

Q2: 如何提升搜索结果的相关性,避免用户“搜不到想要的内容”?

A2: 可从三方面入手:① 数据层:优化数据质量,确保采集内容准确、时效性强,对重复或低质数据过滤;② 算法层:结合关键词匹配(TF-IDF)、语义理解(Word2Vec、BERT)和用户反馈(如点击率、负反馈样本)训练排序模型,动态调整权重;③ 交互层:提供查询纠错(如“pythan”提示“python”)、搜索建议(输入时联想热门词)和筛选器(按时间、来源等缩小范围),引导用户精准表达需求。