手动去重和自动化去重,自动化去重又可以根据工具和技术分为不同层次。

手动去重(适合少量、临时性需求)

这种方法最直接,无需任何工具,但效率极低,只适合处理非常少量的结果。

-

复制粘贴到文本编辑器:

- 将所有搜索结果复制粘贴到一个文本编辑器(如记事本、VS Code、Word)中。

- 利用编辑器的“查找和替换”功能(通常快捷键

Ctrl+F),输入需要查找的重复标题、URL或关键句子,逐个删除。 - 缺点:耗时耗力,容易遗漏,眼花缭乱。

-

使用电子表格(如 Excel 或 Google Sheets):

- 将搜索结果(标题、URL、摘要等)粘贴到表格的一列中。

- 选中该列,点击“数据” -> “删除重复项”。

- Excel 会根据你选择的列来识别并删除完全相同的行。

- 优点:比纯文本操作直观,能处理稍多一点的数据。

- 缺点:只能识别完全相同的条目,对于内容相似但标题或URL略有不同的条目无效。

自动化去重(适合大量、系统性需求)

这是更高效、更专业的方法,主要借助工具和技术来实现。

使用现成的在线工具和浏览器插件

这类工具无需编程,直接集成在浏览器中或提供网页服务,使用门槛低。

-

浏览器插件(Extensions):

- 功能:这类插件通常会在你使用 Google、Bing 等搜索引擎时,自动在搜索结果页面上标记或隐藏重复的链接、标题或内容。

- 知名插件:

- Duplicate Tab Search for Google:专门针对 Google 搜索,可以检测并隐藏完全相同的URL。

- SEO Minion:功能强大的SEO工具集,其中包含“Duplicate URL Checker”,可以快速检查页面URL列表中的重复项。

- Remove Duplicate Results:直接在搜索结果页面上提供去重按钮。

- 优点:即时生效,使用方便。

- 缺点:功能相对单一,可能无法处理复杂的去重逻辑(如语义去重)。

-

在线去重工具:

- 功能:你将一大堆URL、文本或搜索结果粘贴到网页上,网站会自动处理并返回去重后的结果。

- 知名网站:

- Online Tools:提供各种文本、列表去重工具。

- TextFixer:同样提供文本和URL列表去重功能。

- 优点:无需安装,处理速度快。

- 缺点:需要将数据上传到第三方服务器,存在隐私泄露风险;通常有文件大小限制。

使用专业软件和高级搜索技巧

-

专业数据采集/爬虫软件:

- 工具:如 Octoparse (八爪鱼)、ParseHub、Web Scraper (浏览器插件) 等。

- 方法:这类软件在配置抓取规则时,通常自带“去重”功能,你可以设置一个或多个唯一标识符(如URL、文章ID),软件在抓取过程中会自动根据这些标识符来避免重复抓取和存储数据。

- 优点:功能强大,可定制化程度高,适合大规模、持续性的数据采集项目。

- 缺点:有一定学习成本。

-

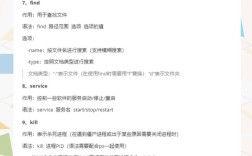

搜索引擎高级指令:

- 方法:利用搜索引擎自带的高级语法,从源头上减少重复结果。

- 核心指令:

site:和inurl: - 示例:假设你想搜索“A产品”在“example.com”官网上的信息,但不想看到重复的“产品详情页”和“规格参数页”。

- 宽泛搜索:

A site:example.com可能会返回很多页面,包括列表页、详情页、参数页等。 - 精准去重(减少重复类型):如果你只想看“新闻”或“博客”,可以限定目录:

A site:example.com/news专门抓取新闻板块。A site:example.com/blog专门抓取博客板块。

- 精准去重(排除特定URL模式):如果你发现重复的URL都包含

/product/,可以这样排除:A site:example.com -inurl:/product/

- 宽泛搜索:

- 优点:无需任何工具,直接在搜索框操作,能快速过滤掉大量低质量或重复类型的页面。

- 缺点:需要了解搜索引擎语法,无法去除内容相似但URL不同的页面。

编程实现(最强大、最灵活的方法)

如果你具备编程能力,这是处理去重问题的终极方案。

-

使用 Python: Python 是数据处理的利器,拥有丰富的库。

-

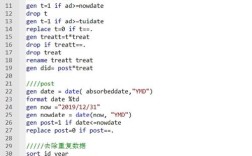

基于URL去重(最简单):

import requests from bs4 import BeautifulSoup from urllib.parse import urlparse def get_unique_urls(search_query, num_results=10): # 这里使用一个简单的伪代码,实际需要调用搜索引擎API或解析HTML # raw_urls = [...] # 获取到的原始URL列表 raw_urls = [ 'https://example.com/page1', 'https://example.com/page2', 'https://example.com/page1', # 重复URL 'http://example.com/page3', 'https://www.example.com/page1' # URL规范化前可能被认为是不同的 ] # 使用集合去重,但需要先规范化URL # 规范化:统一协议、去除www、去除末尾斜杠等 def normalize_url(url): parsed = urlparse(url) netloc = parsed.netloc.replace('www.', '') path = parsed.path.rstrip('/') return f"{parsed.scheme}://{netloc}{path}" unique_urls = list(set(normalize_url(url) for url in raw_urls)) return unique_urls unique_list = get_unique_urls("python tutorial") print(unique_list)核心思想:通过

urllib.parse解析URL,并对其进行规范化处理(如统一小写、移除www.、处理末尾的),然后将处理后的URL放入set(集合)中,集合会自动去除重复项。 -

去重(更高级): 如果两个URL不同,但内容几乎一样(如一篇文章被多个网站转载),就需要基于内容去重。

- 方法:提取网页的核心文本内容,然后通过计算文本的相似度来判断是否重复。

- 技术:

- 文本提取:使用

BeautifulSoup或readability-lxml等库提取正文。 - 文本向量化:使用

TF-IDF或Word2Vec、BERT等模型将文本转换为向量。 - 相似度计算:使用余弦相似度 等算法计算向量之间的距离,如果相似度超过某个阈值(如90%),就判定为重复。

- 文本提取:使用

- 优点:能发现隐藏的重复内容,去重效果最好。

- 缺点:技术实现复杂,计算量大,需要处理文本清洗、分词、停用词等细节。

-

总结与选择建议

| 方法类型 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

| 手动去重 | 少量(<10条)、临时性需求 | 无需工具,直接 | 效率极低,易出错 |

| 在线工具/插件 | 中等量、对隐私要求不高的临时需求 | 使用方便,即时生效 | 功能单一,有隐私和大小限制 |

| 高级搜索指令 | 快速过滤特定网站或特定类型的重复结果 | 无需工具,源头控制 | 需要学习语法,无法处理语义重复 |

| 专业爬虫软件 | 大规模、持续性的数据采集项目 | 功能强大,可定制 | 有学习成本,可能付费 |

| 编程实现 | 任何规模,特别是需要深度内容去重或集成到自动化流程中 | 最灵活、最强大、效果最好 | 需要编程技能,技术门槛高 |

给你的建议:

- 如果你只是偶尔找几篇文章:直接使用浏览器插件或Excel就足够了。

- 如果你在做一次性的市场调研,URL有几百条:使用在线去重工具或编写一个简单的Python脚本(基于URL去重)。

- 如果你是SEO专家或需要长期监控:强烈建议学习使用专业爬虫软件或自己用Python编写爬虫和去重逻辑。

- 如果你在做学术研究,需要确保内容不重复:必须使用编程实现的去重),这是最可靠的方法。