要让百度不收录网站,需要从技术手段、平台设置、内容策略等多个维度进行系统性操作,以下是具体方法和注意事项,帮助您有效控制网站的百度收录状态。

技术层面阻止百度爬虫抓取

技术手段是阻止百度收录的基础,主要通过控制爬虫的访问权限来实现。

-

Robots.txt协议设置

在网站根目录下创建robots.txt文件,明确禁止百度爬虫(User-agent: Baiduspider)访问所有或指定目录,示例代码如下:User-agent: Baiduspider Disallow: /

若仅禁止部分目录(如后台管理页),可写为:

Disallow: /admin/ Disallow: /private/

注意:

robots.txt仅能规范合规爬虫的行为,恶意爬虫可能无视该文件,需配合其他手段。 (图片来源网络,侵删)

(图片来源网络,侵删) -

HTTP头指令控制

通过服务器返回特定的HTTP头信息,直接告知百度爬虫禁止收录,常用指令包括:X-Robots-Tag: noindex:禁止索引当前页面。X-Robots-Tag: nofollow:禁止跟踪页面链接。X-Robots-Tag: none:等同于noindex与nofollow的组合。

在Nginx中的配置示例:location / { add_header X-Robots-Tag "noindex"; }

-

Meta标签设置

在HTML页面的<head>部分添加<meta name="robots" content="noindex, nofollow">标签,针对单页面禁止收录,但需注意,该标签对动态生成或已抓取页面可能无效,需结合其他手段。

百度官方平台操作

通过百度站长工具等官方渠道提交申请,可直接干预收录状态。

-

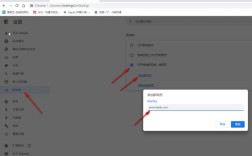

使用“robots协议工具”

在百度站长工具中验证网站后,通过“robots协议工具”提交自定义的robots.txt文件,确保百度遵循您的设置。 (图片来源网络,侵删)

(图片来源网络,侵删) -

提交“删除URL”申请

若网站已被收录,可通过“普通收录”中的“删除URL”功能提交需要移除的页面链接,百度处理时间通常为几天至数周,具体取决于页面重要性。

操作步骤:- 登录百度站长工具 → 选择“普通收录” → “删除URL” → 输入需删除的URL或提交URL文件。

- 需验证网站所有权,且仅能删除已收录页面。

-

设置“网站改版”功能

若网站结构发生重大变化(如停用旧域名),可通过“网站改版”功能提交新旧域名对应关系,百度会优先处理旧页面的删除请求。

内容与服务器策略调整质量和服务器配置,间接降低百度收录意愿。

-

降低页面质量与价值

百度倾向于收录高质量内容,可通过以下方式降低页面吸引力:- 大量重复或低原创度内容;

- 频繁更新错误页面(如404、500);

- 页面加载速度极慢(如服务器响应超时)。

注意:此方法可能损害网站长期价值,需谨慎使用。

-

服务器返回403或404状态码

对需要禁止收录的页面,服务器直接返回403(禁止访问)或404(未找到)状态码,百度爬虫会认为页面不可用而放弃收录。

示例:- Apache服务器配置:

<Directory "/private"> Require all denied </Directory> - Nginx服务器配置:

location /private { return 403; }

- Apache服务器配置:

常见问题与注意事项

-

生效时间

技术手段(如robots.txt、HTTP头)通常在百度下次抓取时生效,而官方删除申请需3-7天处理。 -

搜索引擎差异

不同搜索引擎(如谷歌、搜狗)的爬虫规则不同,需单独配置,例如谷歌爬虫为Googlebot,需在robots.txt中单独声明。 -

动态页面处理

对于动态生成的页面(如PHP、ASPX),需确保服务器正确返回禁止指令,避免因参数变化导致部分页面被收录。

相关问答FAQs

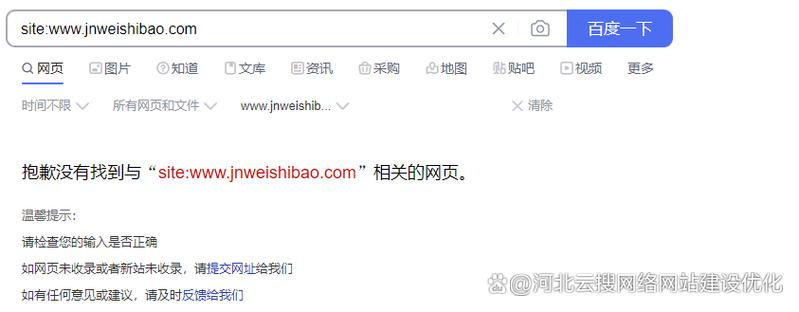

Q1:已提交删除URL申请,为何百度仍显示页面?

A:百度删除申请的处理周期一般为3-7天,若页面为高权重内容或被其他网站引用,处理时间可能延长,若页面存在镜像或缓存,需确保所有版本均被移除,可检查百度搜索结果中的“快照”是否已消失,或通过site:命令确认是否仍被索引。

Q2:设置robots.txt禁止收录后,百度会立即停止抓取吗?

A:robots.txt仅作为“建议”,百度爬虫在下次抓取时会遵循该规则,但不会立即停止已有抓取任务,若需快速移除已收录页面,建议通过百度站长工具提交删除申请,同时配合noindex标签和403/404状态码,加速处理进程。