在Hadoop分布式文件系统(HDFS)中,查看文件是日常操作的核心环节,掌握相关命令能有效提升数据管理效率,HDFS提供了多种命令用于查看文件内容、获取文件信息以及浏览目录结构,这些命令通过Hadoop Shell或Java API实现,其中Shell命令因操作简便而被广泛使用,以下将详细介绍常用的HDFS查看文件命令及其使用场景。

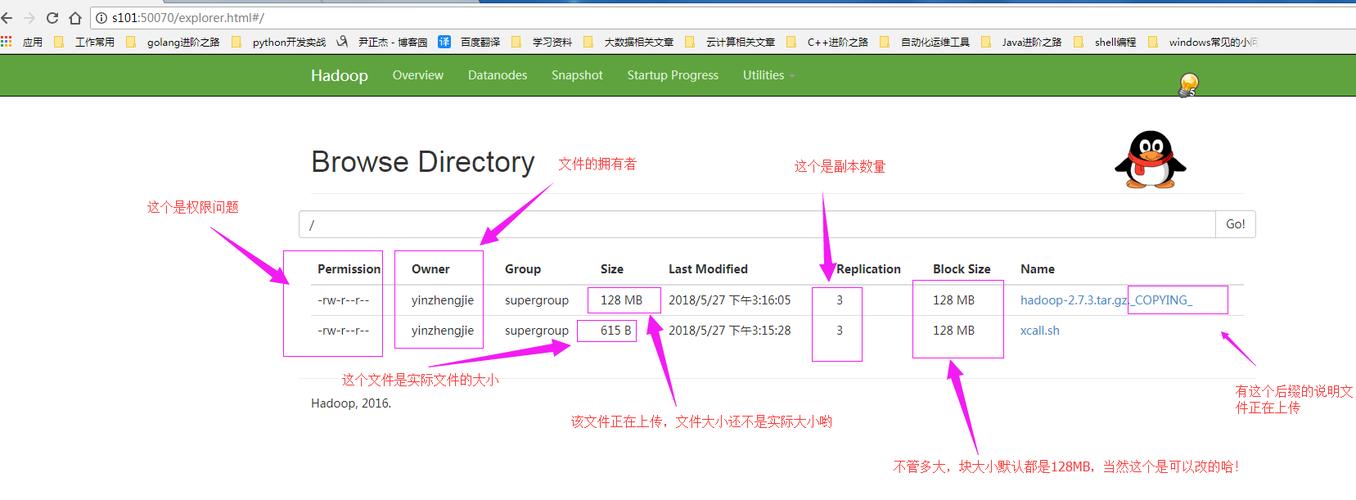

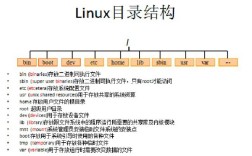

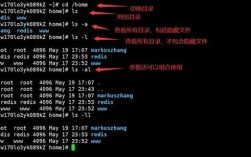

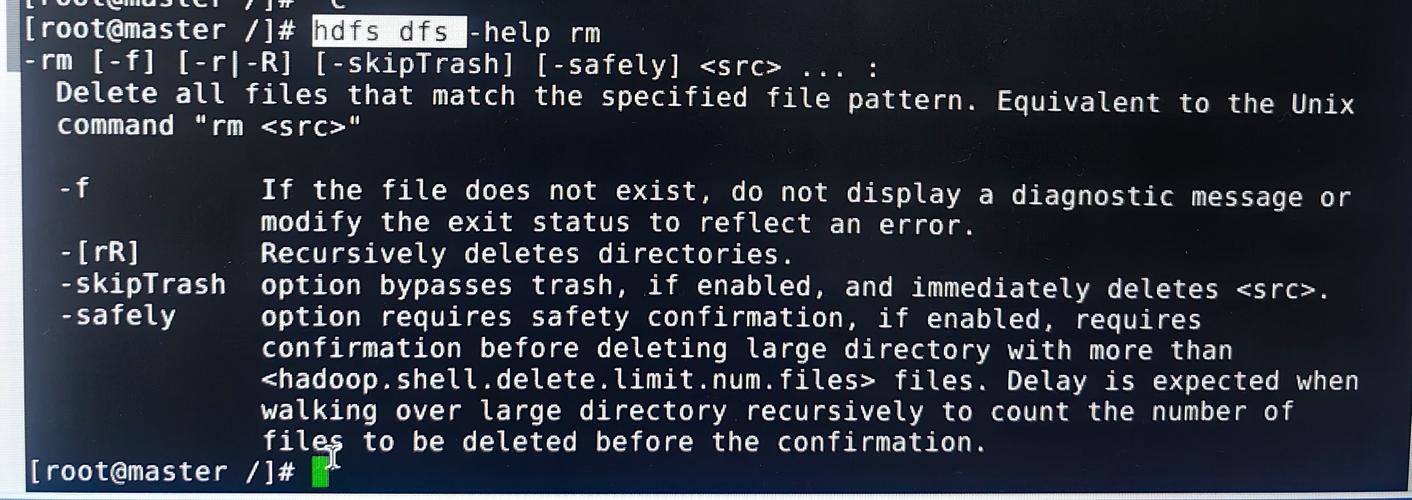

hdfs dfs -ls是最基础的目录浏览命令,类似于Linux系统中的ls命令,该命令用于列出指定目录下的文件和子目录信息,包括权限、所有者、大小、修改时间等元数据。hdfs dfs -ls /user/hadoop会显示该目录下的所有文件和文件夹列表,若需递归查看子目录内容,可添加-R参数,即hdfs dfs -ls -R /user/hadoop,此时会递归输出所有层级的文件和目录,需要注意的是,-ls命令仅显示文件元数据,不涉及文件内容,适合快速了解目录结构。

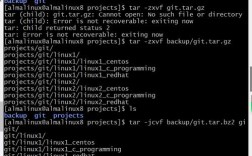

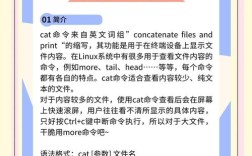

当需要查看文件内容时,hdfs dfs -cat是常用命令,其功能类似于Linux的cat,用于将文件内容输出到终端。hdfs dfs -cat /user/hadoop/data.txt会直接显示文件data.txt,若文件较大,直接输出可能导致终端卡顿,此时可结合more或less命令分页显示,如hdfs dfs -cat /user/hadoop/bigdata.txt | more。-cat命令支持同时查看多个文件,用空格分隔文件路径即可,如hdfs dfs -cat file1.txt file2.txt,但需注意,该命令仅适用于文本文件,若处理二进制文件,输出内容可能为乱码。

对于大文件,直接使用-cat查看不够高效,此时可选用hdfs dfs -tail命令,该命令类似Linux的tail,默认显示文件的末尾1000行内容。hdfs dfs -tail /user/hadoop/log.txt会实时展示文件的最新日志记录,特别适用于查看不断追加的日志文件,若需指定显示行数,可通过-n参数实现,如hdfs dfs -tail -n 500 /user/hadoop/log.txt显示末尾500行,与-cat不同,-tail仅读取文件部分内容,资源消耗更低,适合实时监控场景。

若仅需查看文件的元数据信息(如大小、副本数、块大小等),可使用hdfs dfs -stat命令。hdfs dfs -stat %s /user/hadoop/data.txt会返回文件的大小(字节),而hdfs dfs -stat %y则显示文件的最后修改时间,该命令支持多种格式化输出参数,如%n(文件名)、%r(副本数)等,适合在脚本中获取文件属性。hdfs dfs -du命令用于计算目录或文件所占的磁盘空间,hdfs dfs -du -s /user/hadoop会汇总显示该目录的总大小,而-h参数可将其转换为易读的单位(如KB、MB),如hdfs dfs -du -h /user/hadoop。

以下是常用HDFS查看命令的总结表格:

| 命令格式 | 功能描述 | 示例 | 适用场景 |

|---|---|---|---|

hdfs dfs -ls [path] |

列出目录内容 | hdfs dfs -ls /user |

浏览目录结构 |

hdfs dfs -ls -R [path] |

递归列出目录内容 | hdfs dfs -ls -R /user |

查看多层级目录 |

hdfs dfs -cat [path] |

查看文件全部内容 | hdfs dfs -cat data.txt |

查看小文件内容 |

hdfs dfs -tail [path] |

查看文件末尾内容 | hdfs dfs -tail log.txt |

实时监控日志 |

hdfs dfs -stat [format] [path] |

获取文件元数据 | hdfs dfs -stat %s file.txt |

获取文件大小、修改时间等 |

hdfs dfs -du [path] |

计算文件/目录大小 | hdfs dfs -du -h /user |

查看磁盘占用情况 |

在实际操作中,需注意HDFS命令的权限问题,执行用户需对目标文件具有读取权限,对于大文件,避免频繁使用-cat命令,以免因网络传输或磁盘I/O导致性能下降,合理结合-tail、-stat等命令,可更高效地完成文件查看任务。

相关问答FAQs

Q1: 如何查看HDFS中某个目录下所有文件的总大小?

A: 使用hdfs dfs -du -s /path/to/directory命令,其中-s表示汇总显示目录总大小,-h参数可将其转换为易读的单位(如MB、GB),例如hdfs dfs -du -sh /user/hadoop。

Q2: 如果HDFS文件很大,如何只查看文件的前100行内容?

A: HDFS本身没有直接的前n行查看命令,但可通过组合命令实现:先将文件下载到本地,再用head命令查看,如hdfs dfs -get /user/hadoop/bigfile.txt - | head -n 100;或者使用Hadoop Streaming工具结合Python脚本处理,但前者更简单高效。