在当今数据驱动的时代,企业对数据处理的效率与质量要求日益提升,ETL(Extract-Transform-Load)作为数据整合的核心环节,其人才需求持续增长,尤其初级ETL岗位成为许多企业入门级数据岗位的热门选择,初级ETL招聘不仅关注候选人的技术基础,更注重其逻辑思维、学习能力和对数据敏感度等综合素质,以下从岗位定义、核心职责、任职要求、招聘流程及注意事项等方面展开详细分析。

初级ETL岗位概述

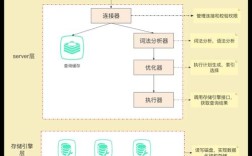

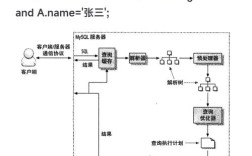

初级ETL工程师是数据团队中的基础执行者,主要负责参与数据抽取、转换、加载流程的设计与实现,协助搭建和维护数据管道,确保数据从源系统到目标系统(如数据仓库、数据湖)的准确流转,该岗位通常要求1-3年相关经验,或应届毕业生(计算机、统计学、数学等相关专业)掌握ETL核心工具与技术,能够在指导下完成模块化任务,逐步成长为独立负责数据流程的工程师。

核心工作职责

初级ETL工程师的日常工作围绕“数据流转”展开,具体职责包括:

数据抽取(Extract)

- 源系统对接:与业务部门、数据团队协作,明确数据源(如关系型数据库MySQL/Oracle、日志文件、API接口、第三方数据平台等)的结构与字段含义,编写抽取脚本或使用工具(如Kafka、Sqoop)从源系统获取原始数据。

- 数据校验:检查抽取数据的完整性(如字段是否缺失)、一致性(如数据类型是否匹配)和准确性(如数值范围是否合理),记录异常数据并反馈给源系统负责人。

数据转换(Transform)

- 数据清洗:处理重复数据、缺失值(如填充默认值、删除无效记录)、异常值(如修正超出合理范围的数值),确保数据符合目标系统的规范。

- 数据标准化:统一数据格式(如日期格式“YYYY-MM-DD”、字符串大小写)、编码规则(如UTF-8)和业务口径(如“用户性别”字段统一用“0/1”代替“男/女”)。

- 数据计算与整合:根据业务需求进行衍生字段计算(如“用户年龄=当前年份-出生年份”)、多表关联(如通过用户ID关联订单表与用户信息表)、数据聚合(如按地区统计销售额)。

- 逻辑实现:使用ETL工具(如Informatica PowerCenter、Talend、DataStage)或编程语言(如Python的Pandas库、SQL)编写转换规则,确保数据符合业务逻辑。

数据加载(Load)

- 目标系统写入:将清洗转换后的数据加载至目标系统(如数据仓库的维度表、事实表,或数据湖的Parquet格式文件),优化加载策略(如批量加载、增量加载)以提升效率。

- 加载监控:跟踪数据加载状态,记录成功/失败任务,对失败任务进行重试或告警,确保数据按时到达目标系统。

文档与协作

- 流程文档编写:维护ETL流程说明、数据字典(包含字段含义、类型、来源)、异常处理手册,便于团队协作与后续维护。

- 跨部门沟通:与业务分析师、数据开发工程师、运维团队协作,理解数据需求变化,协助排查数据问题(如数据指标波动、口径不一致)。

任职要求与技术栈

初级ETL岗位的任职要求可分为“硬技能”与“软技能”两部分,企业通常根据自身技术栈侧重调整具体标准。

硬技能

- 数据库基础:

- 熟练掌握SQL(包括增删改查、复杂查询、子查询、窗口函数等),能够独立编写数据提取与转换脚本;

- 了解至少一种关系型数据库(MySQL、Oracle、SQL Server)的基本操作与索引优化原理。

- ETL工具:

- 掌握至少一种主流ETL工具,如Talend(开源版)、Informatica、Kettle(Pentaho)等,了解工具的组件化开发流程(如Talend的tMap、tFilterRow);

- 熟悉数据调度工具(如Apache Airflow、Oozie、Azkaban)的基本使用,能够配置定时任务。

- 编程语言:

- 掌握Python基础语法,熟悉数据处理库(Pandas、NumPy),能够用Python编写数据清洗脚本;

- 了解Shell脚本或PowerShell,用于自动化执行简单任务(如文件传输、日志清理)。

- 大数据基础(加分项):

- 了解Hadoop生态(HDFS、MapReduce)、Spark基础,或数据湖技术(如Delta Lake、Iceberg);

- 熟悉NoSQL数据库(如MongoDB、Redis)的基本操作。

软技能

- 逻辑思维:能够拆解复杂数据问题,设计清晰的转换规则,确保数据处理逻辑的严谨性。

- 学习能力:快速掌握新工具、新技术(如企业自研ETL平台),适应数据规范的更新。

- 沟通能力:准确理解业务需求,清晰表达数据问题,与跨部门团队高效协作。

- 责任心:对数据质量敏感,主动监控任务异常,确保数据交付的及时性与准确性。

招聘流程与关键环节

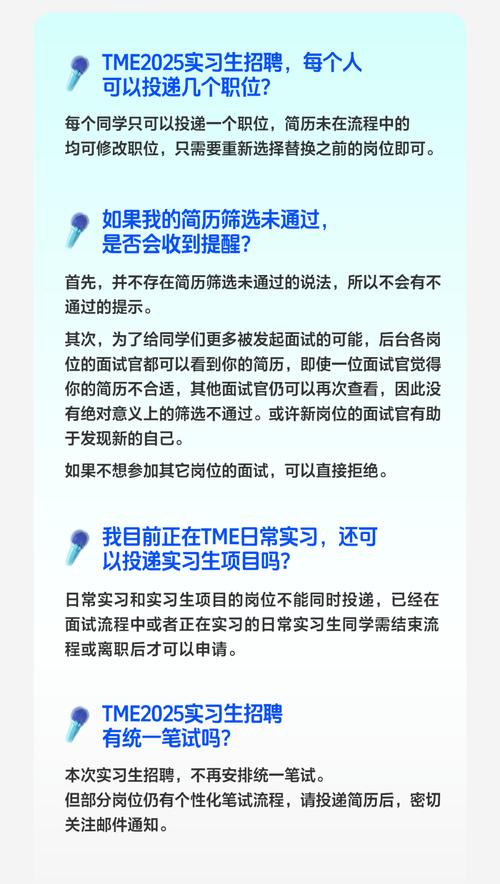

企业招聘初级ETL工程师通常遵循“简历筛选→笔试→面试→Offer发放→入职”的流程,各环节重点如下:

简历筛选

- 关键词匹配:关注简历中“ETL”“数据仓库”“SQL”“Python”“Talend”等核心技能词,排除与岗位要求明显不符的候选人。

- 项目经验:优先筛选有实际ETL项目经验的候选人(如实习期间参与数据清洗、校园项目中的数据整合),即使项目规模较小,也可考察其流程理解能力。

- 学历与专业:本科及以上学历,计算机、统计学、数学、数据科学等相关专业优先,非专业候选人若具备自学经历(如在线课程、认证)也可纳入考虑。

笔试环节

笔试主要考察技术基础与逻辑能力,常见题型包括:

- SQL题:编写复杂查询(如“查找连续3个月下单的用户”)、多表关联(如“用户表+订单表+商品表三表关联统计”);

- ETL场景题:设计数据清洗流程(如“处理日志中的时间戳格式不一致问题”)、转换规则(如“将Excel中的“地区”字段统一为省级编码”);

- Python编程题:用Pandas处理缺失值、数据分组聚合等;

- 选择题:考察数据库索引、数据仓库分层(ODS、DWD、DWS、ADS)、ETL工具原理等基础知识。

面试环节

面试通常包括1-2轮技术面+1轮HR面,技术面重点考察:

- 项目深挖:让候选人详细介绍参与过的ETL项目,包括数据源、转换逻辑、遇到的问题及解决方案(如“如何处理数据量大的表抽取效率低的问题?”);

- 技术原理:询问“增量加载与全量加载的区别”“数据倾斜的解决方法”“ETL工具中如何实现错误数据重试”等;

- 场景模拟:给出业务场景(如“需要整合电商平台的用户行为数据与订单数据,构建用户画像”),让候选人描述ETL流程设计思路。

HR面则关注职业规划、团队合作意识、稳定性等,判断候选人是否与企业价值观匹配。

Offer发放与入职

通过综合评估后,发放Offer并明确岗位职责、薪资范围、入职时间,入职前可安排1-2周技术培训,帮助候选人熟悉企业数据规范、ETL平台操作及业务流程。

招聘注意事项

- 避免“唯经验论”:初级岗位可适当放宽经验要求,关注候选人的学习潜力和基础扎实度,例如应届毕业生若掌握SQL、Python且有自学项目,培养价值较高。

- 技术栈匹配:优先选择与企业现有技术栈(如Talend+Airflow+MySQL)一致的候选人,降低培训成本;若候选人技术栈不同,需评估其快速适应能力。

- 文化契合度:数据工作需耐心与细致,HR面试时可通过行为面试题(如“是否曾因数据错误导致任务返工?如何避免?”)考察候选人的工作态度。

相关问答FAQs

Q1:初级ETL工程师与数据分析师的区别是什么?

A:两者核心差异在于工作重心与目标,初级ETL工程师聚焦“数据流转”,负责将原始数据加工为可用数据,确保数据的准确性、完整性,是数据生产的基础环节;数据分析师则聚焦“数据价值挖掘”,通过分析已加工的数据(如报表、可视化结果)为业务决策提供支持,更侧重业务理解与逻辑推理,ETL工程师“造数据管道”,分析师“用数据说话”。

Q2:没有ETL项目经验的应届生如何准备求职?**

A:可通过以下方式弥补经验短板:① 自学项目:在GitHub上找ETL实战项目(如“电商用户数据清洗与分析”),用Python+SQL+Talend工具完整实现,并记录流程文档;② 实习经历:争取数据开发、数据仓库相关的实习岗位,即使是协助工作(如数据抽取、日志监控),也能积累实战经验;③ 考取认证:如Talend认证数据集成工程师、Oracle数据库认证,提升简历竞争力;④ 刷题与面试准备:重点练习SQL题、ETL场景题,熟悉企业常见面试问题(如“如何处理数据重复?”),展现逻辑思维与学习能力。