单页网站(Single Page Application, SPA)因其内容集中、交互流畅的特点,在当下网站设计中越来越受欢迎,由于其内容通过JavaScript动态加载,搜索引擎爬虫在抓取和索引时可能会遇到一些挑战,要让单页网站被搜索引擎有效收录,需要从技术实现、内容优化、服务器配置等多个方面进行系统性的规划和执行,以下将详细阐述单页网站被收录的关键策略和具体操作方法。

理解搜索引擎爬虫的工作原理是基础,传统多页网站的每个URL对应一个独立的HTML文件,爬虫通过直接请求URL即可获取完整内容,而单页网站通常只有一个初始HTML文件,其他内容通过JavaScript在用户交互后动态加载到当前页面,这意味着,如果爬虫不执行或无法正确执行JavaScript,它可能只能看到初始的“骨架”内容,而无法获取后续动态加载的核心信息,确保爬虫能够“看到”并理解所有重要内容,是单页网站收录的核心问题。

技术层面是解决问题的关键,现代主流搜索引擎,如Google和百度,已经具备了一定的JavaScript渲染能力,但这并不意味着可以高枕无忧,为了确保最佳的抓取效果,需要关注以下几点,第一,确保网站的基础HTML结构是“可爬取的”和“可索引的”,即使没有JavaScript,爬虫也应该能够从初始HTML中获取到页面的核心主题和关键信息,这意味着重要的导航链接、核心内容的摘要、标题(H1-H6)等都应该直接写在HTML中,而不是完全依赖JavaScript生成,第二,合理使用History API,单页网站的URL通常不会因内容切换而改变,这不利于SEO和用户理解页面状态,通过使用History API(window.history.pushState()),可以在用户切换内容时改变浏览器地址栏的URL,同时保持页面不刷新,将首页URL设为example.com/,产品介绍页设为example.com/products,关于我们设为example.com/about,这样,爬虫可以针对不同的URL进行抓取,并且用户也可以通过直接输入URL访问特定内容,甚至可以分享特定状态的链接,第三,处理JavaScript渲染问题,虽然Google的爬虫(如Googlebot)会执行JavaScript,但执行资源有限,且可能存在延迟,应避免使用过于复杂的JavaScript框架或可能导致渲染阻塞的代码,对于关键内容,应确保在服务器端能够提供一定的静态版本,或者通过其他方式引导爬虫获取完整信息,可以使用“预渲染”(Prerendering)服务,为爬虫生成静态HTML版本,或者,采用“同构渲染”(Isomorphic Rendering)或“服务端渲染”(Server-Side Rendering, SSR)技术,使得服务器能够直接返回包含完整内容的HTML,这对于SEO最为友好,但技术实现相对复杂。

优化是吸引用户和爬虫的核心,无论网站技术架构如何,高质量、原创、相关的内容始终是获得良好排名的基础,对于单页网站,内容优化需要特别注意以下几点,第一,语义化HTML标签,使用<header>、<nav>、<main>、<article>、<section>、<footer>等HTML5语义化标签,清晰地构建页面结构,这有助于爬虫理解页面各部分内容的逻辑关系,第二,关键词策略,在页面标题(<title>)、元描述(<meta description>)、各级标题(H1-H6)、段落文本、图片ALT属性等位置,自然地融入目标关键词,由于单页网站可能包含多个“页面”的内容,需要为每个内容区块都设定清晰的主题关键词,并通过URL路径加以区分(如前所述使用History API),第三,内部链接结构,虽然单页网站没有传统意义上的多个HTML页面,但可以通过锚点链接或通过History API改变URL后,在页面上创建指向不同内容区块的链接,这有助于爬虫发现和抓取所有内容,也能提升用户体验,第四,图片和多媒体优化,确保所有图片都配有描述性的ALT文本,这有助于搜索引擎理解图片内容,对图片进行压缩,减少文件大小,提高页面加载速度,因为页面速度也是搜索引擎排名的因素之一。

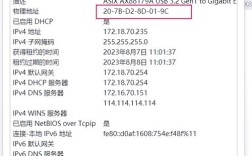

服务器配置和性能优化同样不可忽视,一个加载缓慢或经常无法访问的网站,很难被搜索引擎收录并获得好排名,对于单页网站,服务器配置需要考虑以下几点,第一,启用Gzip或Brotli压缩,对服务器输出的HTML、CSS、JavaScript等文件进行压缩,可以显著减少传输数据量,加快页面加载速度,第二,配置正确的缓存策略,利用HTTP头信息(如Cache-Control、Expires)设置浏览器缓存,对于静态资源(如JS、CSS、图片)设置较长的缓存时间,减少重复请求,加快用户二次访问速度,第三,确保服务器的稳定性和响应速度,选择可靠的主机服务,避免因服务器宕机或响应缓慢导致爬虫抓取失败,第四,生成和提交sitemap,sitemap是网站地图,列出了网站上所有可访问的URL,对于单页网站,如果使用了History API实现了伪静态URL,就应该将这些动态生成的URL都加入到sitemap中,并提交给搜索引擎的站长平台(如Google Search Console、百度站长工具),这能帮助搜索引擎更高效地发现和抓取网站的所有内容,以下是一个简单的sitemap.xml示例结构,展示了如何为单页网站的不同“页面”创建条目:

| URL | 最后修改时间 (lastmod) | 更新频率 (changefreq) | 优先级 (priority) |

|---|---|---|---|

| https://www.example.com/ | 2023-10-27 | weekly | 0 |

| https://www.example.com/products | 2023-10-26 | monthly | 8 |

| https://www.example.com/about | 2023-10-25 | yearly | 6 |

| https://www.example.com/contact | 2023-10-24 | monthly | 6 |

持续监控与迭代,在完成上述优化后,需要通过搜索引擎的站长工具来监控网站的抓取、索引和排名情况,Google Search Console和百度站长工具都提供了丰富的数据,覆盖范围”报告可以展示哪些URL被成功索引,“URL检查”工具可以测试特定URL的抓取和渲染效果,如果发现某些页面没有被收录,或者收录的内容不完整,需要回头检查技术实现、内容质量和服务器配置,并进行相应的调整,SEO是一个持续的过程,随着搜索引擎算法的更新和网站内容的变化,需要不断优化策略。

相关问答FAQs:

问题1:单页网站完全不使用JavaScript就无法被搜索引擎收录吗? 解答:并非完全如此,但会严重影响收录效果,如果单页网站完全不使用JavaScript,那么它本质上就退化成了一个传统的单页HTML网站,搜索引擎可以抓取并索引这个页面上的所有静态内容,现代单页网站的核心功能和内容通常都依赖于JavaScript动态加载,如果禁用JavaScript,用户将无法看到这些动态内容,搜索引擎爬虫也同样无法获取,关键不在于是否使用JavaScript,而在于确保即使在不执行JavaScript的情况下,爬虫也能访问到页面的核心信息,或者通过其他技术手段(如服务端渲染、预渲染)让爬虫获取到完整的、渲染后的内容。

问题2:为什么我的单页网站提交了sitemap,但很多页面还是没有被搜索引擎收录? 解答:Sitemap只是向搜索引擎提交了一个“待抓取”的URL清单,它并不能保证这些URL一定会被收录,导致单页网站页面不被收录的原因可能有很多:检查这些页面的内容是否足够丰富和有价值,搜索引擎倾向于收录高质量、有独特内容的页面,使用搜索引擎的“URL检查”工具(如Google Search Console中的URL Inspection)来诊断具体问题,可能的原因包括:页面加载速度过慢、JavaScript渲染失败导致爬虫看不到内容、页面存在技术性错误(如404、500)、网站设置了robots.txt文件禁止了这些URL的抓取,或者搜索引擎的爬虫资源有限,暂时还没有抓取到这些页面,需要逐一排查这些可能的原因,并进行针对性修复。