在人工智能和自动化领域,vs生成事件命令是一种基于视觉与语义协同的事件驱动指令生成技术,其核心目标是通过融合视觉场景理解与语义逻辑分析,自动生成可执行的事件触发命令,这一技术广泛应用于智能监控、机器人控制、自动驾驶等场景,能够显著提升系统的响应速度和决策准确性,以下从技术原理、实现流程、应用场景及挑战等方面展开详细分析。

技术原理

vs生成事件命令的核心在于“视觉-语义双模态融合”,视觉模态通过图像或视频流识别场景中的实体、动作及环境状态,例如检测到“行人穿越马路”“车辆突然停止”等事件;语义模态则结合上下文知识库,对视觉信息进行逻辑推理,判断事件是否触发预设条件,当系统识别到“行人闯红灯”且车辆处于“行驶状态”时,语义模块会判定为高风险事件,并生成“触发紧急制动”命令,这一过程依赖深度学习模型(如CNN、Transformer)对视觉特征的提取,以及知识图谱对语义关系的建模。

实现流程

实现vs生成事件命令通常分为以下步骤:

- 数据采集与预处理:通过摄像头、传感器等设备获取视觉数据,并进行去噪、归一化处理。

- 视觉事件检测:利用目标检测算法(如YOLO、Faster R-CNN)识别场景中的关键对象,并通过行为识别模型(如LSTM、3D CNN)判断动作类型。

- 语义逻辑推理:将检测结果输入知识图谱,结合规则引擎(如SWRL、Drools)进行条件匹配,规则可定义为“IF(行人闯红灯)AND(车辆距离<5米)THEN(触发警报)”。

- 命令生成与执行:根据推理结果生成结构化命令(如JSON格式),并通过API或中间件传递给执行设备(如机器人控制器、交通信号系统)。

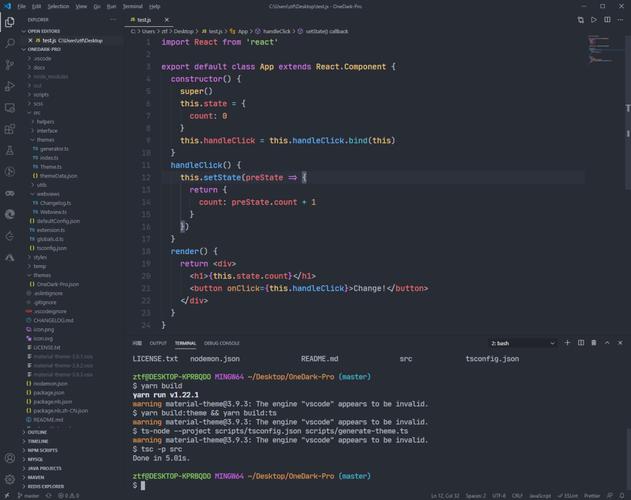

以下为典型命令生成逻辑的简化示例:

| 视觉事件 | 语义条件 | 生成的命令 |

|---|---|---|

| 检测到火焰 | 温度>60℃且持续10秒 | 启动喷淋系统,发送火警通知 |

| 识别到跌倒行为 | 人员静止时长>30秒 | 联系紧急联系人,开启摄像头追踪 |

| 检测到车辆偏离车道 | 转向角度异常且车速>80km/h | 触发方向盘震动警示 |

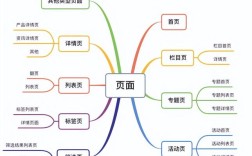

应用场景

- 智能交通:通过分析路口监控视频,自动生成“红绿灯切换”“违章抓拍”等命令,优化交通流量。

- 工业自动化:在生产线上,检测到零件缺失或设备异常时,生成“停机检修”“机械臂分拣”等指令。

- 智能家居:结合视觉传感器与用户习惯,生成“调节室温”“开启灯光”等个性化命令。

挑战与优化方向

当前技术面临的主要挑战包括:

- 多模态数据对齐:视觉与语义信息的时空同步需高精度模型支持。

- 复杂场景泛化:动态环境下(如光照变化、遮挡)的事件识别准确率有待提升。

- 实时性要求:高并发场景下需优化推理速度,可采用边缘计算降低延迟。

未来可通过引入强化学习提升命令生成的自适应能力,或结合联邦学习解决数据隐私问题。

相关问答FAQs

Q1:vs生成事件命令与传统规则引擎的区别是什么?

A1:传统规则引擎依赖人工编写固定的IF-THEN逻辑,灵活性较低;而vs生成事件命令通过视觉感知和动态语义推理,能适应复杂场景,并支持自主学习优化,传统规则难以处理“雨天路滑导致车辆打滑”等新事件,而vs系统可通过视觉识别雨滴和车辆轨迹,自动生成减速命令。

Q2:如何提升vs生成事件命令在低光照环境下的准确性?

A2:可通过以下方法优化:1)采用红外摄像头或增强算法(如Retinex)提升图像质量;2)引入跨模态预训练模型(如CLIP),融合文本与视觉特征;3)在知识图谱中添加“低光照补偿”规则,当检测到环境光强<10lux时,启用红外模式并降低事件检测阈值”。