在当今数据驱动的商业环境中,企业对数据处理的效率和准确性要求日益提高,ETL(Extract-Transform-Load,提取、转换、加载)作为数据仓库和数据分析体系的核心环节,其专业人才的需求持续攀升,ETL招聘不仅是技术岗位的补充,更是企业构建数据基础设施、实现数据价值的关键一步,本文将围绕ETL岗位的职责要求、核心能力、招聘流程及行业趋势展开详细分析,为企业和求职者提供参考。

ETL岗位的核心职责与工作场景

ETL工程师主要负责设计、开发和维护数据集成 pipeline,确保数据从源系统到目标系统的稳定流转,具体职责包括:

- 数据提取:从关系型数据库(如MySQL、Oracle)、大数据平台(如Hadoop、Spark)、API接口、日志文件等多种异构数据源中高效、准确地抽取数据,需处理数据格式差异、增量同步、全量加载等场景。

- 数据转换:对提取的数据进行清洗、去重、格式标准化、字段映射、业务规则计算(如数据脱敏、指标聚合),确保数据质量符合分析需求,这一环节需兼顾技术实现与业务逻辑的准确性。

- 数据加载:将转换后的数据加载至目标系统,如数据仓库(如Snowflake、RedShift)、数据湖(如Delta Lake、Iceberg)或业务数据库,需优化加载策略(如批量加载、实时流式加载)以提升性能。

- 流程监控与优化:构建ETL任务监控体系(如使用Airflow、Kafka监控任务状态),及时发现并处理数据延迟、异常中断等问题,定期对ETL流程进行性能调优(如并行化处理、索引优化)。

- 技术文档与协作:编写ETL设计文档、数据字典,与数据分析师、数据科学家、业务部门紧密沟通,理解数据需求并转化为技术方案。

工作场景上,ETL工程师需根据企业数据规模选择技术栈:传统企业多基于Oracle、Informatica等商业工具,互联网公司则更倾向开源生态(如Spark Flink、Kafka、Airflow),金融、医疗等行业对数据安全性和合规性(如GDPR、数据血缘追踪)要求更高。

ETL岗位的核心能力要求

ETL招聘中,企业通常从技术能力、业务理解、软技能三个维度评估候选人,以下为关键能力点:

(一)技术能力

- 数据库与SQL:熟练掌握SQL(如窗口函数、复杂查询),精通至少一种关系型数据库(MySQL、PostgreSQL)和一种NoSQL数据库(MongoDB、Redis),了解数据库索引优化、事务处理原理。

- 大数据技术栈:熟悉Hadoop生态(HDFS、MapReduce)、Spark(PySpark/Scala)或Flink等分布式计算框架,掌握数据分区、缓存、并行度优化等性能调优手段;了解Kafka、RabbitMQ等消息队列用于实时数据抽取。

- ETL工具与编程:掌握至少一种ETL工具(如Apache NiFi、Talend、DataStage)或编程语言(Python、Java、Scala),能独立开发ETL脚本;熟悉工作流调度工具(如Airflow、DolphinScheduler),实现任务依赖管理与自动化执行。

- 云数据平台:熟悉主流云服务商的数据产品(如AWS Glue、Azure Data Factory、Google Dataflow),具备云上数据架构设计与运维能力。

(二)业务理解能力

- 理解数据仓库分层架构(ODS、DWD、DWS、ADS),能根据业务需求设计数据模型(如星型模型、雪花模型);

- 熟悉行业业务逻辑(如电商的订单流程、金融的风控规则),将业务规则转化为数据清洗与转换逻辑;

- 具备数据敏感性,能识别数据异常(如重复数据、逻辑矛盾)并追溯根源。

(三)软技能

- 问题解决能力:面对数据倾斜、任务失败等问题,能快速定位原因并制定解决方案;

- 沟通协作能力:与跨部门团队协作,清晰传递技术方案与数据需求;

- 细心与耐心:ETL流程涉及大量数据处理,需确保数据细节的准确性与流程稳定性。

ETL招聘流程与关键环节

企业招聘ETL工程师通常遵循“需求分析—简历筛选—笔试—面试—Offer沟通—入职”的流程,其中面试环节为核心,需重点考察技术深度与业务适配性。

(一)需求明确与岗位JD撰写

HR与技术负责人需共同明确岗位需求:是偏传统批处理还是实时流处理?是否需要云平台经验?业务领域(如零售、医疗)是否有特殊要求?岗位JD应清晰列出技术栈、职责范围及加分项(如大数据量项目经验、数据血缘工具使用)。

(二)简历筛选关键词

重点关注候选人的项目经验(如“处理TB级数据量”“设计实时ETL pipeline”)、技术关键词(Spark、Flink、Airflow、SQL优化)及职业稳定性(避免频繁跳槽)。

(三)笔试与面试设计

- 笔试:包含SQL题(如“根据用户订单表计算月度复购率”)、ETL场景题(如“如何处理数据源中的脏数据”)、编程题(如用Python实现数据去重与格式转换)。

- 面试:

- 技术面:深入考察技术原理(如“Spark的宽窄依赖区别”“Kafka消费者组机制”)、项目细节(如“项目中遇到的性能问题及解决方法”);

- 业务面:模拟业务场景(如“如何设计用户行为数据的ETL流程”),评估候选人的业务理解与方案设计能力;

- HR面:关注职业规划、团队协作意识及对数据合规性的重视程度。

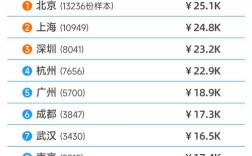

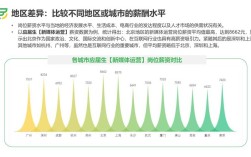

(四)Offer谈判与入职引导

针对优秀候选人,需明确技术成长路径(如向大数据架构师方向发展)、薪酬结构(基本工资+绩效奖金+项目奖金)及团队文化,入职后安排导师制,帮助候选人快速熟悉业务系统与数据规范。

ETL招聘的行业趋势与挑战

(一)趋势

- 实时化与流批一体:传统批处理ETL逐渐向实时流处理(如Flink Kappa架构)演进,企业倾向招聘具备“批流一体”技术栈的工程师;

- 云原生与Serverless:云数据服务(如AWS Glue、Azure Serverless ETL)降低运维成本,熟悉无服务器ETL的候选人更受青睐;

- 数据治理与智能化:数据血缘(如Apache Atlas)、数据质量监控(如Great Expectations)成为ETL流程的必备环节,招聘中重视候选人对数据治理工具的掌握;

- 跨领域技能融合:ETL工程师需兼具数据建模、机器学习特征处理能力(如为模型训练提供高质量数据集)。

(二)挑战

- 技术栈更新快:候选人需持续学习新工具(如Iceberg、Hudi),企业需平衡“经验丰富”与“技术前沿性”的矛盾;

- 复合型人才稀缺:既懂ETL技术又理解业务场景的候选人较少,企业可通过内部培养(如让分析师参与ETL设计)弥补;

- 数据安全合规:金融、医疗等行业对数据隐私要求严格,招聘中需重点考察候选人对数据脱敏、加密、审计的实践经验。

相关问答FAQs

Q1:ETL工程师与数据开发工程师的区别是什么?

A:ETL工程师专注于数据从源到目标的“提取-转换-加载”流程,核心是确保数据流转的稳定性、准确性与效率,更偏向数据集成与管道搭建;数据开发工程师职责范围更广,除ETL外,还可能涉及数据建模、数据服务开发(如API)、数据可视化支持等,需更深入的业务理解与全链路数据能力,ETL是数据开发的子集,但两者在实际工作中常有重叠。

Q2:企业招聘ETL工程师时,更看重经验还是技术学习能力?

A:需根据企业阶段与岗位需求综合判断,对于成熟企业或有复杂数据场景(如金融风控、实时推荐)的岗位,优先选择具备3年以上ETL项目经验、熟悉行业业务逻辑的候选人,能快速落地并解决实际问题;对于初创企业或技术转型期团队,技术学习能力(如掌握Spark/Flink等新工具的速度、对分布式原理的理解)更为关键,这类候选人可伴随企业成长,搭建符合未来需求的数据架构,理想情况下,兼具相关经验与强学习能力的候选人最受青睐。