在当今数据驱动的商业环境中,企业对数据整合与分析的需求日益迫切,ETL(Extract-Transform-Load,提取、转换、加载)作为数据治理和商业智能的核心环节,其专业人才的招聘成为企业数据团队建设的关键,ETL工程师负责设计、开发和维护数据管道,确保数据从源系统到目标系统的准确、高效流转,是连接业务数据与价值挖掘的重要桥梁,本文将从ETL岗位的核心职责、能力要求、招聘策略及行业趋势等方面展开详细分析,为企业招聘高质量ETL人才提供参考。

ETL岗位的核心职责与能力模型

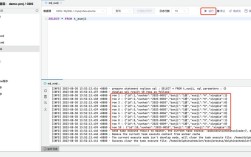

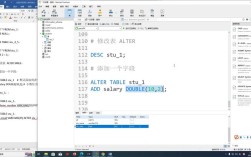

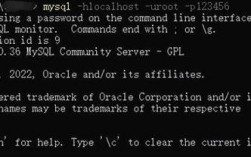

ETL工程师的工作贯穿数据生命周期的多个阶段,其核心职责包括需求分析、架构设计、开发实施、运维优化等,具体而言,需深入理解业务需求,设计合理的数据模型和ETL流程;使用专业工具(如Informatica、DataStage、Kettle、Flink、Spark等)编写数据抽取脚本,处理结构化、半结构化及非结构化数据;通过数据清洗、转换、校验等操作保障数据质量,解决数据格式不一致、缺失值、异常值等问题;最终将处理后的数据加载至数据仓库、数据湖或目标业务系统,并监控ETL任务的执行效率与稳定性,及时排查故障,随着实时数据处理需求的增长,ETL工程师还需掌握流式计算技术,设计批流一体的数据处理架构。

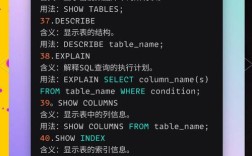

在能力要求上,ETL工程师需兼具技术深度与业务理解能力,技术层面,需熟练掌握SQL语言及数据库原理(如MySQL、Oracle、PostgreSQL等),熟悉至少一种ETL工具或大数据框架(如Hadoop、Spark、Flink、Kafka等),具备Python/Java/Scala等编程语言的开发能力,了解数据建模方法(如星型模型、雪花模型)及数据质量管理工具;业务层面,需快速理解不同行业的数据业务逻辑,如金融领域的风控指标、零售行业的用户画像等,确保数据方案贴合实际需求;软技能方面,需具备较强的逻辑思维能力、问题解决能力及跨团队协作能力,能够与数据分析师、数据科学家及业务部门高效沟通。

ETL人才招聘的关键策略

企业在招聘ETL人才时,需结合自身业务规模、数据架构及技术栈,制定差异化的招聘策略,明确岗位定位,对于初创企业或中小型团队,可侧重招聘“全栈型”ETL人才,要求具备从需求调研到系统上线的全流程经验,能够灵活应对多场景需求;对于大型企业或数据成熟度较高的组织,则可细分招聘方向,如实时ETL开发工程师、数据治理工程师等,要求候选人具备特定领域的深耕经验,如金融数据合规、实时数仓建设等。

优化招聘渠道,技术招聘平台(如LinkedIn、拉勾网、Boss直聘)是触达ETL候选人的主要渠道,可精准筛选具备相关技能标签的候选人;可通过行业技术社区(如GitHub、CSDN、Stack Overflow)挖掘开源项目贡献者,或参与数据领域的技术沙龙、招聘会,直接接触具备实战经验的人才,内部推荐也是高效渠道,通过鼓励员工推荐同行,可快速获取与企业文化匹配的候选人。

在面试环节,需设计多维度考核内容,技术面试可通过编程题(如SQL优化、Python脚本开发)、场景题(如设计用户行为数据的ETL流程、处理数据倾斜问题)考察候选人的实操能力;业务面试则结合企业实际案例,评估候选人对数据业务的理解深度;价值观面试可关注候选人对数据质量重要性的认知、团队协作意识等,对于中高级岗位,还可增加系统设计环节,要求候选人设计大规模数据集成架构,考察其技术规划能力。

ETL人才的市场趋势与发展方向

随着云计算、大数据、人工智能技术的融合,ETL领域正经历深刻变革,传统ETL工具逐渐向云原生平台迁移,如AWS Glue、Azure Data Factory、阿里云DataWorks等云服务,降低了企业数据集成的技术门槛,要求ETL工程师掌握云原生工具的使用及Serverless架构设计;实时数据处理需求激增,Flink、Spark Streaming等流计算技术成为ETL场景的重要补充,“批流一体”的数据处理架构成为主流,推动ETL工程师向实时数据开发方向转型。

数据治理与数据安全的重要性日益凸显,ETL流程中需嵌入数据血缘追踪、元数据管理、数据脱敏等环节,要求候选人熟悉数据治理框架(如DAMA-DMBOK)及相关工具(如Apache Atlas、Great Expectations),ETL工程师需不断学习新技术,如AI驱动的数据清洗、自动化ETL流程编排等,向“数据架构师”或“数据工程师”综合角色发展,以适应企业对数据价值的深度挖掘需求。

相关问答FAQs

Q1:企业在招聘ETL工程师时,应优先考虑候选人的技术工具经验还是业务理解能力?

A:技术工具经验与业务理解能力并非对立,需根据企业阶段权衡,对于初创企业或业务场景复杂的企业,业务理解能力更为关键,候选人需快速理解数据背后的业务逻辑,设计贴合实际需求的ETL方案;对于技术驱动型企业或数据基础设施成熟的企业,技术工具经验(如熟练使用Spark Flink处理大规模数据)则更为重要,理想情况下,候选人应兼具两者:具备扎实的技术功底,同时通过业务培训快速融入企业场景,例如有零售、金融等行业经验的ETL工程师,往往能更快上手相关业务的数据整合工作。

Q2:如何判断ETL候选人的实际项目经验是否扎实?

A:可通过STAR法则(情境、任务、行动、结果)深挖项目细节,重点关注候选人在项目中遇到的具体问题及解决方案,询问“在处理XX数据源时,遇到过哪些数据质量问题?如何通过ETL流程解决?”“曾优化过哪些ETL任务?性能提升多少?”,通过量化结果(如任务运行时间缩短30%、数据准确率提升至99.9%)验证其贡献,可要求候选人展示过往项目的技术架构图或核心代码片段(如去重逻辑、数据校验规则),评估其技术规范性与代码质量,对于中高级岗位,还可设计模拟场景题,如“设计一个支持日均10亿条数据的实时ETL架构”,考察其系统设计能力与实战经验。