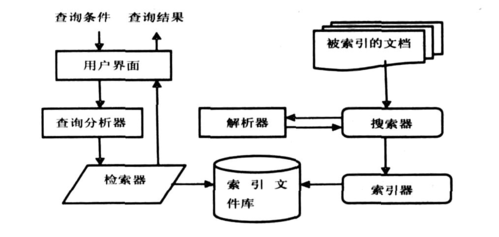

设计一个高效、精准且用户体验良好的搜索引擎是一个复杂的系统工程,涉及算法、架构、数据工程、用户交互等多个维度的深度整合,其核心目标是在用户输入查询后,能够在极短时间内从海量数据中检索出最相关、最有价值的结果,并以清晰有序的方式呈现,以下从关键技术模块、核心流程、优化方向等方面详细阐述搜索引擎的设计思路。

搜索引擎的基石是数据采集与处理模块,该模块负责从互联网上抓取海量网页内容,并进行清洗、去重和结构化处理,数据采集通常由分布式爬虫系统实现,爬虫需遵循robots协议,合理设置抓取频率,避免对目标网站造成过大压力,爬虫策略需动态调整,优先抓取高价值页面(如权威网站、高频更新内容),并通过URL发现机制(如解析HTML链接、sitemap等)不断扩展抓取范围,抓取到的原始数据需经过预处理,包括去除HTML标签、提取文本内容、处理乱码等,并通过内容去重算法(如SimHash、MinHash)剔除重复或高度相似页面,确保索引库的唯一性和高效性,预处理后的数据进一步进行分词处理,这是中文搜索引擎的关键环节,需结合词典匹配、统计模型(如隐马尔可夫模型)和深度学习模型(如BERT),将连续文本切分为有意义的词语单元,并识别词性、命名实体(如人名、地名),为后续索引构建提供基础。

数据预处理完成后,进入索引构建阶段,这是决定检索效率的核心环节,传统搜索引擎多采用倒排索引结构,其核心是“词典-倒排列表”的映射关系:词典记录所有出现的词语,每个词语对应一个倒排列表,列表中包含包含该词语的所有文档ID以及该词语在文档中的位置、权重等信息,倒排索引的构建需考虑存储效率和查询速度的平衡,例如通过压缩技术(如变长编码、位图压缩)减少索引体积,通过缓存热点索引数据加速高频词查询,对于大规模数据,分布式索引架构是必然选择,可将索引分片(Sharding)存储在不同节点,通过一致性协议(如Paxos、Raft)保证数据同步,并通过负载均衡策略分散查询压力,现代搜索引擎还引入了正排索引(文档到词语的映射),用于快速获取文档的完整信息,常与倒排索引配合使用,近年来,基于深度学习的稠密向量索引(如HNSW、FAISS)逐渐兴起,通过将文档和查询表示为低维向量,利用向量相似度计算实现语义检索,弥补了传统关键词匹配的语义鸿沟。

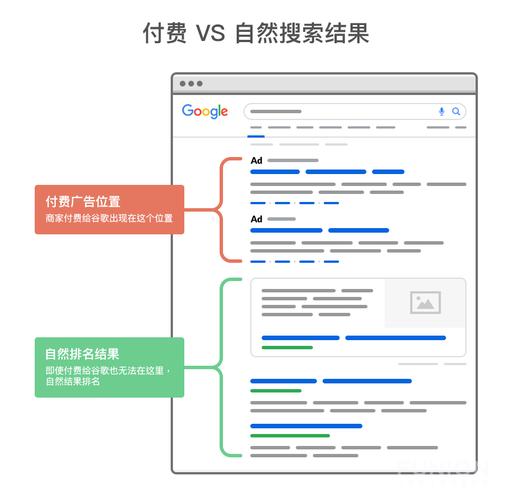

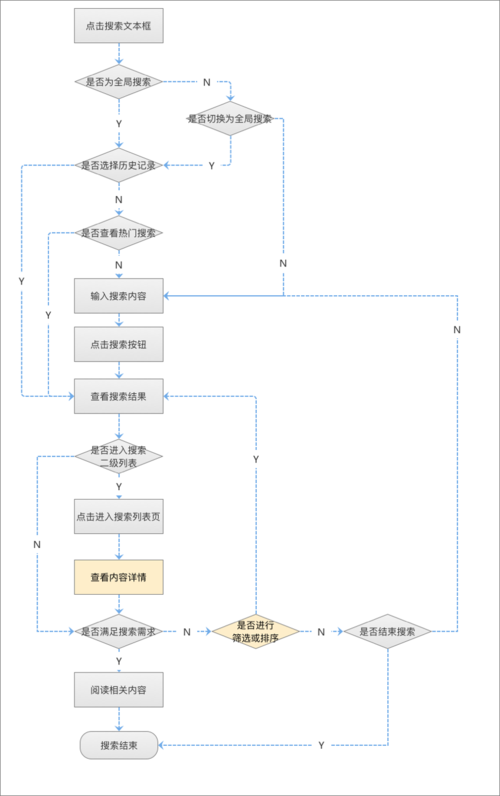

当用户输入查询时,搜索引擎进入查询处理与排序阶段,这是决定结果质量的关键,查询处理首先对用户输入进行分词、纠错(如拼写纠错、同义词扩展)、查询意图识别(如区分信息查询、导航查询、交易查询),并通过查询扩展技术(如基于语义的相关词推荐、基于日志的查询纠错)优化查询语句,随后,系统在倒排索引中快速定位与查询相关的文档集合,并通过初步筛选(如布尔匹配、TF-IDF权重过滤)缩小候选范围,核心环节是相关性排序,传统排序算法如BM25、PageRank仍被广泛应用,BM25通过考虑词频、文档长度等因素计算查询与文档的相关性分数,PageRank则通过分析网页间的链接关系评估权威性,现代搜索引擎普遍采用机器学习排序模型,如LambdaMART、GBDT,以及基于深度学习的排序模型(如DeepFM、BERT),这些模型通过学习海量用户行为数据(如点击、停留时长、跳出率)和文档特征(内容质量、时效性、用户偏好),训练出更精准的排序函数,排序过程中还需考虑多样性(避免结果单一化)、新鲜度(优先展示最新内容)、地域化(根据用户位置调整结果)等维度,最终生成有序的搜索结果列表。

除了核心技术模块,搜索引擎的架构设计也至关重要,为应对高并发和海量数据,分布式架构是基础,可采用微服务模式将爬虫、索引、排序、服务等模块解耦,通过消息队列(如Kafka)实现模块间异步通信,提高系统容错性和扩展性,存储层需结合分布式文件系统(如HDFS)和分布式数据库(如Cassandra、Elasticsearch),实现数据的高可靠性和高可用性,缓存策略也必不可少,通过多级缓存(如本地缓存、分布式缓存CDN)缓存热点查询和热门文档,减少后端负载,搜索引擎需建立完善的监控和运维体系,实时监控系统性能(如响应时间、吞吐量)、数据质量(如索引更新延迟、抓取成功率)和用户反馈(如点击率、投诉率),及时发现并解决问题。

用户体验优化是搜索引擎设计的另一重点,搜索结果的展示需简洁明了,通过摘要生成技术(如关键句提取、高亮显示)突出文档与查询的相关内容,并辅以缩略图、评分等辅助信息帮助用户快速判断,针对不同查询场景,可设计特色功能,如知识图谱展示(直接呈现结构化答案)、语音搜索、图像搜索等,搜索引擎需严格遵守隐私保护法规,对用户数据进行脱敏处理,并提供个性化设置选项(如关闭个性化推荐),增强用户信任。

相关问答FAQs:

-

问:搜索引擎如何处理新出现的网络热词或专业术语?

答:搜索引擎处理新词通常结合多种技术:一是通过爬虫实时抓取社交媒体、新闻等高频出现新词的文本,利用新词发现算法(如基于字共现频率、未登录词识别)自动识别候选新词;二是通过用户查询日志分析,当某个词的查询量突然激增时,触发人工审核或模型验证流程;三是引入动态更新机制,定期将验证通过的新词加入词典,并更新分词模型和索引,对于专业术语,还可通过构建领域知识图谱、与专业机构合作等方式,提升术语识别的准确性和上下文理解能力。 -

问:为什么搜索结果中有时会出现与查询意图不符的内容?如何优化?

答:原因主要包括:查询理解偏差(如用户表述模糊、歧义)、排序模型局限性(特征覆盖不全、训练数据偏差)、数据质量问题(网页内容低质、作弊)等,优化方向包括:一是加强查询理解,通过上下文分析、多轮对话交互明确用户真实意图;二是优化排序模型,引入更多维度特征(如用户历史行为、内容可信度指标),结合在线学习算法持续迭代模型;三是加强反作弊机制,识别并过滤垃圾内容;四是建立用户反馈闭环,通过点击率、无点击率、用户投诉等数据定位问题,针对性调整算法策略。 (图片来源网络,侵删)

(图片来源网络,侵删)