在Hadoop生态系统中,grep命令是一种常用的文本过滤工具,主要用于从大数据集中提取符合特定模式的行,虽然Hadoop本身没有直接名为“grep”的独立命令,但可以通过Hadoop的Streaming功能或结合MapReduce实现类似grep的功能,以下将详细介绍Hadoop中grep命令的实现原理、使用方法及实际应用场景。

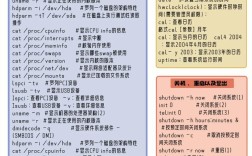

Hadoop Streaming是Hadoop提供的一个工具,允许用户使用任何可执行文件或脚本作为Mapper和Reducer,从而方便地处理文本数据,要实现grep功能,通常只需编写一个简单的Shell脚本作为Mapper,该脚本使用系统的grep命令过滤输入数据,具体步骤如下:准备一个Mapper脚本,例如grep_mapper.sh为grep 'pattern',pattern'是要匹配的关键字,使用Hadoop Streaming命令提交任务,格式为hadoop jar hadoop-streaming.jar -input /input/path -output /output/path -mapper grep_mapper.sh -file grep_mapper.sh,这里-file参数用于将脚本分发到各个节点,确保Mapper可以正常运行。

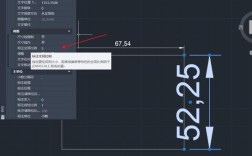

除了通过Hadoop Streaming实现grep功能,还可以直接在MapReduce框架中编写自定义的Mapper类,这种方法的优势在于性能更高,且可以更灵活地处理复杂逻辑,在Java Mapper中,可以通过context.write()方法输出符合条件的行,具体实现时,Mapper类会读取输入的每行数据,使用正则表达式或字符串匹配方法判断是否包含目标模式,若匹配则将该行写入上下文,这种方法适用于需要大规模数据处理且对性能要求较高的场景。

在实际应用中,Hadoop grep命令常用于日志分析、数据清洗和模式提取,在Web服务器日志分析中,可以使用grep过滤出包含特定错误码的行,以便进一步分析问题原因,在电商数据中,可以通过grep提取包含特定商品关键词的用户评论,用于情感分析,需要注意的是,Hadoop中的grep操作通常与分布式文件系统(HDFS)紧密结合,输入数据存储在HDFS上,输出结果也会写入HDFS,从而实现分布式处理。

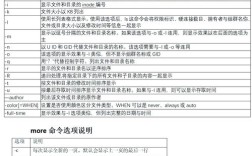

为了更高效地使用Hadoop grep命令,可以结合一些优化技巧,合理设置Map任务的数量,可以通过-numMapTasks参数调整,以平衡负载和提高并行度,对于大文件,建议先进行分片(Splitting),确保每个Map任务处理的数据量大致相当,如果过滤条件较为复杂,可以考虑使用Combiner来减少网络传输的数据量,Combiner可以在Map阶段对局部结果进行预聚合,类似于Reducer的功能。

以下是一个通过Hadoop Streaming实现grep的示例,假设要过滤包含“ERROR”的日志行:

- 创建Mapper脚本

error_grep.sh为grep 'ERROR'。 - 将脚本上传到HDFS或本地节点。

- 执行命令:

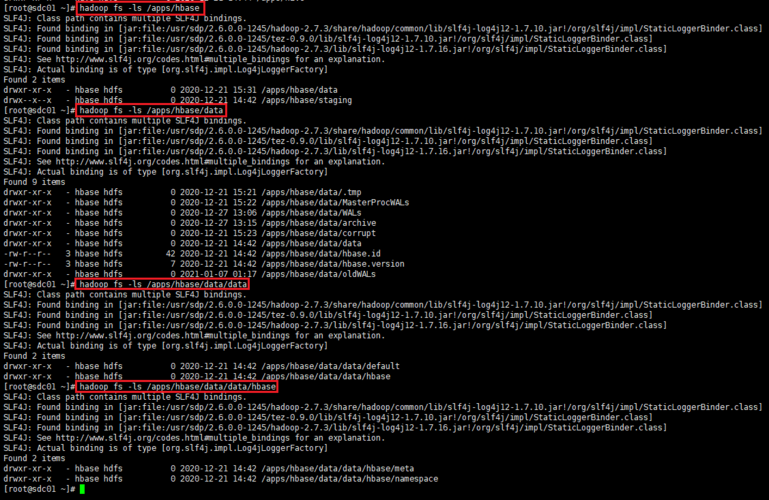

hadoop jar hadoop-streaming.jar -input /logs -output /error_logs -mapper error_grep.sh -file error_grep.sh。 执行后,结果将存储在/error_logs目录下,包含所有包含“ERROR”的行。

需要注意的是,Hadoop grep命令的性能受多种因素影响,包括数据量、集群资源、过滤条件的复杂度等,对于极大规模的数据集,可能需要结合其他工具(如Hive、Pig)或使用更高效的分布式计算框架(如Spark)来实现类似功能,grep命令是区分大小写的,如果需要不区分大小写的匹配,可以在脚本中使用grep -i 'pattern'。

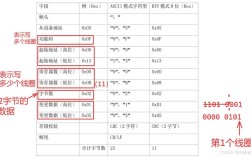

在实际操作中,可能会遇到一些常见问题,如果输入数据是压缩格式(如.gz或.bz2),需要先解压或使用支持压缩的输入格式,如果过滤条件涉及正则表达式,需确保脚本中的正则语法正确,避免因特殊字符导致匹配失败,输出目录不能已存在,否则任务会失败,需提前删除或使用-overwrite参数覆盖。

相关问答FAQs:

-

问题:Hadoop Streaming实现grep时,如何处理输入文件的压缩格式?

解答:如果输入文件是压缩格式(如.gz),可以在Hadoop Streaming命令中使用-inputformat参数指定对应的输入格式,例如-inputformat org.apache.hadoop.mapred.lib.CombineTextInputFormat,或者先在Mapper脚本中使用zcat或gunzip命令解压数据,确保Hadoop集群支持对应的压缩编解码器。 -

问题:为什么Hadoop grep任务执行时出现“Output directory already exists”错误?

解答:该错误表示输出目录已存在,Hadoop不允许覆盖已存在的输出目录,解决方法有两种:一是手动删除输出目录(hadoop fs -rm -r /output/path),二是在命令中使用-overwrite参数(hadoop jar hadoop-streaming.jar ... -overwrite),强制覆盖已存在的输出目录。