在Linux或Unix系统中,卸载Hadoop需要谨慎操作,确保彻底删除安装文件、配置文件、数据目录以及相关的环境变量配置,避免残留文件影响系统或其他大数据组件的运行,以下是详细的卸载步骤及注意事项,涵盖不同场景下的操作方法。

卸载前的准备工作

-

停止Hadoop相关服务

在卸载前,必须确保所有Hadoop进程已完全停止,避免文件被占用导致删除失败,进入Hadoop安装目录的sbin文件夹,执行以下命令:./stop-dfs.sh ./stop-yarn.sh

若启用了Hadoop历史服务器或日志聚合服务,还需额外停止:

mr-jobhistory-daemon.sh stop historyserver

-

确认Hadoop安装路径

通过which hadoop或echo $HADOOP_HOME命令确认Hadoop的安装目录,常见的默认路径为/usr/local/hadoop或/opt/hadoop。 -

备份重要数据

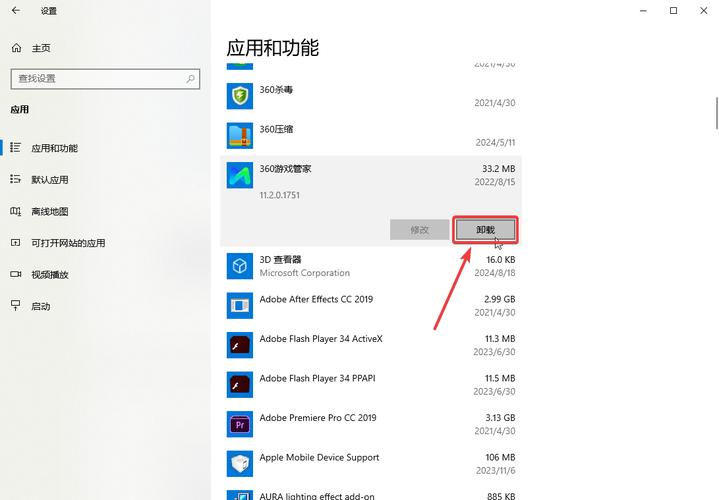

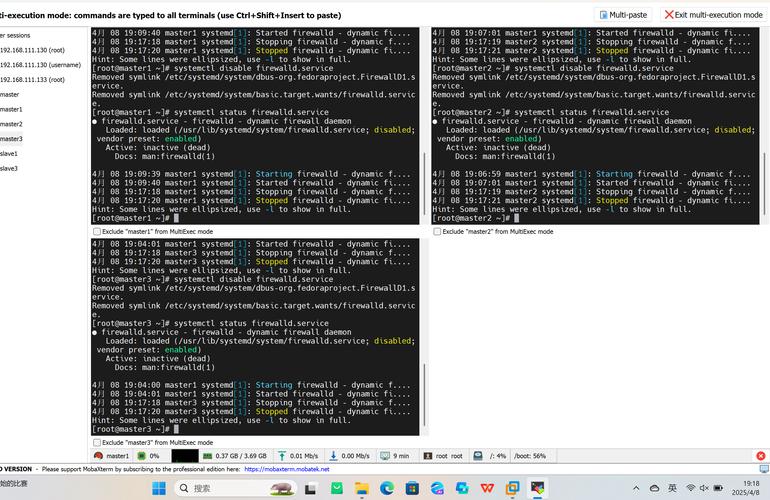

如果Hadoop数据目录(如/tmp/hadoop-username或$HADOOP_HOME/data)中存在需要保留的数据,提前备份到其他位置,避免误删。 (图片来源网络,侵删)

(图片来源网络,侵删)

完全卸载Hadoop的步骤

删除Hadoop安装目录

使用rm -rf命令强制删除Hadoop的安装目录,假设安装路径为/usr/local/hadoop:

sudo rm -rf /usr/local/hadoop

若安装路径为用户目录(如~/hadoop),则无需sudo权限:

rm -rf ~/hadoop

删除Hadoop数据目录和日志文件

Hadoop的数据和日志通常存储在以下位置,需手动清理:

- 数据目录:默认为

/tmp/hadoop-${USER}(由core-site.xml中的hadoop.tmp.dir配置决定)。 - 日志目录:

$HADOOP_HOME/logs或系统日志目录(如/var/log/hadoop)。sudo rm -rf /tmp/hadoop-$(whoami) # 删除临时数据目录 sudo rm -rf /var/log/hadoop # 删除系统日志目录(若存在)

清理环境变量配置

编辑用户环境变量配置文件(如~/.bashrc或~/.profile),删除Hadoop相关的环境变量设置:

vim ~/.bashrc

找到并删除以下内容(具体路径需根据实际配置调整):

export HADOOP_HOME=/usr/local/hadoop export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

保存后执行source ~/.bashrc使配置生效。

清理系统级配置文件

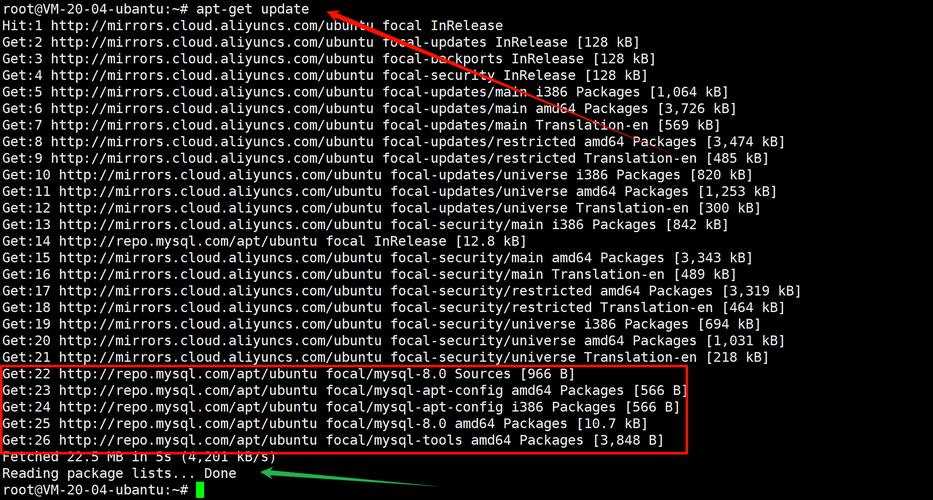

若Hadoop通过系统包管理器(如apt或yum)安装,需彻底卸载相关包:

- 基于Debian/Ubuntu系统:

sudo apt-get --purge remove hadoop-* # 卸载Hadoop相关包 sudo apt-get autoremove # 自动清理依赖 sudo apt-get clean # 清理缓存

- 基于RHEL/CentOS系统:

sudo yum remove hadoop-* # 卸载Hadoop相关包 sudo yum autoremove # 自动清理依赖

删除Hadoop用户和用户组(可选)

如果Hadoop是专用用户和组创建的,可通过以下命令删除(需确保该用户无其他服务依赖):

sudo userdel -r hadoop # 删除hadoop用户及其家目录 sudo groupdel hadoop # 删除hadoop用户组

清理其他相关文件

- Hadoop配置文件残留:检查

/etc/hadoop或/etc/hadoop/conf目录,删除残留配置。 - 启动脚本残留:若手动创建了Hadoop启动脚本(如

/usr/local/bin/hadoop-start),需手动删除。 - 系统服务残留:若将Hadoop注册为系统服务(通过

systemd或init.d),需删除服务文件并禁用服务:sudo systemctl stop hadoop-namenode # 停止服务(示例) sudo systemctl disable hadoop-namenode sudo rm /etc/systemd/system/hadoop-namenode.service # 删除服务文件 sudo systemctl daemon-reload # 重载systemd配置

验证卸载结果

执行以下命令确保Hadoop已完全卸载:

- 检查环境变量是否生效:

echo $HADOOP_HOME # 应无输出 which hadoop # 应提示“hadoop not found”

- 检查进程是否停止:

jps # 应无NameNode、DataNode等进程

- 检查目录是否删除:

ls -l /usr/local/hadoop # 应提示“No such file or directory”

常见问题及注意事项

-

权限不足导致删除失败

删除系统级目录(如/usr/local/hadoop)时需使用sudo,若仍提示权限错误,可检查目录所有者:sudo chown -R $USER:$USER /usr/local/hadoop # 修改所有者为当前用户

或直接使用

sudo rm -rf强制删除。 -

卸载后仍残留进程

若jps命令仍显示Hadoop进程,可通过ps -ef | grep hadoop查找进程PID,并用kill -9 <PID>强制终止。 -

环境变量未清理干净

若切换用户后仍提示Hadoop相关命令,需检查全局配置文件(如/etc/profile)或其他Shell配置文件(如~/.zshrc)。 -

多版本Hadoop冲突

若系统曾安装多个Hadoop版本,需确保删除的是目标版本,避免误删其他版本的可执行文件或配置。

相关问答FAQs

问题1:卸载Hadoop后,重新安装时遇到端口冲突怎么办?

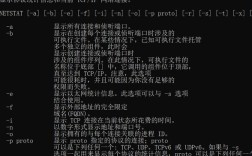

解答:端口冲突通常因旧进程残留或未释放端口导致,首先检查是否有Hadoop进程残留(jps),若有则强制终止,检查core-site.xml和hdfs-site.xml中的端口配置(如fs.defaultFS默认为9000,dfs.namenode.address默认为9000),确保与当前系统未占用端口一致,可通过netstat -tlnp | grep :端口号查看端口占用情况,若被占用则修改配置或停止占用端口的进程。

问题2:卸载Hadoop后,如何彻底清理Hadoop相关的YARN队列或资源调度配置?

解答:YARN的队列配置通常存储在yarn-site.xml和capacity-scheduler.xml中,卸载Hadoop时这些配置文件会被一同删除,但若使用第三方资源调度工具(如Fair Scheduler),还需手动清理以下内容:

- 删除YARN的配置目录(如

$HADOOP_HOME/etc/hadoop/yarn-site.xml)。 - 清理

~/.hadoop或~/.yarn目录下的用户配置缓存。 - 若集群使用ResourceManager的Web UI历史记录,需删除

yarn.nodemanager.remote-app-log-dir指定的日志目录。 - 对于Kerberos认证的集群,还需清理

/etc/security/keytabs/下的Hadoop相关密钥文件。