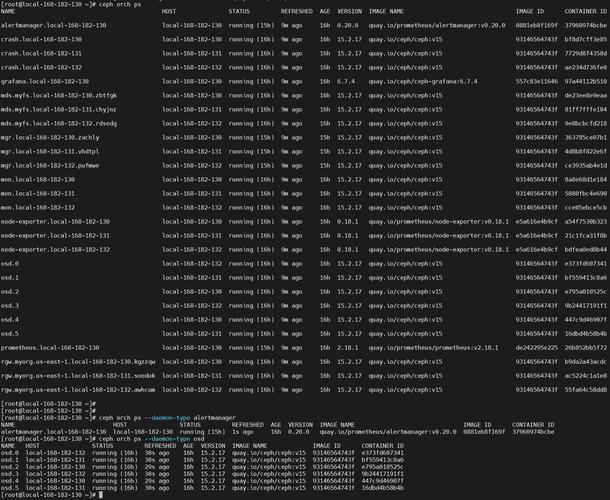

ceph运维命令是管理和维护Ceph分布式存储系统的重要工具,涵盖了集群状态监控、存储池管理、OSD(对象存储设备)维护、MON(监控节点)管理以及数据恢复等多个方面,熟练掌握这些命令能够帮助运维人员快速定位问题、优化集群性能并确保数据可靠性,以下从常用场景出发,详细介绍核心运维命令及其使用方法。

在集群状态监控方面,ceph -s是最基础的命令,用于查看集群整体健康状况,包括健康状态(HEALTH_OK/HEALTH_WARN/HEALTH_ERR)、OSD数量、MON数量、存储池使用情况以及数据分布均衡度,若需更详细的状态信息,可使用ceph detail,它会输出各组件的详细配置和状态,对于监控数据,ceph -w可实时监控集群事件变化,如OSD上下线、PG(Placement Group)状态迁移等,适合问题排查时使用。ceph health detail能展示健康警告的具体原因,OSD down"或"PG degraded"等,帮助快速定位故障点。

存储池管理是日常运维的重点,创建存储池可通过ceph osd pool create <pool_name> <pg_num>完成,其中pg_num需根据集群规模合理设置,避免过多或过少影响性能,查看存储池列表使用ceph osd lspools,而ceph df命令则能显示各存储池的已用空间、总空间及对象数量,若需调整存储池参数,如副本数,可通过ceph osd pool set <pool_name> size <replica_num>实现,例如将存储池"test_pool"的副本数设置为3,删除存储池时需谨慎,使用ceph osd pool delete <pool_name> <pool_name> --yes-i-really-really-mean-it,命令中的重复参数和确认选项是为了防止误操作。

OSD作为数据存储的核心组件,其维护命令尤为重要,查看OSD状态使用ceph osd tree,以树状结构展示OSD的ID、类型(host、osd等)及权重,若某个OSD故障,需先标记其状态为out,通过ceph osd out <osd_id>,然后检查日志确认故障原因,若为硬件问题则需更换磁盘,完成后使用ceph osd in <osd_id>将其重新加入集群,对于OSD的CRUSH(Controlled Replication Under Scalable Hashing)规则管理,ceph osd crush rule list可查看规则列表,ceph osd crush rule create-simple <rule_name> <root> <failure_domain> <type>可创建新规则,例如指定故障域为host以提升数据可靠性。

MON节点管理相对简单,但至关重要,查看MON状态使用ceph mon stat,输出当前MON数量、leader及选举状态,若需添加MON节点,需先在配置文件中添加新MON的IP和端口,然后使用ceph mon add <mon_id> <mon_ip> <mon_port>,最后将新MON的keyring同步到所有节点,删除MON节点时,需确保集群仍有足够MON(建议为奇数个),使用ceph mon remove <mon_id>,并清理相关配置文件和数据目录。

数据恢复与故障处理是运维中的难点,当出现"PG degraded"时,可通过ceph pg <pg_id> query查看PG的详细信息,定位丢失的对象或OSD,若需强制恢复数据,可使用ceph osd recovery <osd_id>手动触发OSD的数据恢复流程,对于数据一致性检查,ceph osd pool scrub <pool_name>可对存储池进行深度校验,确保数据完整性,但该命令会消耗较多IO资源,建议在业务低峰期执行。

| 功能分类 | 常用命令 | 说明 |

|---|---|---|

| 集群状态监控 | ceph -s |

查看集群整体状态,包括健康状态、OSD/MON数量、存储池使用情况 |

ceph health detail |

显示健康警告的具体原因,如OSD故障、PG异常等 | |

| 存储池管理 | ceph osd pool create <pool_name> <pg_num> |

创建存储池,需指定PG数量 |

ceph osd pool set <pool_name> size <replica_num> |

修改存储池副本数,如设置为3副本 | |

| OSD维护 | ceph osd tree |

查看OSD树状结构,包含ID、类型及权重 |

ceph osd out <osd_id> |

标记OSD为out状态,准备下线维护 | |

| MON管理 | ceph mon stat |

查看MON节点状态,包括数量及leader信息 |

ceph mon add <mon_id> <mon_ip> <mon_port> |

添加新的MON节点 | |

| 数据恢复与故障处理 | ceph pg <pg_id> query |

查看特定PG的详细信息,定位数据丢失问题 |

ceph osd pool scrub <pool_name> |

对存储池进行深度数据校验,确保数据完整性 |

相关问答FAQs

Q1: 如何判断Ceph集群是否存在性能瓶颈?

A1: 可通过以下命令综合判断:1)ceph -s查看集群整体负载,若"pgs"状态显示"active+clean"且无警告,说明基本正常;2)ceph osd perf查看OSD的IOPS、带宽延迟等指标,若某OSD的延迟显著高于其他节点,可能存在瓶颈;3)ceph df分析存储池使用率,若接近阈值(如85%),需及时扩容;4)ceph -w实时监控事件,若频繁出现"backfilling"或"recovering",说明集群处于高负载状态,需优化或扩容。

Q2: Ceph集群出现"OSD down"告警后,如何快速恢复?

A2: 恢复步骤如下:1)使用ceph osd tree确认故障OSD的ID;2)通过ceph daemon <osd_id> logs查看OSD日志,定位故障原因(如磁盘损坏、网络异常);3)若为硬件问题,更换磁盘后使用ceph osd repair <osd_id>修复OSD数据;4)若为软件或配置问题,重启OSD服务(systemctl restart ceph-osd@<osd_id>);5)使用ceph osd in <osd_id>将OSD重新加入集群,并观察ceph -s直至状态恢复为"active+clean",若集群存在副本不足问题,需及时使用ceph osd pool set <pool_name> size <replica_num>调整副本数。