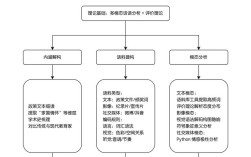

如何自己做搜索网站是一个涉及技术、资源和运营的系统工程,需要从需求分析、技术选型、数据获取、算法优化到用户界面设计等多个维度进行规划,以下是详细的步骤和注意事项,帮助理解从零构建搜索网站的核心流程。

明确需求与定位

在开始技术实现前,首先要明确搜索网站的定位和目标用户,是通用搜索引擎(如Google、百度),还是垂直领域搜索引擎(如学术搜索、电商搜索、新闻搜索)?垂直领域的需求更聚焦,技术复杂度相对较低,适合初创团队或个人开发者,若要做学术搜索,需聚焦论文、期刊、文献等特定数据;若做电商搜索,则需整合商品信息、价格、评价等数据,定位清晰后,才能确定后续的技术方向和数据来源。

技术架构搭建

搜索网站的核心技术架构通常包括数据采集层、数据处理层、索引层、查询层和展示层,各层职责如下:

数据采集层(爬虫系统)

数据是搜索引擎的“燃料”,需通过爬虫程序从互联网获取目标数据。

- 爬虫框架选择:可使用Python的Scrapy、BeautifulSoup,或Java的Nutch、Heritrix等开源框架,Scrapy灵活性高,适合快速开发;Nutch适合大规模分布式爬取。

- 爬取策略:需定义爬取范围(如允许的域名、URL过滤规则)、爬取频率(避免对目标网站造成压力)、反爬机制处理(如User-Agent轮换、IP代理池、验证码识别)。

- 数据存储:原始爬取数据可暂存于MongoDB、Elasticsearch等非关系型数据库,便于后续处理。

数据处理层

原始数据需经过清洗、去重、结构化处理后才能用于索引。

- 数据清洗:去除HTML标签、提取正文内容、过滤广告和无关信息。

- 去重处理:通过SimHash、MD5等算法计算文档指纹,剔除重复内容。

- 分词与提取:中文需使用分词工具(如Jieba、HanLP),英文可使用NLTK;提取关键词、分类标签等结构化信息。

索引层

索引是搜索效率的核心,需将处理后的数据构建为可快速检索的结构。

- 索引库选择:常用开源搜索引擎库包括Elasticsearch、Solr、Whoosh等,Elasticsearch基于Lucene,支持分布式存储和高并发查询,是目前的主流选择;Whoosh轻量级,适合纯Python开发的小型项目。

- 索引结构:设计字段映射(如标题、内容、URL、时间戳等),定义分词器(中文需使用IK分词器等)、索引类型(如全文索引、数值索引)。

- 索引更新:需支持增量索引(仅更新新增或修改的数据)和全量索引(定期重建索引),确保数据时效性。

查询层

用户输入查询词后,系统需快速返回相关结果。

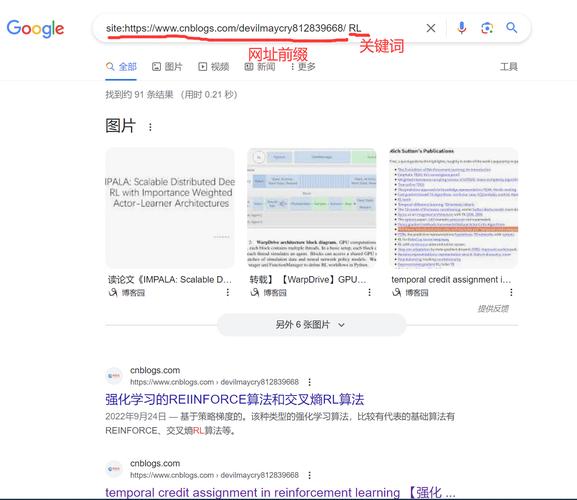

- 查询解析:对用户输入进行分词、纠错(如拼音转汉字、错字纠正)、查询扩展(如同义词、相关词推荐)。

- 检索算法:实现相关性排序,核心是TF-IDF、BM25等传统算法,或结合机器学习模型(如LR、XGBoost)进行点击率预测排序。

- 性能优化:通过缓存(如Redis)、查询结果分页、异步处理等方式提升响应速度。

展示层

用户直接交互的界面,需简洁易用且突出搜索结果。

- 前端技术:使用React、Vue等框架构建动态界面,结合HTML/CSS/JS实现响应式设计(适配PC和移动端)。

- 结果展示、URL、相关图片等信息,支持排序(如相关度、时间)、筛选(如时间范围、内容类型)等功能。

- 日志分析:记录用户查询行为(如搜索词、点击结果),用于优化查询算法和推荐策略。

关键模块实现细节

爬虫系统的反爬与合规性

爬虫需遵守目标网站的robots.txt协议(规定允许爬取的路径),避免高频请求导致IP被封禁,可使用代理IP池(如付费服务或自建代理池)、设置随机延迟(如1-3秒请求间隔)、模拟浏览器行为(如添加Cookie、处理JS渲染)等方式降低反爬风险,对于需要登录才能访问的数据,需实现模拟登录(如Selenium自动化工具)。

中文分词与索引优化

中文分词是搜索效果的关键,需选择适合领域的分词工具,通用搜索可使用Jieba,专业领域(如医疗、法律)需训练自定义分词词典,索引时,需根据字段重要性设置不同权重(如标题权重高于正文),并支持短语匹配、模糊查询(如通配符)等高级功能。

相关性排序策略

排序直接影响用户体验,需结合多种因素:

- 文本相关性:BM25算法计算查询词与文档的匹配度;

- 时效性:新闻类搜索需优先展示最新内容;

- 权威性:通过PageRank算法评估网页重要性(参考链接数量和质量);

- 用户行为:根据历史点击率、停留时长等数据优化排序(如使用协同过滤)。

测试与上线

功能测试

验证搜索准确性(如关键词匹配、纠错能力)、性能测试(如高并发下的响应时间,目标支持QPS,即每秒查询次数)、兼容性测试(不同浏览器、设备上的显示效果)。

部署方案

- 服务器选择:初期可使用云服务器(如阿里云、腾讯云),根据流量弹性配置资源;后期若数据量大,需搭建分布式集群(如Elasticsearch集群)。

- 监控与维护:使用Prometheus、Grafana等工具监控系统性能(如CPU、内存、索引大小),定期备份数据,避免因故障导致数据丢失。

运营与迭代

上线后需持续运营优化:

- 数据扩展:定期更新爬取范围,覆盖更多优质数据源;

- 算法迭代:根据用户反馈和日志数据调整排序算法,引入机器学习模型提升相关性;

- 功能迭代:增加语音搜索、图像搜索、个性化推荐等新功能,提升用户体验。

相关问答FAQs

Q1:自己做搜索网站需要投入多少成本?

A:成本因规模和技术选型差异较大,小型垂直搜索引擎(如学术搜索)初期投入约1-3万元,主要用于服务器(云服务器月费约500-2000元)、开发人员(1-2人,月薪约1-2万元)和基础数据采购(如付费API),通用搜索引擎需投入更高,包括大规模分布式集群、带宽和运维成本,通常需百万级以上资金,开源工具(如Scrapy、Elasticsearch)可降低技术成本,但人力和时间成本仍较高。

Q2:如何保证搜索结果的实时性?

A:实时性需通过索引更新策略实现,对于新闻、电商等高频更新领域,可采用“增量索引+实时推送”模式:爬虫爬取新数据后,通过消息队列(如Kafka)实时传递给索引服务,Elasticsearch的Near Real-Time(NRT)特性可在1秒内完成索引更新并支持查询;对于低频更新数据(如学术论文),可采用定时任务(如每天凌晨全量更新)平衡实时性与资源消耗,可结合缓存技术(如Redis)缓存热门查询结果,进一步提升响应速度。