ghost命令下载通常指的是通过命令行工具或脚本实现文件的批量下载、镜像复制或系统备份等操作,其核心在于利用自动化脚本减少人工干预,提高效率,以下从工具选择、命令语法、实际应用场景及注意事项等方面展开详细说明。

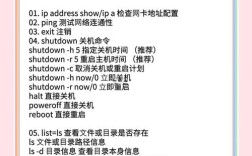

常用工具与基础语法

ghost命令下载的实现依赖于多种工具,常见包括wget、curl、rsync及专业的Ghostscript(处理PDF)等,需根据需求选择,以wget为例,其基础语法为wget [选项] URL,支持断点续传、后台下载、镜像站点等功能,例如wget -c -b http://example.com/file.zip可实现后台续传下载;wget -m --convert-links http://example.com则可镜像整个网站,若需批量下载,可结合xargs命令处理URL列表,如cat urls.txt | xargs -n 1 wget,其中urls.txt为包含多个下载链接的文本文件。

高级功能与参数配置

-

限速与并发控制

通过--limit-rate参数限制下载速度,如wget --limit-rate=100k http://example.com/largefile.iso避免占用过多带宽;使用-c参数实现断点续传,网络中断后恢复下载时不会重复下载已完成部分。 -

认证与代理设置

针对需要权限的资源,可通过--user和--password添加认证信息,如wget --user=admin --password=123 http://private-site.com/file,若需通过代理下载,使用--proxy-user和--proxy-password,或配置环境变量export http_proxy="http://proxy:port"。 -

自定义输出目录与命名

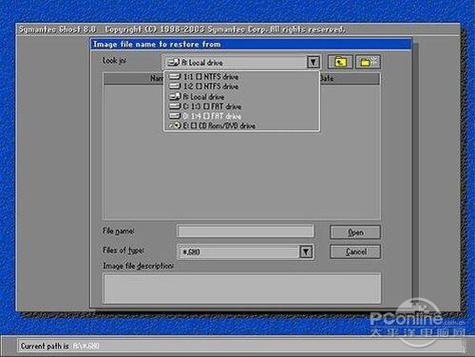

通过-P参数指定保存路径,如wget -P /downloads http://example.com/file;使用-O自定义输出文件名,如wget -O newname.zip http://example.com/oldname.zip。 (图片来源网络,侵删)

(图片来源网络,侵删)

实际应用场景示例

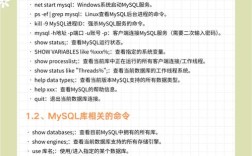

场景1:批量下载服务器日志文件

假设需批量下载FTP服务器上/logs目录下的所有日志文件,可编写脚本如下:

ftp -n <<EOF open ftp.server.com user username password cd /logs mget *.log bye EOF

或使用lftp更高效:lftp ftp.server.com -u username,password -e "cd /logs; mget *.log; exit"。

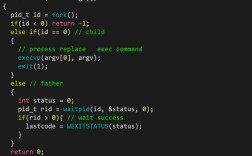

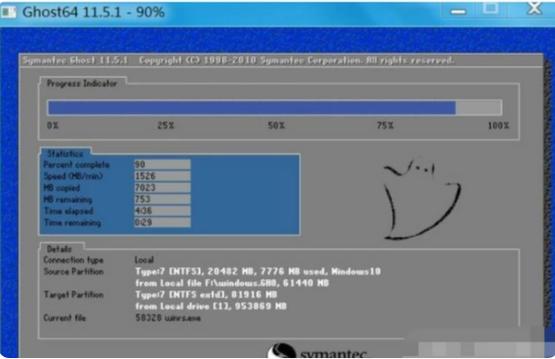

场景2:本地磁盘镜像备份

使用dd命令制作磁盘镜像(需root权限):

dd if=/dev/sda of=/path/to/disk.img bs=4M status=progress

其中if为输入设备,of为输出文件,bs为块大小,status=progress显示实时进度。

场景3:网络资源批量下载

结合wget与grep解析网页中的下载链接:

wget -q -O - http://example.com/download-page | grep -o 'http://.*\.zip' | xargs -n 1 wget

-q -O -输出到标准输出,grep提取ZIP链接,xargs逐行传递给wget。

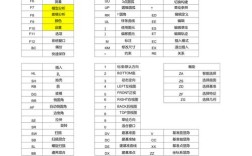

不同工具对比与选择

| 工具 | 优势 | 适用场景 |

|---|---|---|

wget |

支持HTTP/FTP/HTTPS,功能全面 | 网页资源下载、镜像站点 |

curl |

支持更多协议(如SFTP、SMTP),交互灵活 | API调用、需要实时输出的场景 |

rsync |

增量同步,高效传输大文件 | 服务器间文件同步、备份 |

dd |

底层磁盘/分区镜像,支持原始拷贝 | 系统备份、制作启动盘 |

注意事项与常见问题

- 权限问题:下载或备份操作可能需要root权限,如使用

dd操作磁盘时需确保账户有足够权限。 - 网络稳定性:大文件下载建议使用

-c参数避免网络中断导致重复下载,或结合aria2c多线程加速。 - 资源占用:批量下载时需注意服务器带宽限制,避免因并发过高导致IP被封禁。

- 数据完整性:镜像备份后需通过

sha256sum或md5sum校验文件完整性,确保数据无损坏。

相关问答FAQs

Q1: 使用wget下载时如何过滤特定扩展名的文件?

A: 可通过-A参数指定接受的扩展名,例如只下载jpg和png图片:wget -r -A "*.jpg,*.png" http://example.com/images/,其中-r表示递归下载。

Q2: 如何通过命令行下载整个网站并保留目录结构?

A: 使用wget的-m(镜像)参数结合--convert-links(转换链接为本地可用)和--page-requisites(下载依赖资源如CSS/JS),完整命令为:wget -m --convert-links --page-requisites http://example.com,即可完整下载网站并保持目录结构。