Sqoop是一款开源的工具,主要用于在Hadoop生态系统和关系型数据库之间进行数据传输,它通过将关系型数据库中的数据导入到Hadoop的HDFS、Hive、HBase等存储系统中,或将Hadoop中的数据导出到关系型数据库,实现了结构化数据与大数据平台的无缝对接,Sqoop的命令行设计灵活且功能强大,支持多种数据库和数据格式,能够高效处理大规模数据迁移任务,以下从基本语法、常用命令、参数配置及实际应用场景等方面对Sqoop命令进行详细解析。

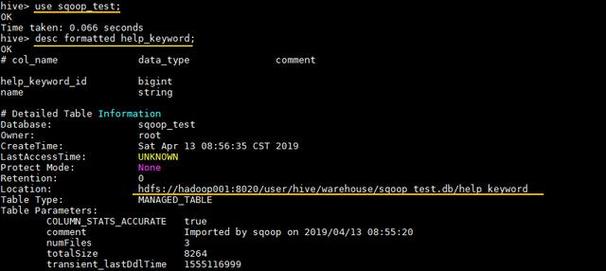

Sqoop命令的基本语法结构为:sqoop [options] <command> [arguments],其中command指定要执行的操作,如import、export等,而options则用于配置连接信息、目标路径、并行度等参数,执行Sqoop命令前,需确保环境中已正确配置Hadoop和JDK,并且数据库驱动JAR包位于Sqoop的lib目录下,从MySQL导入数据到HDFS时,需提供MySQL的连接URL、用户名、密码以及要导入的表名等关键信息。

数据导入命令(import)

import是Sqoop最常用的命令之一,用于将关系型数据库中的数据导入到Hadoop生态系统中,其核心参数包括:

--connect:数据库连接字符串,如jdbc:mysql://localhost:3306/test。--username和--password:数据库认证信息,可通过--password-file从文件中读取密码以增强安全性。--table或--query:指定要导入的表名或自定义SQL查询语句,使用--query时需包含$CONDITIONS占位符,并配合--split-by参数实现并行导入。--target-dir:指定HDFS中的目标目录,默认为/user/<username>/<table_name>。--num-mappers(或-m):设置MapTask数量,影响导入并行度,通常根据表数据量和集群资源调整。--fields-terminated-by:指定字段分隔符,如、'\t'等,需与HDFS文件格式匹配。--direct:使用数据库原生导入工具(如MySQL的mysqldump)提高导入效率,但需目标数据库支持。

将employees表数据导入HDFS并指定字段分隔符为逗号的命令为:

sqoop import --connect jdbc:mysql://localhost:3306/company --username root --password password --table employees --target-dir /data/employees --fields-terminated-by ',' --num-mappers 4

数据导出命令(export)

export命令用于将HDFS中的数据导出到关系型数据库,通常与import形成逆向操作,关键参数包括:

--export-dir:指定HDFS中待导出数据的目录。--table:目标数据库表名,表结构需与HDFS数据字段一致。--input-fields-terminated-by:指定HDFS数据的字段分隔符,需与导出时格式匹配。--update-mode:支持updateonly或allowinsert模式,决定是更新现有记录还是允许插入新记录。--update-key:指定作为更新条件的列名,通常为主键或唯一键。

将HDFS上的/data/sales目录数据导出到MySQL的sales_record表的命令为:

sqoop export --connect jdbc:mysql://localhost:3306/company --username root --password password --export-dir /data/sales --table sales_record --input-fields-terminated-by ',' --update-mode allowinsert --update-key sale_id

其他常用命令及参数

-

list-tables

用于查看数据库中的所有表,语法为:sqoop list-tables --connect jdbc:mysql://localhost:3306/test --username root --password password

-

eval

执行SQL查询并返回结果,便于测试SQL语句的正确性:sqoop eval --connect jdbc:mysql://localhost:3306/test --username root --password password --query "SELECT * FROM employees WHERE salary > 5000"

-

import-all-tables

导入指定数据库中的所有表到HDFS,每个表生成独立目录: (图片来源网络,侵删)

(图片来源网络,侵删)sqoop import-all-tables --connect jdbc:mysql://localhost:3306/test --username root --password password --warehouse-dir /data/all_tables

-

job

创建可复用的Sqoop作业,避免重复输入参数,通过--create定义作业,--exec执行作业:sqoop job --create myjob --import --connect jdbc:mysql://localhost:3306/test --table employees --target-dir /data/employees sqoop job --exec myjob

参数配置优化

为提高Sqoop执行效率,需根据场景调整参数:

- 并行度:

--num-mappers的设置需平衡数据库负载和Hadoop资源,通常取值为数据库CPU核心数的1-2倍。 - 增量导入:通过

--incremental参数支持append或lastmodified模式,仅导入新增或变更数据,减少全量扫描开销。 - 压缩配置:在HDFS端启用压缩(如

--compress-codec org.apache.hadoop.io.compress.SnappyCodec)可节省存储空间并加快传输速度。

实际应用场景

- 数据仓库构建:定期将业务数据库的全量或增量数据导入Hive,通过

--hive-import参数直接创建Hive表并加载数据。 - 数据库备份:利用

--direct模式结合--num-mappers实现大规模数据的快速备份到HDFS。 - ETL流程:将Sqoop作业集成到Oozie或Airflow工作流中,实现定时数据同步,确保数据湖的时效性。

相关问答FAQs

Q1: Sqoop导入数据时出现“Java.io.IOException: Cannot run program "mysqldump"”错误,如何解决?

A: 该错误通常是因为--direct模式依赖数据库原生工具,但系统未将其加入PATH环境变量,可通过两种方式解决:1)在Sqoop命令中指定工具路径,如--bindir /usr/bin;2)不使用--direct模式,改用默认的MapReduce导入方式。

Q2: 如何实现Sqoop增量导入并避免重复数据?

A: 使用--incremental append模式时,需配合--check-column指定用于判断增量的列(如自增ID),并通过--last-value设置起始值。

sqoop import --connect jdbc:mysql://localhost:3306/test --table logs --incremental append --check-column id --last-value 1000 --target-dir /data/logs

若基于时间戳增量,可使用--incremental lastmodified并指定--last-value为上次同步的时间点。