在Linux系统中,求和操作通常涉及对数值数据的统计,常见于日志分析、系统监控、数据处理等场景,虽然Linux没有名为“sum”的单一命令直接实现所有求和需求,但通过组合使用基础命令(如awk、bc、paste、column等)或编写简单脚本,可以高效完成各种求和任务,以下从不同场景出发,详细介绍Linux中的求和方法及其实际应用。

单列数据求和:使用awk或bc

对于单列数值数据的求和,awk是最常用的工具,其内置的运算符和END块可实现高效统计,有一个文件numbers.txt如下:

10

20

30

40

50使用awk求和的命令为:

awk '{sum += $1} END {print "Sum:", sum}' numbers.txt

命令解析:{sum += $1}逐行读取文件,将每行第一列的值累加到变量sum;END块在所有行处理完成后输出最终结果,输出为:

Sum: 150若数据中包含非数字字符(如标题行),可通过if语句过滤:

awk '$1 !~ /^[0-9]+/ {next} {sum += $1} END {print "Sum:", sum}' numbers.txt

对于需要高精度计算的场景(如浮点数或大整数),可结合bc实现:

paste -sd+ numbers.txt | bc

paste -sd+将所有行用连接为表达式(如10+20+30+40+50),通过管道传递给bc计算,此方法也支持多列求和,需指定列号(如$2)。

多列数据求和与分组统计

当需要对多列分别求和或按某列分组求和时,awk的数组功能尤为强大,文件sales.txt包含销售记录:

ProductA 100 200

ProductB 150 250

ProductA 120 180

ProductB 130 220多列分别求和

计算第二列和第三列的总和:

awk '{sum2 += $2; sum3 += $3} END {print "Column2 Sum:", sum2; print "Column3 Sum:", sum3}' sales.txt

按第一列分组求和

统计每个产品的第二列和第三列总和:

awk '{sum[$1] += $2; sum2[$1] += $3} END {for (product in sum) print product, "Sum2:", sum[product], "Sum3:", sum2[product]}' sales.txt

输出结果:

ProductA Sum2: 220 Sum3: 380

ProductB Sum2: 280 Sum3: 470多列横向求和(行求和)

若需计算每行的总和(如第二列加第三列):

awk '{row_sum = $2 + $3; print $1, "Row Sum:", row_sum}' sales.txt

或添加新列存储行和:

awk '{print $0, $2+$3}' sales.txt

复杂场景下的求和技巧

处理多文件求和

使用通配符合并多个文件的数据后求和:

awk '{sum += $1} END {print "Total Sum:", sum}' *.txt

结合sort和uniq分组求和

若数据已排序且需按特定条件分组,可先排序后统计:

sort -k1,1 sales.txt | awk '{sum[$1] += $2} END {for (product in sum) print product, sum[product]}'

使用datamash工具(需安装)

datamash是专门用于数据处理的工具,支持快速求和:

datamash -t ' ' sum 2,3 sales.txt # 计算第二列和第三列的总和 datamash -g 1 sum 2 sales.txt # 按第一列分组,求第二列和

实际应用示例:系统日志分析

假设分析系统日志access.log,统计每个IP的访问总次数(日志格式为IP - - [date] "request" status size):

awk '{ips[$1]++} END {for (ip in ips) print ip, ips[ip]}' access.log | sort -k2 -nr

若需统计总传输字数(假设为第七列):

awk '{sum += $7} END {print "Total Bytes:", sum}' access.log

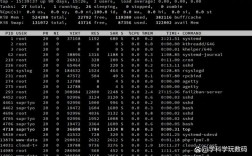

性能优化与注意事项

- 大数据量处理:对于GB级文件,可使用

mawk(比gawk更快)或分割文件并行处理。 - 内存管理:

awk数组会占用内存,若分组键过多(如唯一IP达百万级),可改用sort | uniq -c组合:cut -d' ' -f1 access.log | sort | uniq -c | sort -nr

- 浮点数精度:默认

awk使用双精度浮点数,若需更高精度,可通过printf "%.2f"格式化输出或使用bc。

相关问答FAQs

Q1: 如何处理包含空格或制表符分隔的多列数据求和?

A: 使用-F选项指定分隔符,如制表符(\t):

awk -F'\t' '{sum += $3} END {print "Sum:", sum}' data.tsv

若分隔符不固定,可使用FPAT(gawk特有)定义字段模式,例如处理CSV文件:

gawk -v FPAT='[^,]*' '{sum += $3} END {print "Sum:", sum}' data.csv

Q2: 如何对命令输出的结果实时求和,而不保存到临时文件?

A: 通过管道将命令输出直接传递给求和工具,统计df -h中已用空间的总和(需提取数值列):

df -h | awk 'NR>1 {gsub(/%/, "", $5); sum += $5} END {print "Total Usage:", sum "%"}'

或使用process substitution(需bash)处理复杂命令:

awk '{sum += $1} END {print "Sum:", sum} < <(command | awk '{print $1}')