网络要做到“马上响应”,并非单一技术实现的魔法,而是涉及网络架构设计、协议优化、资源调度、负载均衡、边缘计算、缓存策略、数据压缩以及硬件性能等多个层面的系统性工程,其核心目标是在物理距离、数据量、并发请求等客观约束下,尽可能缩短从用户发起请求到收到响应的时延(Latency),确保交互的即时性和流畅性,以下从技术原理和实现路径详细拆解这一过程。

低延迟网络架构:物理与逻辑的双重优化

网络响应速度的基础是物理距离和传输路径的缩短,传统网络中,数据需经过多个路由器、交换机节点,跨地域传输时延(如光速限制下的传播时延)和节点处理时延(如路由查找、排队时延)会显著影响响应速度,为解决这一问题,现代网络通过“扁平化”和“分布式”架构降低跳数和距离:

- CDN(内容分发网络):通过在全球边缘节点缓存静态资源(图片、视频、JS/CSS文件),用户访问时可直接从最近的节点获取数据,避免回源站的高延迟,用户访问某电商网站时,商品图片可能来自本地CDN节点,响应时延可从数百毫秒降至几十毫秒。

- 边缘计算:将计算能力下沉至网络边缘(如基站、园区节点),对时延敏感的业务(如AR/VR、自动驾驶)进行本地处理,无需将数据传输至云端核心机房,自动驾驶车辆的实时决策依赖边缘节点的低延迟响应,将端到端时延控制在毫秒级。

- 专线与低延迟协议:金融、游戏等场景采用专线网络(如MPLS VPN)减少公共互联网的路由跳数,同时优化传输协议(如UDP替代TCP,避免三次握手延迟),并通过QUIC(Quick UDP Internet Connections)协议整合连接建立、加密和传输,进一步降低握手时延。

智能负载均衡:请求的精准调度

当并发请求量激增时,单一服务器可能因过载导致响应延迟飙升,负载均衡通过算法将请求分发到多个后端节点,确保资源高效利用,为实现“马上响应”,负载均衡需兼顾“实时性”和“准确性”:

- 动态负载算法:基于实时节点状态(CPU使用率、内存占用、网络带宽、响应时延)选择最优节点,而非简单的轮询或随机分配,加权最少连接数算法(WLC)会优先将请求分配给当前连接数最少且性能较高的节点,避免请求堆积。

- 全局负载感知:通过分布式监控系统收集全网节点的实时性能数据,结合地理信息(如用户IP归属地)和业务优先级(如VIP用户请求优先处理),实现跨区域、跨机房的智能调度,某直播平台在热门赛事期间,会将南方用户的请求分流至广州节点,北方用户分流至北京节点,减少跨地域传输时延。

- 会话保持与故障转移:对需要会话连续的业务(如电商购物车),通过Cookie或IP哈希实现会话保持,避免用户请求被频繁切换到不同节点;健康检查机制可实时剔除故障节点,并将请求无缝转移至备用节点,确保服务不中断。

高效数据传输:从协议到压缩的全链路优化

数据在网络中的传输效率直接影响响应速度,这需要协议、编码和压缩技术的协同优化:

- 协议优化:TCP协议虽可靠,但三次握手、拥塞控制(如慢启动)会增加时延;UDP协议无连接、低开销,适用于实时性要求高的场景(如直播、在线游戏),通过UDP协议,结合前向纠错(FEC)和重传机制(如QUIC协议),可在保证可靠性的同时降低延迟。

- 数据压缩与编码:对传输内容进行压缩可减少数据包大小,缩短传输时间,使用Gzip/Brotli压缩文本资源,WebP/AV1压缩图片视频,Protobuf/MessagePack替代JSON进行二进制编码,可减少50%-80%的数据量。

- HTTP/2与HTTP/3:HTTP/2通过多路复用(一个TCP连接并行传输多个请求)和头部压缩(HPACK算法)解决队头阻塞问题;HTTP/3基于QUIC协议,进一步消除TCP的队头阻塞,确保丢包不影响其他请求的传输,大幅提升高并发场景下的响应速度。

资源与性能保障:硬件与系统的底层支撑

“马上响应”离不开底层资源的充足和高效利用:

- 硬件加速:使用SSD替代HDD减少磁盘I/O延迟(数据库查询、文件读取速度提升10倍以上);采用RDMA(远程直接内存访问)技术,允许服务器直接读写内存,无需CPU参与,将网络通信时延从微秒级降至纳秒级(适用于分布式数据库、高性能计算)。

- 缓存策略:通过多级缓存(浏览器缓存、CDN缓存、Nginx缓存、Redis缓存)减少数据重复计算和读取,Redis内存缓存可将热点数据(如商品详情页)的响应时延从数据库查询的几十毫秒降至1毫秒以内。

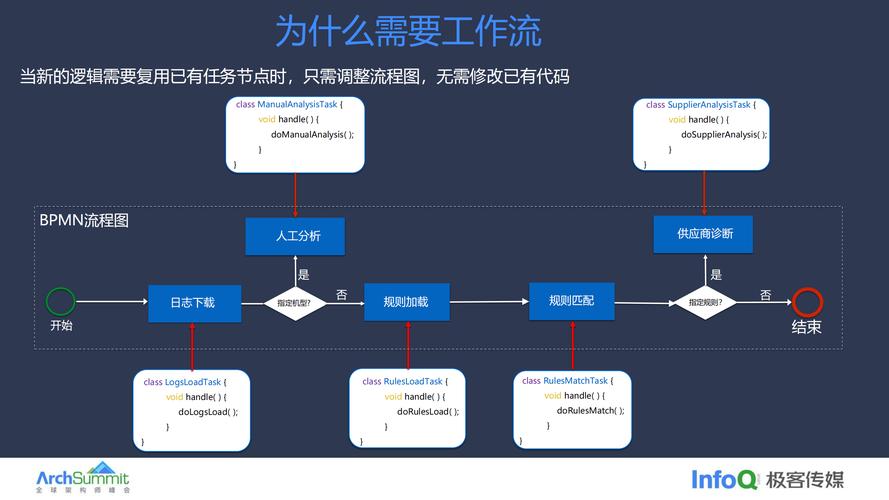

- 异步处理与消息队列:对非核心业务(如日志记录、数据统计)采用异步处理,用户请求只需触发核心流程,耗时操作交由后台消息队列(如Kafka、RabbitMQ)异步执行,避免阻塞主线程,提升响应速度。

实时监控与动态调优:持续优化响应体验

网络响应速度并非一成不变,需通过实时监控和动态调优适应业务变化:

- 全链路监控:通过APM(应用性能监控)工具(如SkyWalking、Pinpoint)追踪请求从用户浏览器到后端服务的全链路时延,定位瓶颈(如某个API接口响应慢、数据库查询慢)。

- 自适应算法:基于实时流量和负载动态调整参数,如CDN节点的缓存策略(LRU-LFU结合)、负载均衡的权重分配、数据库的连接池大小等,确保系统在高并发、突发流量下仍能保持低延迟。

相关问答FAQs

Q1:为什么CDN能提升网络响应速度?是否所有网站都需要CDN?

A:CDN通过在全球边缘节点缓存静态资源,使用户就近获取数据,减少跨地域传输的时延和带宽压力,用户访问海外网站时,CDN可将资源从本地节点而非源站服务器获取,响应时延从500ms降至50ms,但并非所有网站都需要CDN:对于纯静态、低流量的小型网站,CDN可能增加成本;而对于动态内容占比高、用户地域集中的业务(如企业内部系统),CDN效果有限,需结合边缘计算或专线优化。

Q2:UDP协议比TCP快,为什么HTTP/3仍选择基于UDP的QUIC协议?

A:TCP因三次握手、队头阻塞(丢包导致后续请求等待)等问题在高延迟、高丢包网络中性能较差;UDP虽无连接、低延迟,但缺乏可靠传输机制,QUIC协议在UDP基础上整合了TCP的可靠性(如加密、拥塞控制)和HTTP/2的多路复用,同时通过0-RTT(零往返时间)连接建立(复用已有连接)和前向纠错技术,既保留了UDP的低延迟优势,又解决了安全性和可靠性问题,特别适合移动网络(如4G/5G)等高延迟、高丢包场景。