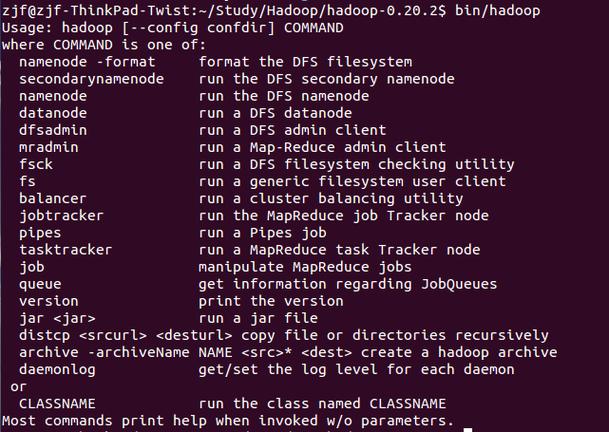

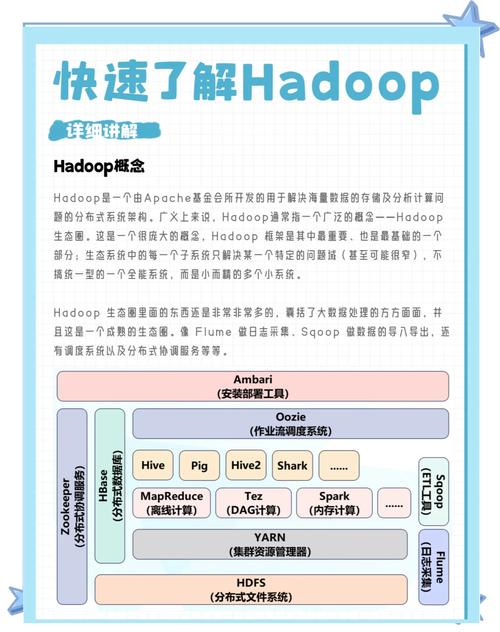

Hadoop作为分布式系统的基础框架,其命令行操作是用户与集群交互的核心方式,通过执行命令,用户可以管理HDFS文件系统、运行MapReduce作业、控制YARN资源等,以下从Hadoop命令体系、常用命令分类、执行原理及实践场景等方面展开详细说明。

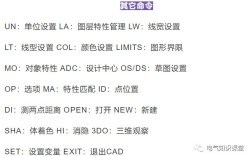

Hadoop命令主要通过hadoop fs、hadoop dfs、hadoop jar等工具实现,其中hadoop fs是通用文件系统命令,支持HDFS、LocalFS等多种文件系统,命令执行依赖于Hadoop的配置文件(如core-site.xml、hdfs-site.xml),这些文件定义了集群的NameNode地址、数据块副本数等关键参数,在执行命令前,需确保Hadoop集群已正确启动,且用户具备相应的权限。

HDFS文件管理命令

HDFS是Hadoop的分布式存储系统,其命令操作类似于Linux Shell,但针对分布式场景进行了优化,常用命令包括:

-

基本操作命令

hadoop fs -ls <路径>:列出指定目录下的文件和子目录,类似于ls命令,例如hadoop fs -ls /user可查看用户目录内容。hadoop fs -mkdir <路径>:创建目录,支持多级目录递归创建,需添加-p参数,如hadoop fs -mkdir -p /data/input。hadoop fs -put <本地路径> <HDFS路径>:将本地文件上传至HDFS,例如hadoop fs -put local.txt /data/input/。hadoop fs -get <HDFS路径> <本地路径>:从HDFS下载文件到本地,与put操作相反。hadoop fs -rm <路径>:删除文件或空目录,若需递归删除非空目录,需使用-rm -r。

-

高级操作命令

(图片来源网络,侵删)

(图片来源网络,侵删)hadoop fs -du <路径>:显示目录或文件的大小(以字节为单位),例如hadoop fs -du /user/hadoop可查看用户目录的总大小。hadoop fs -mv <源路径> <目标路径>:移动或重命名文件/目录,操作为原子性,不会因中断导致数据不一致。hadoop fs -cp <源路径> <目标路径>:复制文件,支持跨目录操作,但大文件复制可能影响集群性能。hadoop fs -chown <用户:组> <路径>:修改文件所有者,需超级用户权限,如hadoop fs -chown hadoop:hadoop /data/file.txt。

MapReduce作业执行命令

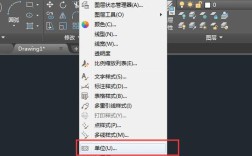

MapReduce是Hadoop的核心计算模型,作业提交和管理通过hadoop jar命令实现,执行流程包括:打包Jar文件→编写主类→指定输入输出路径→提交作业。

-

作业提交命令

基本语法为hadoop jar <Jar文件> <主类> <输入路径> <输出路径>,运行WordCount程序:

hadoop jar wordcount.jar WordCount /input /output

/input为HDFS上的输入目录,/output为输出目录(需不存在)。 -

作业管理命令

hadoop job -list:列出当前所有作业的状态(运行中、已完成等)。hadoop job -kill <作业ID>:终止指定作业,作业ID可通过-list查看。hadoop job -status <作业ID>:查看作业的详细状态,包括Map和Reduce任务进度。

-

优化参数设置

在提交作业时可添加参数调整资源分配,

-D mapreduce.map.memory.mb=2048:设置Map任务内存为2GB;

-D mapreduce.reduce.tasks=10:指定Reduce任务数量为10。 (图片来源网络,侵删)

(图片来源网络,侵删)

YARN资源管理命令

YARN负责集群资源调度和作业监控,常用命令包括:

-

集群状态查看

yarn node -list:列出集群中所有活跃的NodeManager节点。yarn application -list:显示当前运行的所有应用程序,包括应用ID、名称和状态。yarn application -status <应用ID>:查看指定应用的详细状态,如资源使用情况、任务进度等。

-

应用管理

yarn application -kill <应用ID>:终止指定应用,与hadoop job -kill功能类似。yarn logs -applicationId <应用ID>:查看应用的日志信息,用于调试作业运行问题。

命令执行原理与常见问题

Hadoop命令的执行依赖于客户端与集群各组件的交互,以hadoop fs -put为例,流程如下:

- 客户端读取配置文件,获取NameNode地址;

- 向NameNode发送请求,验证目标路径权限及是否存在;

- NameNode返回数据块存储位置(DataNode列表);

- 客户端直接与DataNode建立连接,上传文件分块;

- 上传完成后,NameNode更新元数据。

常见问题及解决方案:

- 权限不足:提示

Permission denied,需检查文件权限或使用hadoop fs -chown修改所有者。 - NameNode未启动:命令无响应,需通过

jps检查NameNode进程是否运行。 - 磁盘空间不足:文件上传失败,可通过

hadoop dfsadmin -report查看DataNode磁盘使用情况。

实践场景示例

假设需处理大规模日志文件,步骤如下:

- 上传日志文件至HDFS:

hadoop fs -put logs.tar.gz /data/; - 解压文件(需自定义MapReduce程序或使用Hadoop Streaming);

- 运行分析作业:

hadoop jar analyzer.jar LogAnalyzer /data/logs /result; - 查看结果:

hadoop fs -cat /result/part-r-00000。

相关问答FAQs

Q1: 为什么执行hadoop fs -put时提示“Filesystem closed”错误?

A: 该错误通常是由于HDFS客户端会话超时或NameNode异常导致,可尝试重启Hadoop集群(stop-dfs.sh后start-dfs.sh),或检查网络连接是否正常,若问题持续,需查看NameNode日志($HADOOP_HOME/logs/hadoop-root-namenode-xxx.log)定位具体原因。

Q2: 如何优化MapReduce作业的执行效率?

A: 可从以下方面优化:

- 输入分块:合理设置

mapreduce.input.fileinputformat.split.minsize,避免小文件过多; - 内存配置:根据任务复杂度调整Map和Reduce任务的内存(

mapreduce.map.memory.mb和mapreduce.reduce.memory.mb); - 压缩中间数据:启用MapReduce中间结果压缩(

mapreduce.map.output.compress=true),减少网络传输开销; - 并行度:适当增加Reduce任务数量(

mapreduce.reduce.tasks),提升集群资源利用率。