Hive作为大数据生态中常用的数据仓库工具,提供了多种数据导入方式,以满足不同场景下的数据同步需求,这些命令涵盖了从本地文件系统、Hadoop分布式文件系统(HDFS)、其他Hive表到关系型数据库等多种数据源,用户可根据数据量、数据格式、实时性要求等因素选择合适的导入方法,以下将详细介绍Hive中常用的数据导入命令及其使用场景、语法和注意事项。

通过LOAD DATA命令导入数据

LOAD DATA是Hive中最基础的数据导入方式,主要用于将HDFS上的文件或本地文件系统中的文件直接加载到Hive表中,该命令的特点是操作简单、速度快,但会直接移动或复制文件到Hive表的存储路径,不会对数据进行转换。

从本地文件系统导入

语法:LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE table_name [PARTITION (partcol1=val1, partcol2=val2 ...)]

- LOCAL关键字:表示从本地文件系统导入,若省略则从HDFS导入,使用LOCAL时,文件会被复制到Hive表的存储目录;不使用LOCAL时,文件会被直接移动到Hive表的存储目录。

- INPATH:指定要导入的文件路径,支持目录或单个文件,若为目录则会导入目录下所有文件。

- OVERWRITE:可选参数,表示覆盖表中已有数据,若省略则追加数据。

- PARTITION:指定分区表的分区信息,数据会直接导入到对应分区。

示例:

-- 从本地文件系统导入数据到Hive表,并覆盖原有数据 LOAD DATA LOCAL INPATH '/data/local_data.txt' OVERWRITE INTO TABLE student; -- 导入到指定分区 LOAD DATA LOCAL INPATH '/data/local_data.txt' INTO TABLE student PARTITION (dt='2023-01-01');

从HDFS导入数据

语法与本地导入类似,只需省略LOCAL关键字,文件会从HDFS的源路径移动到Hive表的存储路径,原路径文件将被删除。

示例:

-- 从HDFS导入数据到Hive表 LOAD DATA INPATH '/hdfs/data/student.txt' OVERWRITE INTO TABLE student;

通过INSERT语句导入数据

INSERT语句是Hive中更灵活的数据导入方式,支持从其他Hive表、HDFS文件或子查询中导入数据,并可在导入过程中进行数据转换、过滤等操作。

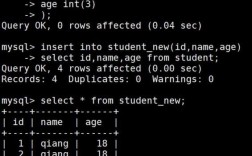

从其他Hive表导入数据

语法:INSERT [OVERWRITE] INTO TABLE table_name [PARTITION (partcol1=val1, ...)] SELECT ... FROM source_table [WHERE ...]

- 可通过SELECT语句指定要导入的列和过滤条件,实现数据的筛选和转换。

- 支持动态分区插入,可根据查询结果的自动分区信息将数据导入到对应分区。

示例:

-- 从源表导入数据到目标表,并过滤条件 INSERT INTO TABLE student_target SELECT id, name, age FROM student_source WHERE age > 18; -- 动态分区插入 INSERT OVERWRITE TABLE student_partitioned PARTITION (dt) SELECT id, name, age, dt FROM student_source WHERE dt IS NOT NULL;

从HDFS文件导入数据

需先将文件上传到HDFS,再通过INSERT...SELECT语句结合ROW FORMAT和FIELDS TERMINATED BY等指定文件格式进行导入。

示例:

-- 假设HDFS上有CSV格式文件,需先创建与文件格式匹配的表 CREATE TABLE student_csv (id INT, name STRING, age INT) ROW FORMAT DELIMITED FIELDS TERMINATED BY ','; -- 从HDFS文件导入数据到新表 LOAD DATA INPATH '/hdfs/data/student.csv' INTO TABLE student_csv; -- 再从student_csv表导入到目标表 INSERT INTO TABLE student_target SELECT * FROM student_csv;

通过Sqoop导入关系型数据库数据

Sqoop是用于Hadoop和关系型数据库之间数据传输的工具,可将MySQL、Oracle等关系型数据库中的数据导入到Hive表中,适用于大规模结构化数据的迁移。

基本语法:

sqoop import --connect jdbc:mysql://hostname:port/database --username user --password password --table table_name --target-table hive_table_name --fields-terminated-by ',' --hive-import

--connect:指定关系型数据库连接信息。--table:指定源数据库表名。--target-table:指定Hive表名(若省略则与源表名相同)。--hive-import:表示直接导入到Hive表。--fields-terminated-by:指定字段分隔符,需与Hive表分隔符一致。

示例:

sqoop import --connect jdbc:mysql://localhost:3306/test --root root --password 123456 --table student --hive-import --hive-table student_hive --fields-terminated-by ','

通过Hive Shell脚本批量导入

对于复杂的数据导入逻辑,可通过编写Hive Shell脚本(.hql文件),结合exec或source命令执行批量导入任务。

示例脚本(import_data.hql):

-- 创建目标表 CREATE TABLE IF NOT EXISTS student_target LIKE student_source; -- 导入数据并过滤 INSERT OVERWRITE TABLE student_target SELECT * FROM student_source WHERE status = 'active'; -- 导入到分区表 SET hive.exec.dynamic.partition.mode=nonstrict; INSERT OVERWRITE TABLE student_partitioned PARTITION (dt) SELECT id, name, age, dt FROM student_source WHERE dt >= '2023-01-01';

执行脚本:hive -f import_data.hql

数据导入注意事项

- 文件格式与分隔符:导入前需确保Hive表的分隔符、行格式与源文件一致,可通过

ROW FORMAT DELIMITED和FIELDS TERMINATED BY指定。 - 分区表:导入分区表数据时,需明确指定分区字段,或使用动态分区模式(需开启

hive.exec.dynamic.partition参数)。 - 数据覆盖与追加:使用

OVERWRITE会清空目标表数据,需谨慎操作;追加数据时需确保表结构与数据兼容。 - 权限问题:确保执行导入的用户对HDFS路径或本地文件有读写权限,对Hive表有操作权限。

- 数据量与性能:大文件导入时,建议分批次处理或启用MapReduce并行执行,可通过

mapred.reduce.tasks调整任务数。

相关问答FAQs

Q1: 使用LOAD DATA导入数据时,为什么数据文件会被移动或删除?

A: LOAD DATA命令的行为取决于是否使用LOCAL关键字:若使用LOCAL,文件会从本地系统复制到Hive表存储目录,本地文件保留;若不使用LOCAL,文件会从HDFS直接移动到Hive表目录,原HDFS路径文件将被删除,这是为了节省存储空间,避免重复存储。

Q2: 如何通过Sqoop导入MySQL数据到Hive分区表?

A: 可通过Sqoop的--hive-partition-key和--hive-partition-value参数指定分区字段和值,或使用动态分区(需Hive开启动态分区模式),示例:

sqoop import --connect jdbc:mysql://localhost:3306/test --user root --password 123456 --table student --hive-import --hive-table student_partitioned --fields-terminated-by ',' --hive-partition-key dt --hive-partition-value '2023-01-01'

若需动态分区,可省略--hive-partition-value,并在Hive中设置动态分区参数,如SET hive.exec.dynamic.partition.mode=nonstrict;。