分析服务器日志文件是系统运维、安全监控和性能优化的核心工作之一,通过日志可以还原系统运行状态、定位故障原因、发现潜在风险,以下是详细的分析步骤和方法,涵盖日志类型、分析工具、关键指标及实践技巧。

明确分析目标

在开始分析前,需根据需求确定分析方向,常见的目标包括:

- 故障排查:定位服务不可用、错误响应或性能瓶颈的原因;

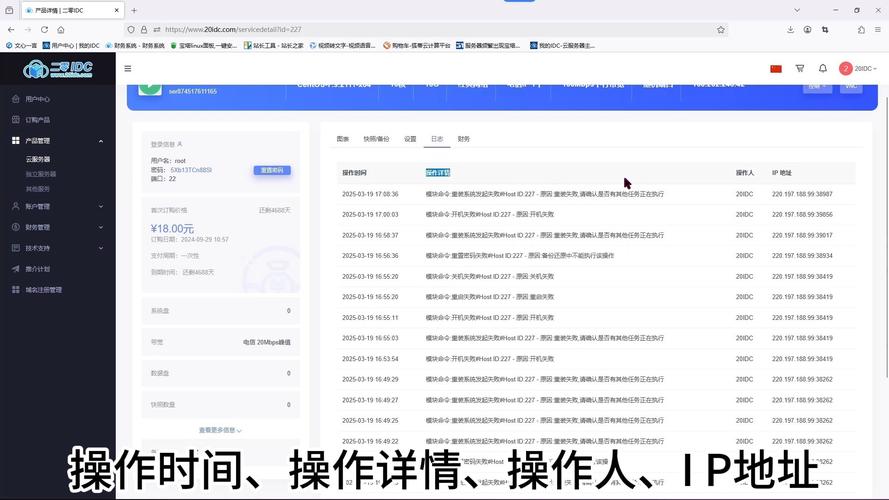

- 安全审计:检测异常登录、暴力破解、恶意请求等攻击行为;

- 性能优化:分析响应时间、资源使用率,优化系统配置;

- 用户行为分析:通过访问日志了解用户访问路径、热门资源等。

不同目标需关注的日志字段和指标差异较大,例如故障排查需重点看错误码和堆栈信息,而安全审计需关注IP频率和请求路径。

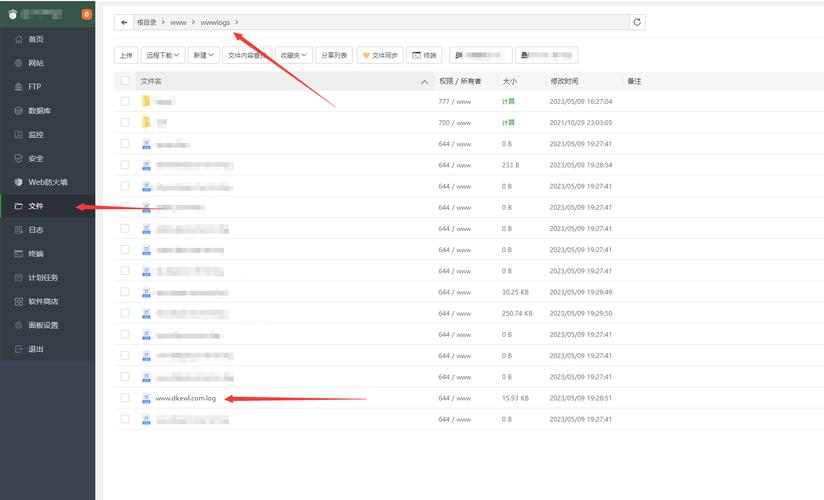

收集与预处理日志文件

服务器日志通常存储在/var/log/目录下,常见类型包括:

- 应用日志:如Nginx的

access.log、error.log,Tomcat的catalina.out; - 系统日志:如Linux的

messages、syslog,记录内核和服务运行状态; - 安全日志:如

auth.log(登录记录)、防火墙日志; - 业务日志:自定义的业务操作日志,如订单、支付记录。

预处理步骤:

- 日志采集:使用

Filebeat、Fluentd等工具将日志实时传输到集中式存储(如ELK Stack、Splunk); - 日志解析:通过正则表达式或Grok模式将非结构化日志转换为结构化数据,例如提取Nginx日志中的

$remote_addr、$request_time等字段; - 日志清洗:过滤无效信息(如爬虫请求、健康检查),去除重复或冗余数据。

关键日志字段解析

不同服务的日志字段差异较大,以下以Nginx和系统日志为例说明核心字段:

| 日志类型 | 关键字段 | 含义 | 分析场景 |

|---|---|---|---|

| Nginx访问日志 | $remote_addr |

客户端IP | 地理位置分析、异常IP检测 |

$request_time |

请求处理时间(秒) | 性能瓶颈定位 | |

$status |

HTTP状态码 | 4xx/5xx错误排查 | |

$http_user_agent |

客户端浏览器/爬虫标识 | 区分用户与爬虫 | |

| 系统日志 | timestamp |

日志生成时间 | 时间范围分析 |

kernel |

内核模块信息 | 系统故障排查 | |

pid |

进程ID | 进程异常监控 |

使用工具进行日志分析

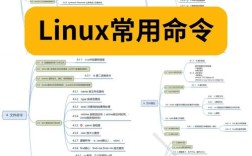

命令行工具

grep/awk/sed:快速过滤和提取关键字段,统计Nginx 5xx错误数量:grep " 5xx " access.log | awk '{print $1}' | sort | uniq -cjournalctl(Linux):查看系统服务日志,支持按时间、服务名过滤:journalctl -u nginx --since "2023-10-01" --until "2023-10-02"

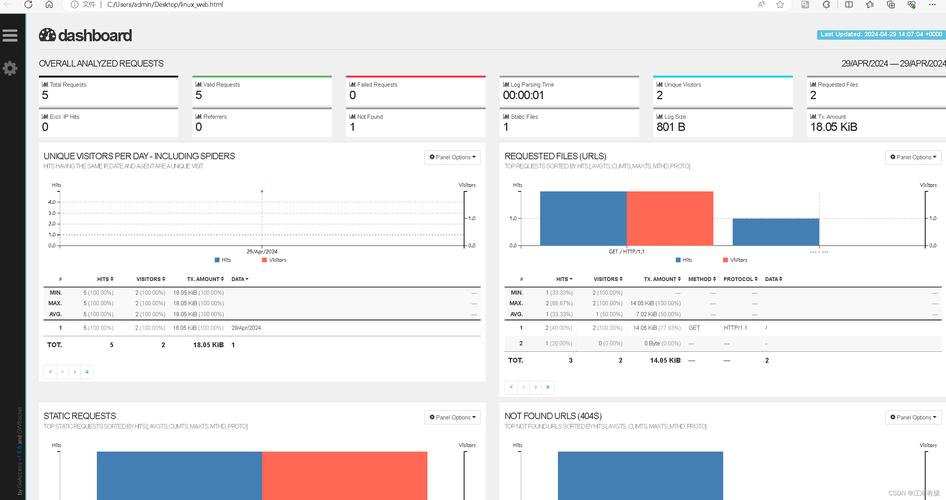

可视化分析工具

- ELK Stack(Elasticsearch + Logstash + Kibana):适合大规模日志存储与可视化,通过Kibana仪表盘实时监控错误率、响应时间等指标;

- Grafana + Loki:轻量级日志监控方案,可与Prometheus结合实现日志与监控指标联动;

- Splunk:商业日志分析平台,提供强大的机器学习异常检测功能。

编程分析

通过Python(如pandas、matplotlib库)对结构化日志进行深度分析:

import pandas as pd

# 读取Nginx日志并转换为DataFrame

df = pd.read_csv("access.log", sep=r'\s+',

names=['ip', 'time', 'request', 'status', 'size'])

# 统计各状态码数量

print(df['status'].value_counts())

核心分析维度

错误分析

- HTTP状态码:4xx(客户端错误)需检查URL拼写、权限问题;5xx(服务端错误)需排查服务崩溃或资源不足;

- 错误堆栈:应用日志中的

Exception或Traceback,定位具体代码错误。

性能分析

- 响应时间:分析

$request_time或upstream_response_time,找出慢请求; - 资源使用:通过系统日志的

CPU、内存字段,结合top/vmstat命令定位资源瓶颈。

安全分析

- 异常IP:高频请求IP(如每秒超过100次)可能为DDoS攻击或爬虫;

- 异常路径:检测

/admin、/wp-login.php等敏感路径的暴力破解尝试; - 异常User-Agent:如

sqlmap、nikto等工具的访问痕迹。

自动化与告警

通过设置规则实现实时告警,

- 使用

fail2ban封禁频繁失败的登录IP; - 在ELK中设置告警规则,当5xx错误率超过5%时触发邮件/钉钉通知;

- 通过Prometheus的

AlertManager监控日志中的关键词(如“FATAL”)。

日志归档与合规

- 归档策略:定期将旧日志压缩归档(如

gzip),保留3-6个月; - 合规要求:金融、医疗等行业需按法规(如GDPR、PCI DSS)保留用户操作日志,并确保敏感信息脱敏。

相关问答FAQs

问题1:如何快速定位服务器高负载时的瓶颈原因?

解答:首先通过top或htop查看CPU、内存占用最高的进程;结合iotop分析磁盘I/O,iftop查看网络流量,然后定位到具体进程后,检查其相关日志(如Nginx的error.log或应用日志),重点关注“Too many open files”“Out of memory”等错误信息,若为数据库高负载,可通过慢查询日志(MySQL的slow.log)分析低效SQL。

问题2:如何区分正常用户访问和恶意爬虫的日志特征?

解答:可通过以下特征区分:

- User-Agent:爬虫常使用Python、curl等工具标识(如

python-requests/2.25.1),而正常浏览器为Chrome/XX、Mozilla/XX; - 访问频率:爬虫可能在短时间内请求大量页面(如每秒50次),正常用户通常低于每秒5次;

- 路径规律:爬虫常遍历全站(如

/page/1、/page/2),而正常用户多集中在首页或特定功能页; - IP来源:使用

whois查询IP,若来自云服务器或数据中心,且访问量异常,可能为爬虫集群,可结合iptables或WAF规则封禁恶意IP。