网址被百度收录是网站运营的基础环节,只有被收录才有机会在搜索结果中获得展现,百度收录的原理本质上是其搜索引擎蜘蛛(如Baiduspider)通过爬取互联网上的网页,将页面信息进行索引并存储到百度数据库中,整个过程涉及网站基础优化、蜘蛛爬行引导、内容质量提升等多个维度,以下是具体分析和操作建议。

百度收录的核心机制

百度蜘蛛的爬行策略分为“主动发现”和“被动提交”两种方式,主动发现是指蜘蛛通过已收录页面中的外部链接(如其他网站的友情链接、论坛发帖等)或网站地图发现新网址;被动提交则是网站管理员通过百度站长平台主动提交网址,加速收录进程,百度对网址的收录会综合评估页面质量、原创性、用户体验及网站权重等因素,低质量或重复内容可能被忽略甚至降权。

提升百度收录率的实操步骤

确保网站基础设置符合百度规范

- robots.txt文件配置:该文件是爬虫访问网站的“指令书”,需允许百度蜘蛛爬取重要页面,禁止爬取后台管理目录(

Disallow: /admin/),但允许爬取公开内容(Allow: /),错误配置可能导致蜘蛛无法访问关键页面。 - 网站地图(sitemap)生成:创建XML格式的网站地图,列出所有重要页面的URL,并通过百度站长平台提交,sitemap能帮助蜘蛛系统性地发现网站结构,尤其对大型网站效果显著。

- canonical标签使用:通过

rel="canonical"标签规范重复内容的主URL,避免因页面重复导致百度收录混乱。

提升页面质量与原创性

百度优先收录有价值的内容,需从以下方面优化:原创性避免直接复制他人内容,可通过数据整理、案例分析、观点整合等方式创造差异化内容,原创内容更容易获得蜘蛛青睐,也符合用户需求,时效性与相关性:针对热点话题或行业动态及时更新内容,例如节日促销、政策解读等,能提升页面被发现的概率,结构优化**:采用清晰的标题层级(H1-H6)、段落划分、图文结合等方式,提升用户阅读体验,同时便于蜘蛛理解页面主题。

增加网站外链与内部链接

- 外部链接建设:高质量的外部链接是蜘蛛发现新网址的重要途径,可通过行业论坛、自媒体平台、合作伙伴网站等渠道获取自然外链,避免购买低质量链接(如链接农场)导致被惩罚。

- 内部链接优化:在网站内部通过锚文本链接关联相关页面,形成“蜘蛛网”结构,在文章中插入“相关推荐”“历史文章”等模块,引导蜘蛛持续爬取更多页面。

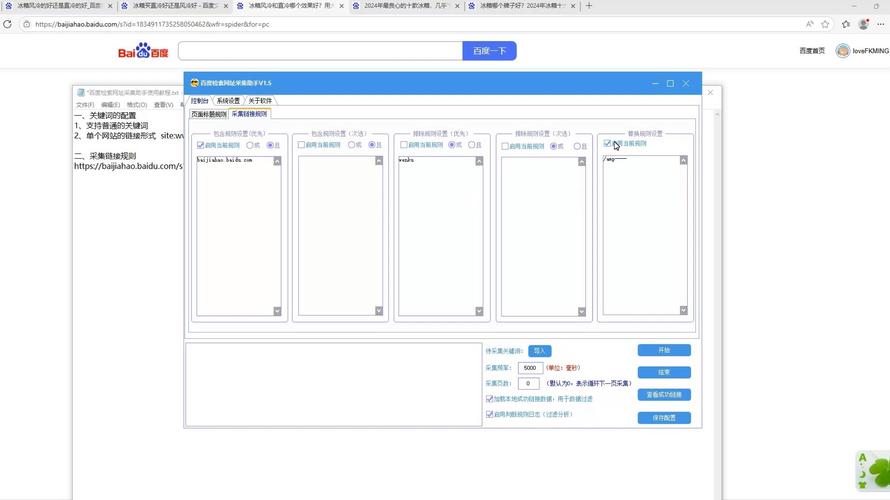

利用百度站长工具主动提交

百度站长平台提供了多种提交方式,可加速收录进程:

- 手动提交:适用于少量重要页面,每日提交上限不超过10万条。

- 自动提交:通过API接口或JS代码实现页面自动推送,实时告知百度蜘蛛新页面产生,效率最高。

- sitemap提交:定期更新sitemap并提交,确保蜘蛛能获取最新页面列表。

提升网站加载速度与移动端适配

- 加载速度优化:压缩图片、启用CDN加速、减少HTTP请求等方式提升页面加载速度,百度将“用户体验”作为重要收录因素,慢速网站可能被降低爬取频率。

- 移动端适配:采用响应式设计或独立的移动端页面,确保手机用户访问流畅,百度已全面推行移动优先索引,移动端体验差的网站收录率会显著下降。

百度收录的常见问题与解决方法

| 问题现象 | 可能原因 | 解决方案 |

|---|---|---|

| 网站提交后长期未收录 | 网站权重低、内容质量差、robots.txt禁止爬取 | 提升原创内容质量,检查robots.txt配置,增加外链建设 |

| 部分页面收录但首页未收录 | 首页无外链引导、存在大量动态参数 | 优化首页内容,增加内部链接,将动态页面改为静态URL |

| 收录后迅速被删除 | 内容抄袭、页面频繁改版、服务器不稳定 | 原创,避免频繁修改页面结构,选择稳定的服务器 |

相关问答FAQs

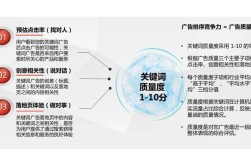

Q1:网站被百度收录后多久能获得排名?

A:收录与排名是两个独立过程,排名取决于页面质量、关键词竞争度、外链数量等多重因素,通常需要1-3个月甚至更长时间,建议持续优化内容并积累高质量外链,同时关注百度算法更新动态。

Q2:为什么我的网站提交了sitemap但仍未被全部收录?

A:sitemap仅作为“引导工具”,百度是否收录仍需评估页面价值,可能原因包括:页面内容质量不足、存在大量重复内容、网站权重较低或服务器不稳定导致蜘蛛无法正常爬取,建议检查页面质量,优化网站结构,并确保服务器稳定运行。