Python爬虫在招聘领域的应用日益广泛,它通过自动化技术高效获取、筛选和分析招聘信息,为企业HR、求职者以及招聘平台提供了极大的便利,以下将从技术原理、实际应用、注意事项及发展趋势等方面展开详细阐述。

Python凭借其丰富的库生态(如Requests、BeautifulSoup、Scrapy、Selenium等)成为爬虫开发的首选语言,在招聘场景中,爬虫的工作流程通常包括:明确目标(如特定岗位、薪资范围)、发送HTTP请求获取网页内容、解析HTML或JSON数据提取关键信息(职位名称、公司、薪资、要求等)、存储数据(MySQL、MongoDB、Excel等)以及后续的数据清洗与分析,使用Requests库可模拟浏览器访问招聘网站,BeautifulSoup或 lxml 用于解析页面结构,Scrapy框架则适合构建大规模、分布式的爬虫系统,而Selenium可通过驱动浏览器处理动态加载的内容(如JavaScript渲染的页面)。

对于企业HR而言,Python爬虫可用于竞品监控,实时抓取竞争对手的招聘需求、薪资水平及岗位要求,从而调整自身招聘策略;也可用于人才库建设,通过抓取公开的职业社交平台信息,潜在目标候选人的背景资料,求职者则可利用爬虫聚合多个招聘网站的岗位信息,实现个性化推荐(如根据技能、薪资偏好筛选),或追踪目标公司的招聘动态,招聘平台自身也依赖爬虫技术进行数据监控,例如分析行业热门岗位、薪资趋势,或反爬虫机制防止恶意数据抓取。

爬虫技术的应用需严格遵守法律法规与道德规范,根据《网络安全法》及《数据安全法》,爬虫不得侵犯个人隐私、不得干扰目标网站正常运营,且需尊重网站的robots.txt协议(该文件规定了网站允许爬虫访问的范围),部分招聘网站明确禁止自动化抓取,强行爬取可能导致IP被封禁甚至法律风险,高频请求可能对服务器造成压力,因此需设置合理的请求间隔(如使用time.sleep()),并使用代理IP池避免单一IP被封,数据存储时,涉及个人敏感信息(如手机号、邮箱)需脱敏处理,且不得用于非法用途。

从技术趋势看,招聘爬虫正朝着智能化与合规化方向发展,结合机器学习模型,爬虫可自动识别岗位描述中的关键技能(如Python、机器学习),预测薪资范围,甚至评估岗位匹配度;随着反爬虫技术的升级(如验证码、动态令牌、行为检测),爬虫需不断优化策略,如使用OCR识别验证码、模拟人类操作行为(如随机滑动鼠标)、或通过API接口获取授权数据(部分平台提供开放API,无需爬虫),分布式爬虫(如Scrapy-Redis)和云服务器部署(如AWS、阿里云)能提升数据抓取效率,应对大规模数据需求。

在实际开发中,招聘爬虫的常见挑战包括页面结构变化(网站改版导致解析失败)、反爬虫机制拦截(如User-Agent检测、IP封锁)以及数据清洗的复杂性(如薪资表述差异:“10-15K” vs “10k-15k”),针对这些问题,开发者需具备较强的调试能力(如使用F12工具分析网络请求),并建立动态解析规则(如XPath选择器冗余设计),可结合数据可视化工具(如Matplotlib、Seaborn)将分析结果转化为图表,直观展示行业招聘趋势,如“Python岗位需求量月度变化图”或“不同城市平均薪资对比表”。

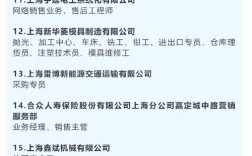

以下为招聘数据爬取后的简单分析表示例:

| 岗位关键词 | 需求量(个) | 平均薪资(K) | 主要技能要求 |

|---|---|---|---|

| Python开发 | 1200 | 15-25 | Django, Flask, MySQL |

| 数据分析 | 800 | 12-20 | Pandas, SQL, Tableau |

| 机器学习 | 500 | 20-35 | TensorFlow, Scikit-learn |

Python爬虫在招聘领域的价值在于通过数据驱动决策,但技术的使用必须以合法合规为前提,开发者应平衡效率与道德,避免滥用技术;而企业和求职者则需明确数据用途,确保在保护隐私的前提下实现信息对称。

相关问答FAQs

-

问:使用Python爬虫抓取招聘信息是否违法?

答:不一定,需根据具体情况判断,若仅抓取公开的非个人信息(如岗位名称、公司名称、薪资范围),且遵守目标网站的robots协议及服务条款,通常不违法,但若涉及个人隐私数据(如电话、身份证号)或用于商业牟利,可能触犯《个人信息保护法》,建议优先使用官方API或获得网站授权。 -

问:如何避免招聘网站的反爬虫机制?

答:可通过以下方法降低被封风险:① 设置请求头(如User-Agent、Referer)模拟真实浏览器;② 控制请求频率(如随机延迟1-3秒);③ 使用代理IP池轮换IP;④ 处理验证码(如OCR识别或第三方打码平台);⑤ 对于动态加载页面,采用Selenium或Playwright模拟浏览器行为,定期更新爬虫策略以应对网站反爬升级。