Spark作为大数据处理的核心框架,其运行命令的灵活配置直接决定了任务执行的效率和资源利用率,掌握Spark运行命令的核心参数与场景化配置,是优化作业性能的关键,本文将从基础提交命令、核心资源配置、高级优化参数及常见部署模式四个维度,详细解析Spark运行命令的使用方法。

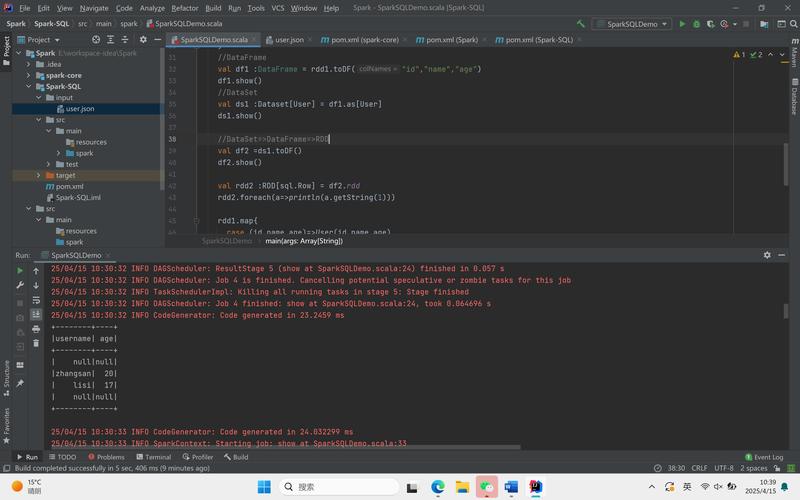

在Spark中,所有任务提交均通过spark-submit脚本完成,该脚本会读取用户配置的参数,生成SparkContext并启动应用程序,基础命令格式为spark-submit [options] <app jar | python file> [app args],其中options部分是参数配置的核心,通过--class指定主类,--master设置集群管理器,--deploy-mode选择部署模式(client或cluster),这三个参数是任务提交时必须明确的配置项,以YARN集群模式提交Scala应用为例,基础命令为spark-submit --class com.example.MyApp --master yarn --deploy-mode cluster --driver-memory 4g --executor-memory 8g --num-executors 10 my-app.jar arg1 arg2,该命令中明确指定了主类、集群管理器、部署模式及基础资源参数。

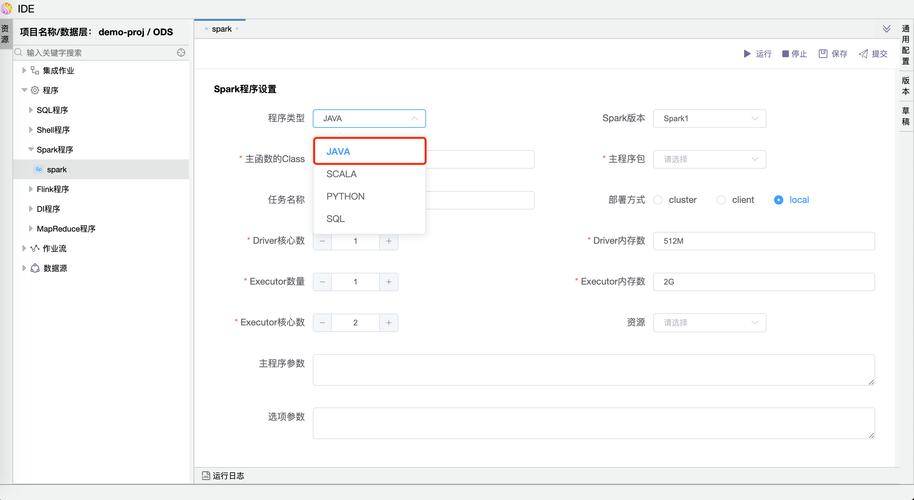

资源配置是运行命令中的重点,直接影响任务的并行度与执行速度,核心资源参数包括驱动器(Driver)和执行器(Executor)的相关配置,Driver负责任务调度与协调,其内存通过--driver-memory设置(如4g),CPU核心数通过--driver-cores指定(默认1),Executor是任务执行单元,需配置的参数包括:--num-executors(执行器数量,如10)、--executor-memory(单执行器内存,如8g)、--executor-cores(单执行器CPU核心数,如2),这些参数需根据集群资源总量与应用需求动态调整,例如内存密集型任务可增加--executor-memory,CPU密集型任务可提升--executor-cores。--queue参数在YARN模式下用于指定资源队列,实现多租户资源隔离;--conf可自定义任意Spark配置项,如--conf "spark.sql.shuffle.partitions=200"覆盖默认的分区数。

针对特定场景,运行命令需结合高级优化参数提升性能,在数据处理中,数据倾斜是常见问题,可通过--conf "spark.sql.adaptive.enabled=true"启用自适应查询优化,或设置--conf "spark.sql.shuffle.partitions=500"增加shuffle阶段并行度,对于迭代算法(如机器学习任务),可配置--conf "spark.kryoserializer.buffer.max=1g"优化序列化性能,或使用--conf "spark.memory.fraction=0.8"调整内存管理比例,若需访问外部数据源,如HDFS,需通过--conf "spark.hadoop.fs.defaultFS=hdfs://namenode:8020"指定文件系统地址;连接Kafka时,需添加--conf "spark.kafka.bootstrap.servers=kafka:9092"等参数,在调试阶段,可通过--verbose输出详细日志,或使用--conf "spark.eventLog.enabled=true"开启事件日志记录,便于后续分析任务执行瓶颈。

Spark支持多种部署模式,需根据业务场景选择,Local模式适用于本地开发调试,命令为spark-submit --master local[*],[*]表示使用所有可用CPU核心;Standalone模式需提前启动Spark集群,通过--master spark://master:7077提交任务;YARN模式是生产环境主流选择,分为client(适合交互式查询)和cluster(适合生产批处理)两种部署模式,在K8s环境下,需通过--master k8s://https://k8s-master:6443指定API Server地址,并配置--conf "spark.kubernetes.container.image=spark-image"等参数。

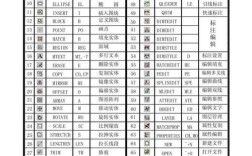

以下为常见资源配置示例及效果对比:

| 参数组合 | 适用场景 | 优势 | 潜在问题 |

|---|---|---|---|

--master local[4] --driver-memory 2g |

本地算法调试 | 无需集群依赖,快速验证逻辑 | 无法模拟分布式环境 |

--master yarn --deploy-mode cluster --num-executors 20 --executor-memory 16g --executor-cores 4 |

大规模ETL任务 | 充分利用集群资源,隔离Driver进程 | Executor内存不足可能导致任务失败 |

--master spark://master:7077 --total-executor-cores 40 --executor-memory 8g |

实时流处理 | 任务调度延迟低,资源控制精细 | 需手动管理集群资源 |

相关问答FAQs:

Q1: 如何解决Spark任务因Executor内存溢出失败的问题?

A: 可通过以下步骤排查解决:1)使用--conf "spark.executor.memoryOverhead=2g"增加执行器内存开销(默认为内存的10%,至少1GB);2)检查数据倾斜,通过--conf "spark.sql.adaptive.skewJoin.enabled=true"优化join操作;3)减少单条记录大小,避免序列化溢出;4)监控GC日志,通过--conf "spark.executor.extraJavaOptions=-XX:+PrintGCDetails"定位内存泄漏。

Q2: Spark on YARN模式下,如何提升任务读取HDFS数据的效率?

A: 优化方法包括:1)设置合理的--conf "spark.sql.files.maxPartitionBytes=128m"控制分区大小,避免小文件过多;2)启用--conf "spark.hadoop.mapreduce.fileoutputcommitter.marksuccessfuljobs=false"减少commit操作开销;3)结合--conf "spark.serializer=org.apache.spark.serializer.KryoSerializer"提升序列化性能;4)通过--conf "spark.sql.shuffle.partitions=200"调整shuffle并行度,减少数据倾斜。