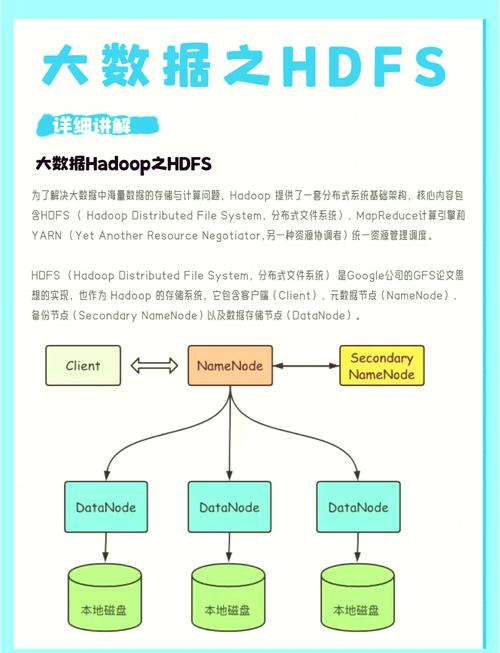

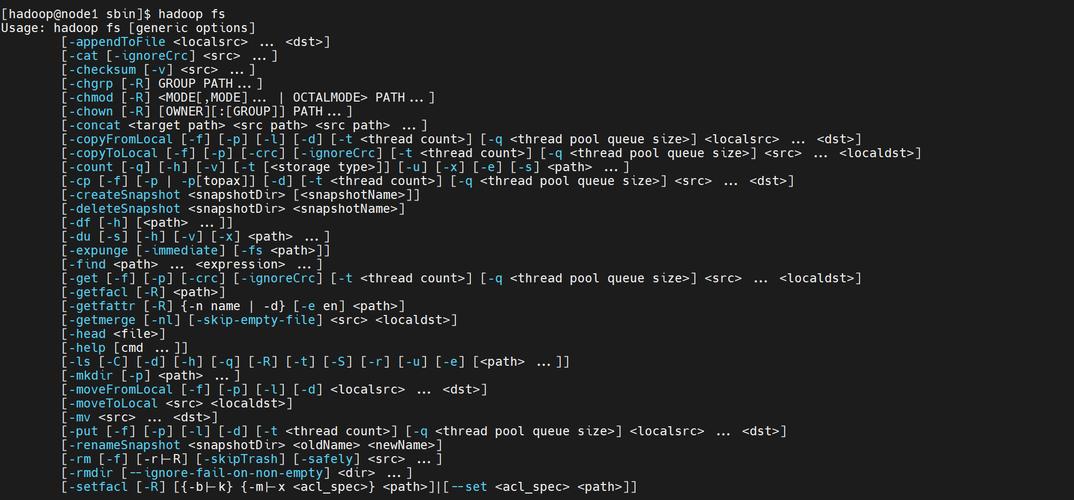

HDFS(Hadoop Distributed File System)是Hadoop生态系统的核心组件,用于存储大规模数据集,启动HDFS需要按照特定顺序执行命令,确保各服务协调运行,以下是详细的HDFS启动流程及命令说明,涵盖单节点和分布式集群场景。

启动前的准备工作

在执行启动命令前,需确保以下条件已满足:

- 环境配置:Hadoop已正确安装,并配置了

core-site.xml、hdfs-site.xml等核心文件。 - SSH免密登录:集群节点间需配置SSH免密登录,用于远程管理。

- 数据目录初始化:首次启动前需格式化HDFS文件系统(仅执行一次),命令为:

hdfs namenode -format

注意:格式化会清空现有数据,非首次启动时需谨慎操作。

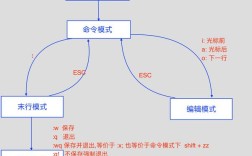

HDFS启动命令详解

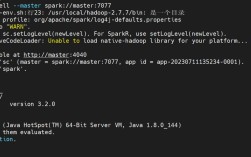

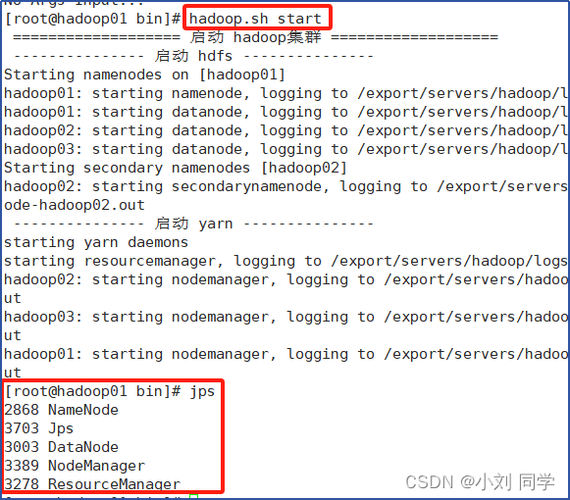

HDFS的启动依赖于start-dfs.sh脚本,该脚本会自动启动NameNode、DataNode和SecondaryNameNode等关键服务,以下是具体步骤:

单节点模式启动

在开发或测试环境中,可直接执行以下命令启动所有HDFS服务:

start-dfs.sh

执行后,日志会输出到$HADOOP_HOME/logs目录,可通过jps命令验证进程是否启动成功:

- NameNode

- DataNode

- SecondaryNameNode(部分版本可能合并到NameNode)

分布式集群启动

在分布式环境中,需分别在主节点(Master)和从节点(Slave)上执行不同操作:

- 主节点:启动NameNode和SecondaryNameNode

start-dfs.sh -namenode start-dfs.sh -secondarynamenode

- 从节点:启动DataNode

start-dfs.sh -datanode

若集群规模较大,可通过

workers文件(位于$HADOOP_HOME/etc/hadoop/)指定所有从节点地址,然后在主节点执行start-dfs.sh实现批量启动。

高可用(HA)集群启动

对于HA集群,需先启动ZKFC(ZK Failover Controller)和JournalNode,再启动HDFS服务:

# 启动JournalNode(所有节点) hdfs --daemon start journalnode # 在主NameNode节点格式化并启动 hdfs namenode -format hdfs --daemon start namenode # 在备NameNode节点同步数据并启动 hdfs namenode -bootstrapStandby hdfs --daemon start namenode # 启动ZKFC(主节点) hdfs --daemon start zkfc # 启动DataNode(所有节点) start-dfs.sh -datanode

服务状态检查

启动完成后,可通过以下命令检查服务状态:

# 查看进程 jps # 查看HDFS状态 hdfs dfsadmin -report # 查看Web UI(默认端口9870) http://<namenode-ip>:9870

常见问题处理

- 端口冲突:若NameNode或DataNode端口被占用,需在

hdfs-site.xml中修改dfs.namenode.rpc-address等配置。 - 权限问题:确保Hadoop用户对数据目录有读写权限,可通过

chown -R hadoop:hadoop /hadoop/data调整。

相关问答FAQs

Q1: 启动HDFS时提示“Permission denied”如何解决?

A1: 通常是由于SSH免密配置失败或Hadoop用户权限不足导致,需检查:

- 执行

ssh localhost验证免密登录是否成功; - 确认数据目录(如

/tmp/hadoop)的属主为Hadoop用户,可通过chown命令修改权限。

Q2: 如何优雅停止HDFS服务?

A2: 使用stop-dfs.sh脚本可安全关闭所有HDFS服务,避免数据损坏,命令如下:

stop-dfs.sh

对于HA集群,需先停止ZKFC和JournalNode:

hdfs --daemon stop zkfc hdfs --daemon stop journalnode