进入Spark命令的方式取决于你使用的Spark部署模式和环境,以下是详细说明,包括本地模式、集群模式(如YARN、Mesos)以及交互式shell(Spark Shell、PySpark、SparkR)的进入方法,附带常见配置和注意事项。

在本地开发环境中,最常用的进入Spark命令的方式是通过Spark Shell,首先确保你的系统已安装Java(JDK 8或11)和Scala,并下载了Spark二进制包,解压Spark包后,进入解压目录的bin子目录,例如/usr/local/spark-3.3.0-bin-hadoop3/bin,在该目录下,执行./spark-shell命令即可启动交互式Scala Shell,如果需要使用Python,则执行./pyspark命令,启动PyShell;对于R语言,使用./sparkR命令,这些命令会默认使用本地模式,分配所有可用CPU核心和内存,可通过参数调整,例如./spark-shell --master local[2]表示使用2个本地核心,或./spark-shell --driver-memory 4g设置驱动内存为4GB。

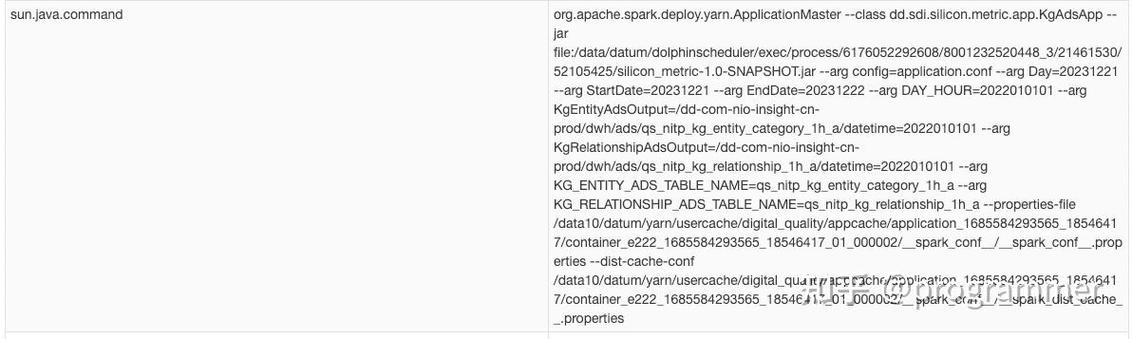

若需连接到集群资源管理器(如YARN),需确保Hadoop环境配置正确,且HADOOP_CONF_DIR或YARN_CONF_DIR环境变量指向Hadoop配置目录,进入YARN集群模式的命令为./spark-shell --master yarn,或指定部署模式为客户端模式(--deploy-mode client)或集群模式(--deploy-mode cluster),客户端模式下,Spark Driver运行在客户端机器,适合调试;集群模式下,Driver运行在集群节点,适合生产环境。./spark-shell --master yarn --deploy-mode cluster --queue production,其中--queue指定YARN队列。

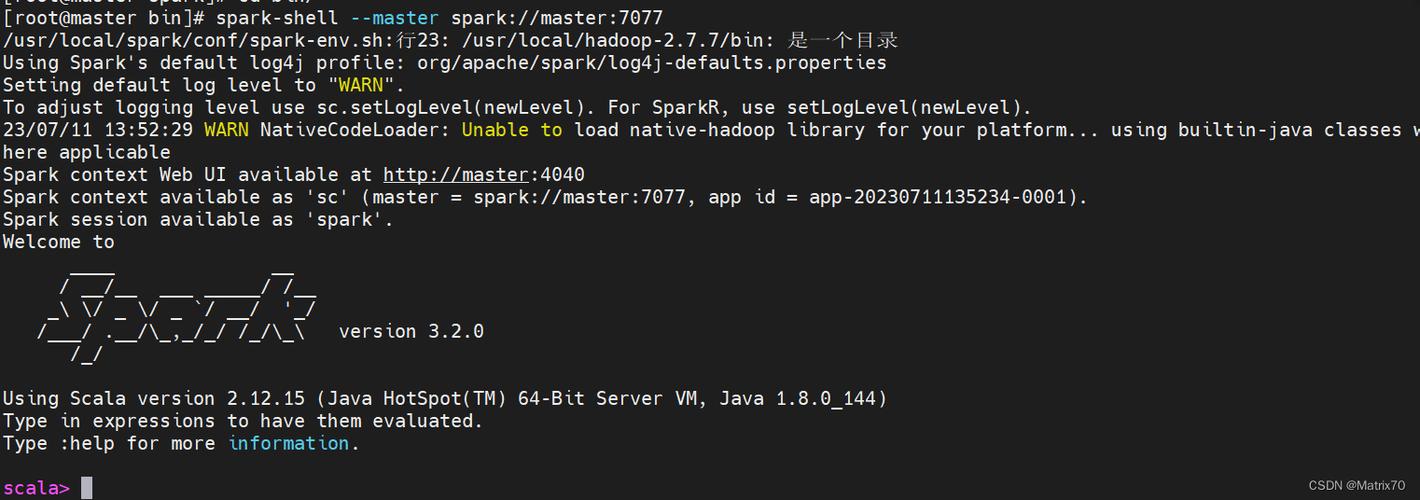

对于Mesos集群,需先启动Mesos Master和Slave,并配置Mesos环境变量,进入命令为./spark-shell --master mesos://master-ip:5050,可添加--mesos-user指定运行用户,或--executor-memory设置执行器内存,在Standalone集群模式下,需先启动Spark Master(./sbin/start-master.sh)和Worker(./sbin/start-worker.sh spark://master-ip:7077),然后通过./spark-shell --master spark://master-ip:7077连接,可指定--total-executor-cores和--executor-cores控制资源分配。

以下是常见进入Spark命令的参数说明表:

| 参数 | 说明 | 示例 |

|---|---|---|

--master |

指定Master URL,可选local、yarn、spark://、mesos:// | --master spark://192.168.1.100:7077 |

--deploy-mode |

部署模式,client或cluster(仅YARN/Standalone) | --deploy-mode cluster |

--driver-memory | Driver内存大小 |--driver-memory 2g` |

||

--executor-memory |

每个Executor内存大小 | --executor-memory 4g |

--total-executor-cores |

所有Executor总核心数(Standalone/YARN) | --total-executor-cores 10 |

--executor-cores |

每个Executor核心数 | --executor-cores 2 |

--queue |

YARN队列名称 | --queue default |

--name |

应用名称 | --name MySparkApp |

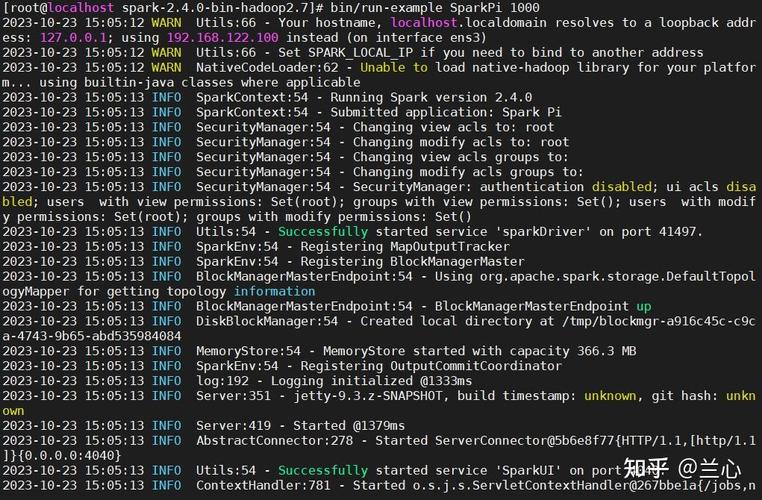

除了交互式Shell,还可通过spark-submit提交应用程序,例如./bin/spark-submit --class org.apache.spark.examples.SparkPi --master local[2] ../examples/jars/spark-examples_2.12-3.3.0.jar 10,其中--class指定主类,--master指定Master,最后一个参数是程序传递的参数,在IDE中(如IntelliJ IDEA),需配置Spark依赖和运行参数,通过main方法启动程序,或使用SparkSession.builder构建会话。

注意事项包括:确保网络配置允许集群节点通信,防火墙开放端口(如Standalone的7077、8080);日志文件默认存放在$SPARK_HOME/logs目录;通过--conf可自定义配置项,如--conf "spark.sql.shuffle.partitions=200",若遇到连接问题,检查Master节点状态(./sbin/start-master.sh --webui-port 8080查看Web UI)或集群资源是否充足。

相关问答FAQs:

Q1: 如何在Windows系统下进入Spark Shell?

A1: 在Windows系统中,需先安装Java并配置JAVA_HOME环境变量,下载Spark二进制包(建议预编译版本),解压后进入bin目录,执行spark-shell.cmd(Scala)或pyspark.cmd(Python),若提示“winutils.exe”错误,需下载对应Hadoop版本的winutils.exe并放置在HADOOP_HOME/bin目录下,同时设置HADOOP_HOME环境变量,确保系统PATH包含Spark的bin目录。

Q2: Spark Shell启动后如何退出?

A2: 在Spark Shell(Scala/Python/R)中,可通过以下方式退出:

- 输入

quit(Scala)或exit()(Python/R)并按回车; - 使用快捷键

Ctrl+D(Linux/Mac)或Ctrl+Z后按回车(Windows); - 直接关闭Shell窗口(不推荐,可能导致资源未释放)。

退出前建议执行spark.stop()(Python/R)或sc.stop()(Scala)显式停止SparkContext,确保资源被正确回收。