Scrapy招聘信息:技术解析与实战指南

在当前大数据和人工智能快速发展的时代,网络爬虫技术已成为企业获取数据的重要手段,Scrapy作为Python生态中最成熟的开源爬虫框架,凭借其高效性、可扩展性和强大的数据处理能力,在招聘市场上持续保持旺盛需求,本文将从Scrapy的核心技术要点、企业招聘要求、实战技能提升及职业发展路径四个维度,全面解析Scrapy相关岗位的招聘信息。

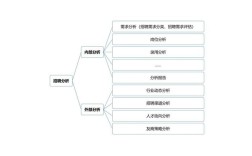

Scrapy技术栈与核心能力要求

企业招聘Scrapy开发人员时,通常要求候选人具备以下技术能力:

-

基础编程能力 精通Python语言,熟悉面向对象编程思想,掌握常用数据结构(列表、字典、集合等)和算法,熟悉正则表达式、XPath和CSS选择器,能够高效提取网页数据。

(图片来源网络,侵删)

(图片来源网络,侵删) -

Scrapy框架深度掌握 熟悉Scrapy核心组件(Spider、Item Pipeline、Middleware、Downloader等)的工作原理,能够独立设计复杂的爬虫架构,掌握Scrapy的异步请求机制、分布式爬虫实现(如结合Scrapy-Redis)以及反爬虫策略(User-Agent轮换、IP代理池、验证码处理等)。

-

数据存储与处理能力 熟悉关系型数据库(MySQL、PostgreSQL)和非关系型数据库(MongoDB、Redis)的操作,能够设计合理的数据存储方案,掌握数据清洗、转换和分析的基本方法,熟悉Pandas、NumPy等数据处理库。

-

反反爬虫技术 理解常见反爬虫机制(动态加载、JavaScript渲染、频率限制等),掌握应对策略如Selenium/Playwright动态渲染、验证码识别(OCR技术)、请求限速等。

-

项目部署与运维 熟悉Linux操作系统,掌握Docker容器化部署技术,了解基本的爬虫监控和日志管理,具备一定的服务器运维能力,能够解决爬虫运行中的性能瓶颈问题。

(图片来源网络,侵删)

(图片来源网络,侵删)

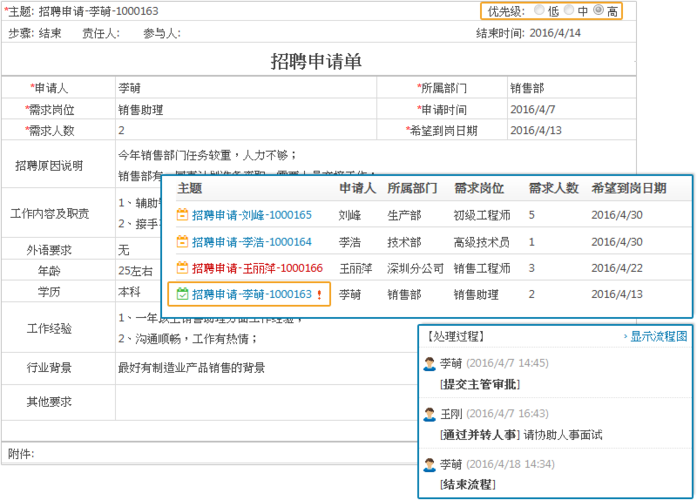

企业招聘需求分析

根据主流招聘平台数据,Scrapy相关岗位主要分布在互联网、金融、电商、数据分析等行业,职位名称包括爬虫工程师、数据采集工程师、Python开发工程师(数据方向)等,以下为不同级别岗位的核心要求对比:

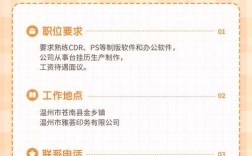

| 岗位级别 | 学历要求 | 工作经验 | 核心技能要求 | 薪资范围(月薪) |

|---|---|---|---|---|

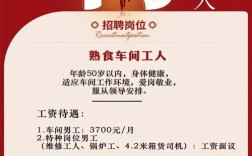

| 初级爬虫工程师 | 本科及以上 | 0-2年 | 基础Python、Scrapy框架、数据存储 | 8K-15K |

| 中级爬虫工程师 | 本科及以上 | 2-5年 | 分布式爬虫、反爬虫策略、数据分析 | 15K-25K |

| 高级爬虫工程师 | 本科及以上 | 5年以上 | 架构设计、大规模数据处理、团队管理 | 25K-40K |

企业特别重视候选人的实战经验,通常要求提供个人项目作品集或GitHub代码仓库,对于中高级岗位,还会考察候选人的问题解决能力和系统设计能力,例如设计一个日均千万级请求量的爬虫系统需要考虑哪些问题。

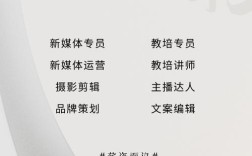

Scrapy实战技能提升路径

-

基础夯实阶段 通过官方文档和经典教程(如《Python网络数据采集》)掌握Scrapy基本用法,完成简单网站的爬虫项目,重点练习Item Pipeline的数据处理流程和Middleware中间件的开发。

-

进阶实战阶段 构建复杂场景的爬虫系统,如:

- 电商网站商品信息爬取(处理动态加载、分页数据)

- 社交媒体数据采集(处理登录状态、AJAX请求)

- 分布式爬虫开发(结合Scrapy-Redis实现任务队列和去重)

高级能力突破 学习Scrapy的性能优化技巧,包括:

- 请求调度优化(调整CONCURRENT_REQUESTS、DOWNLOAD_DELAY等参数)

- 内存管理(避免内存泄漏,合理使用生成器)

- 异常处理机制(完善重试策略和错误日志)

行业应用拓展 结合具体行业需求学习相关知识:

- 电商领域:了解商品比价、用户行为分析等应用场景

- 金融领域:掌握实时数据监控和历史数据分析方法行业:学习自然语言处理基础,为文本数据分析做准备

职业发展建议

-

持续学习新技术 关注爬虫技术发展趋势,学习新兴框架如Scrapy Cloud、Portia等,了解无头浏览器技术(Puppeteer、Playwright)与Scrapy的结合应用。

-

培养数据思维 从单纯的数据采集转向数据价值挖掘,学习基础的数据分析方法和可视化技术,提升业务理解能力。

-

构建个人作品集 通过GitHub展示高质量的开源项目,参与知名数据集的构建工作,提升个人影响力。

-

考取相关认证 虽然行业没有统一的认证标准,但可以通过Python数据分析、云计算等相关认证提升竞争力。

Scrapy相关岗位的发展前景广阔,随着企业数字化转型加速,对高质量数据采集和处理的需求将持续增长,建议求职者夯实技术基础,积累实战经验,培养解决复杂问题的能力,在数据驱动的时代浪潮中把握职业发展机遇。

相关问答FAQs

Q1:没有Scrapy项目经验如何应对面试? A:即使没有正式项目经验,也可以通过以下方式弥补:1)搭建个人学习项目,如爬取知乎热门话题、豆瓣电影评分等,并将代码上传至GitHub;2)熟悉Scrapy官方文档和经典案例,能够清晰阐述框架的工作原理;3)准备面试时重点展示学习能力和解决问题的思路,例如可以讨论"如何设计一个反爬虫策略"这类开放性问题;4)学习相关的前置技术(如Python基础、HTTP协议)和后续技术(如数据分析),展示完整的技术视野。

Q2:Scrapy爬虫工程师需要掌握机器学习知识吗? A:对于初级岗位,机器学习并非必需技能,但掌握基础的数据分析能力(如使用Pandas进行数据清洗)会有明显优势,对于中高级岗位,特别是涉及数据挖掘、用户画像等场景的岗位,机器学习知识会成为加分项,建议按需学习:1)了解常见的机器学习算法(如分类、聚类)的基本原理;2)掌握Scikit-learn等库的基本使用;3)理解特征工程的基本概念,能够为数据采集任务设计合理的特征提取方案,不必追求成为机器学习专家,但需要具备将爬取数据与业务需求结合的能力。