百度蜘蛛,即百度搜索引擎的爬虫程序,其核心任务是在互联网上发现、抓取和索引网页内容,以构建百度搜索的数据库,理解百度蜘蛛如何找到网站,对于网站优化和提升搜索可见性至关重要,这一过程涉及多个环节,从蜘蛛的启动机制到抓取策略,再到网站自身的引导作用,共同构成了一个复杂而精密的系统。

百度蜘蛛的工作并非随机游走,而是基于一套预设的规则和算法,蜘蛛的启动依赖于一个“种子列表”,这个列表包含了大量已知的高质量网站URL,这些URL可能来自百度内部的历史数据、合作网站提交,或者是其他蜘蛛在抓取过程中发现的链接,当蜘蛛启动后,它会从这个种子列表出发,像一张不断延展的网一样,通过解析网页中的超链接来发现新的页面,这是最基础的“广度优先”或“深度优先”的爬取策略,即从一个页面出发,抓取其所有出链,再从这些新发现的页面中继续抓取它们的出链,如此循环往复。

互联网的规模是如此庞大,以至于蜘蛛不可能抓取到所有页面,百度蜘蛛需要一套高效的优先级排序机制,决定哪些页面应该优先抓取,哪些可以稍后处理,哪些甚至可以忽略,这个排序机制的核心考量因素包括页面的重要性、新鲜度、相关性以及网站的健康状况,页面的重要性通常通过链接分析来评估,即获得高质量外部链接越多的页面,其重要性越高,被蜘蛛优先抓取的可能性也越大,新鲜度则是指页面的更新频率,对于新闻、博客等时效性内容,蜘蛛会更频繁地进行抓取以获取最新信息,相关性则与用户的搜索意图相关,蜘蛛会尝试理解页面的主题内容,并将其与特定的搜索查询进行匹配,如果一个网站经常出现无法访问(404错误)、加载缓慢或结构混乱等问题,蜘蛛可能会降低对该网站的抓取频率,甚至暂时放弃。

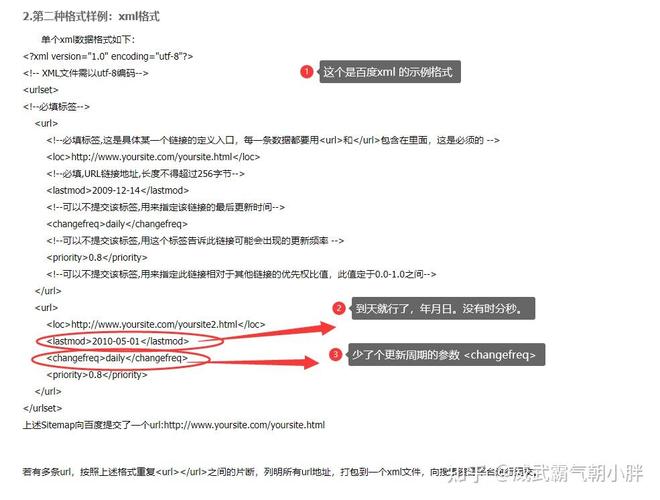

除了被动的链接发现,网站本身也可以主动向蜘蛛发出“邀请”,最直接的方式是通过搜索引擎的站长平台,如百度站长平台,网站管理员可以在这个平台上提交网站的XML地图(Sitemap),这是一个包含了网站所有重要页面链接的文件,相当于为蜘蛛提供了一份详细的“网站目录”,通过提交Sitemap,蜘蛛可以更全面、更高效地发现网站的结构和内容,特别是对于那些内部链接较深或新上线的页面,主动提交能显著提高其被发现的几率,站长平台还提供了“URL提交”工具,允许管理员手动提交单个或批量的页面URL,这对于发布新内容后希望快速被索引的场景尤为有用。

网站的技术架构和内容质量也直接影响着蜘蛛的抓取效率,一个清晰、规范的网站URL结构有助于蜘蛛理解页面层次关系;合理的robots.txt文件则可以指导蜘蛛哪些页面可以抓取,哪些页面需要禁止抓取,避免蜘蛛浪费资源在无关或敏感页面上,通过在robots.txt中设置规则,可以禁止蜘蛛抓取网站的登录页、后台管理页或重复内容页面,网站的响应速度、移动端适配性、安全性(如使用HTTPS)等技术因素,也会影响蜘蛛的抓取体验,一个技术基础扎实、用户体验良好的网站,更容易获得蜘蛛的青睐。 质量是吸引蜘蛛持续访问的根本,百度蜘蛛的目标是为用户提供有价值的信息,原创性、权威性、时效性和相关性的内容更容易被蜘蛛识别和重视,定期更新高质量内容,可以保持网站的活跃度,向蜘蛛传递“网站在持续运营”的信号,从而促使蜘蛛更频繁地回访,相反,如果网站内容大量抄袭、过时或与主题无关,蜘蛛不仅会降低抓取频率,还可能对网站的整体权重产生负面影响。

蜘蛛在抓取到页面内容后,并不会立即进行索引,而是会对页面进行一系列复杂的处理,包括解析HTML代码、提取文本内容、识别图片和视频等多媒体信息、分析页面结构等,在这个过程中,蜘蛛会特别关注页面的标题标签(Title)、描述标签(Meta Description)、头部标签(H1-H6)、关键词密度、内部链接锚文本等元素,这些因素有助于蜘蛛理解页面的主题和核心内容,一个经过良好优化的页面,能够让蜘蛛更准确地抓取和索引其信息。

为了更直观地展示百度蜘蛛发现网站的关键因素及其作用,可以参考下表:

| 关键因素 | 具体作用 | 对蜘蛛的影响 |

|---|---|---|

| 初始种子列表 | 提供起始抓取点,包含已知高质量URL | 决定蜘蛛的初始覆盖范围 |

| 超链接发现 | 通过解析页面中的出链,不断发现新的页面 | 实现互联网范围的页面覆盖,是被动发现的核心机制 |

| 页面优先级排序 | 基于重要性、新鲜度、相关性等对页面进行排序,决定抓取顺序 | 优化抓取效率,确保重要和优质内容优先被处理 |

| Sitemap提交 | 通过站长平台提交XML地图,主动告知蜘蛛网站结构 | 提高新页面和深层页面的发现效率,确保重要页面不被遗漏 |

| URL手动提交 | 通过站长工具提交特定页面URL,加速新内容被发现 | 适用于紧急或重要内容的快速索引 |

| 网站技术架构 | 包括URL结构、robots.txt、网站速度、移动端适配等 | 影响抓取效率和体验,良好的技术架构有助于蜘蛛顺利抓取 |

| 页面元素优化 | 标题、描述、标签、锚文本等元素的优化 | 帮助蜘蛛理解页面主题,提高索引的准确性和相关性 |

百度蜘蛛找网站是一个结合了主动发现与被动索引、技术引导与内容吸引的综合性过程,对于网站所有者而言,要想让百度蜘蛛更容易找到并重视自己的网站,就需要从多个维度入手:既要主动通过站长平台提交Sitemap和URL,也要优化网站的技术架构和robots.txt文件;更重要的是,要坚持创作高质量、原创性的内容,并建立合理的内部链接结构,让蜘蛛在抓取过程中能够顺畅地发现和索引所有有价值的信息,只有理解并遵循蜘蛛的工作原理,才能在激烈的搜索引擎竞争中占据有利位置。

相关问答FAQs:

问题1:为什么我的新网站上线后,百度蜘蛛很久都不来抓取? 解答: 新网站上线后百度蜘蛛不来抓取,可能由多种原因导致,确保网站已通过百度站长平台验证并添加了站点,检查网站的robots.txt文件是否误设置了禁止抓取,或者是否存在技术问题导致蜘蛛无法访问(如服务器宕机、DNS解析错误、网站被墙等),新网站缺乏外部链接和高质量内容也是重要原因,蜘蛛通常更倾向于抓取有外部推荐和内容价值的网站,建议主动向百度站长平台提交Sitemap和重要页面URL,并积极建设网站内容和获取高质量的外部链接,以吸引蜘蛛的注意。

问题2:robots.txt文件对百度蜘蛛有什么影响?如果设置不当会有什么后果? 解答: robots.txt文件是位于网站根目录下的一个纯文本文件,它通过特定的指令(如Disallow、Allow)告诉百度蜘蛛哪些页面可以抓取,哪些页面禁止抓取,它对蜘蛛具有指导性作用,但不具强制性,合规的蜘蛛会遵守规则,设置得当的robots.txt可以帮助蜘蛛节省抓取资源,避免抓取到无用的页面(如重复内容、后台管理页、隐私政策页等),从而集中精力抓取重要内容,但如果设置不当,例如误将重要的目录或页面用“Disallow”禁止,就会导致蜘蛛无法抓取这些页面,使其无法被百度索引,直接影响网站的搜索可见性,修改robots.txt文件前务必谨慎,并建议使用站长平台的robots.txt测试工具进行检查。