在使用Hadoop分布式文件系统(HDFS)时,hadoop fs命令是用户与HDFS进行交互的核心工具,然而在实际操作中,用户可能会遇到“hadoop fs命令无效”的问题,导致无法正常执行文件操作,这一问题可能由多种原因引起,包括环境配置错误、命令语法错误、Hadoop服务状态异常或权限问题等,以下将从常见原因、排查步骤和解决方案三个方面展开详细分析,并提供相关FAQs以帮助用户快速定位和解决问题。

常见原因分析

-

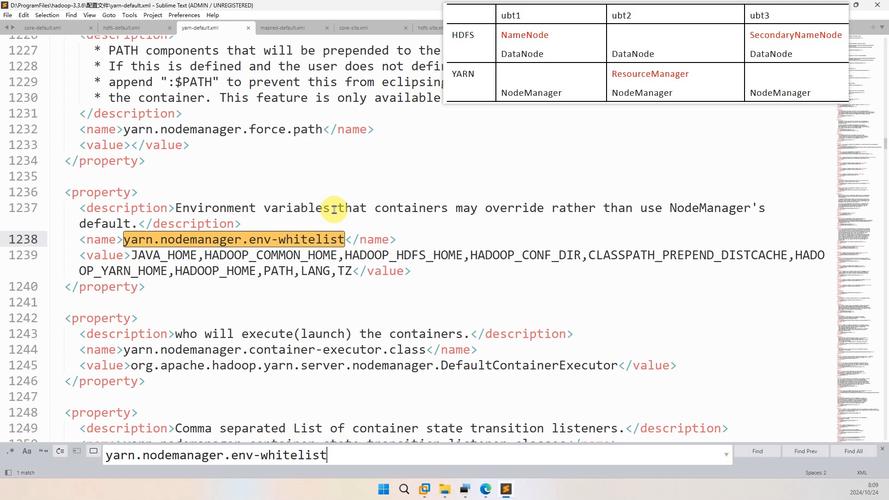

环境变量未正确配置

Hadoop命令的执行依赖于HADOOP_HOME和PATH环境变量,如果HADOOP_HOME未指向正确的Hadoop安装目录,或PATH中未包含$HADOOP_HOME/bin,系统将无法识别hadoop fs命令,在Linux系统中,若未执行export PATH=$PATH:$HADOOP_HOME/bin,命令行输入hadoop fs时会提示“command not found”。 -

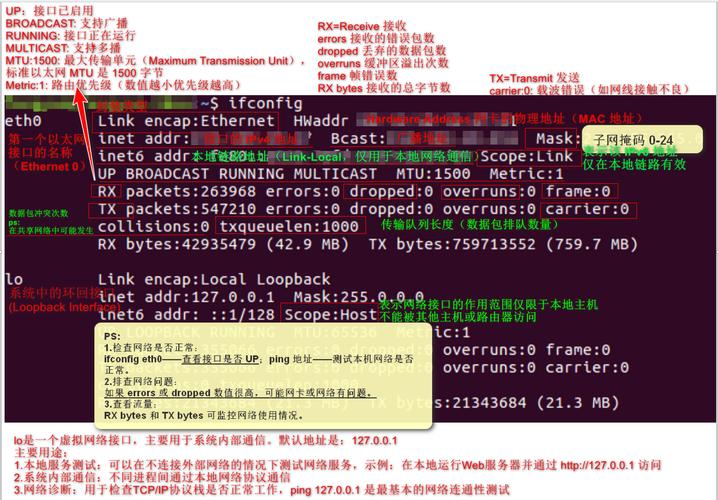

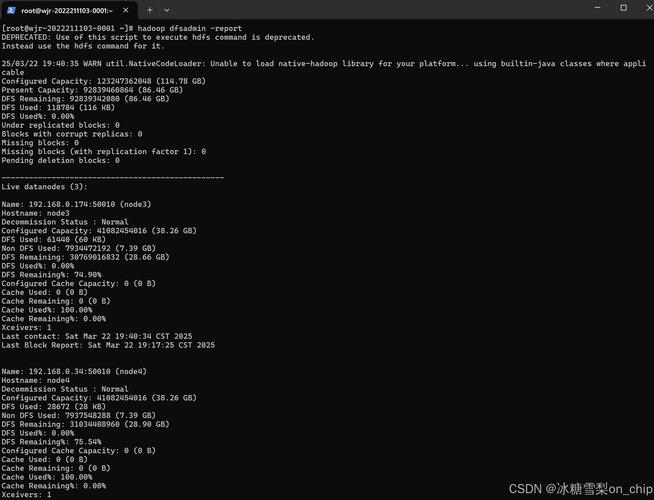

Hadoop服务未启动

hadoop fs命令需要NameNode和DataNode服务正常运行,若Hadoop集群未正确启动,或部分服务异常,命令执行时会返回“Connection refused”或“RPC timeout”等错误,可通过jps命令检查进程状态,NameNode应包含NameNode进程,DataNode应包含DataNode进程。 -

命令语法错误

hadoop fs命令的语法较为严格,例如参数顺序、路径格式等错误可能导致命令无效。hadoop fs -ls /user/hadoop是正确的,而hadoop fs /user/hadoop -ls则会报错,HDFS路径必须以hdfs://开头(如hdfs://namenode:8020/user/hadoop),若省略协议前缀,可能因默认配置错误导致解析失败。 -

权限问题

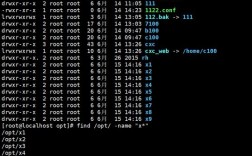

HDFS采用基于用户权限的访问控制,若当前用户未对目标路径拥有执行权限,命令会返回“Permission denied”,默认情况下,只有hadoop超级用户可对目录执行写操作,普通用户需通过chmod或chown调整权限。 (图片来源网络,侵删)

(图片来源网络,侵删) -

Hadoop版本兼容性

不同版本的Hadoop命令参数可能存在差异,旧版Hadoop使用hadoop fs -rmr递归删除目录,而新版已改为hadoop fs -rm -r,若用户误用旧版语法,在新环境中会导致命令无效。

排查步骤与解决方案

针对上述原因,可按以下步骤逐一排查:

检查环境变量

执行以下命令验证环境变量是否正确配置:

echo $HADOOP_HOME echo $PATH

若输出为空或路径错误,需编辑~/.bashrc或/etc/profile文件,添加以下内容并重新加载:

export HADOOP_HOME=/usr/local/hadoop export PATH=$PATH:$HADOOP_HOME/bin

验证Hadoop服务状态

通过jps命令检查关键进程:

jps

若缺少NameNode或DataNode进程,需启动Hadoop集群:

start-dfs.sh # 启动HDFS服务 start-yarn.sh # 若使用YARN,需启动ResourceManager和NodeManager

校验命令语法

参考Hadoop官方文档确认命令格式,列出文件内容应使用:

hadoop fs -ls /user/hadoop

若涉及特殊字符(如空格),需用引号包裹路径:

hadoop fs -ls "/user/hadoop/my dir"

解决权限问题

使用hadoop fs -chmod或hadoop fs -chown调整权限,赋予用户对/user/hadoop的读写权限:

hadoop fs -chmod 755 /user/hadoop hadoop fs -chown hadoop:hadoop /user/hadoop

检查版本兼容性

通过hadoop version命令确认当前版本,并查阅对应版本的命令手册,新版Hadoop递归删除目录的正确语法为:

hadoop fs -rm -r /user/hadoop/old_dir

常见错误与对应解决方案

以下表格总结了部分典型错误及解决方法:

| 错误提示 | 可能原因 | 解决方案 |

|---|---|---|

command not found |

环境变量未配置 | 检查并设置HADOOP_HOME和PATH |

Connection refused |

Hadoop服务未启动 | 执行start-dfs.sh启动服务 |

Permission denied |

用户权限不足 | 使用chmod或chown调整权限 |

Invalid argument |

命令语法错误 | 参考官方文档校验参数格式 |

No such file or directory |

路径不存在或拼写错误 | 检查HDFS路径是否正确 |

相关问答FAQs

Q1: 为什么执行hadoop fs -ls时提示“Could only be written to 0 of the 1 minReplication nodes”?

A: 该错误通常是由于HDFS的副本配置问题导致,默认情况下,HDFS要求文件至少有1个副本(minReplication=1),但若DataNode节点不足或网络异常,系统可能无法满足副本要求,解决方案包括:检查DataNode状态是否正常(jps查看进程),或临时降低副本数(hadoop fs -D dfs.replication=1 -ls /path)。

Q2: 如何解决hadoop fs命令执行后卡住无响应的问题?

A: 卡住通常是由于网络延迟或NameNode负载过高导致,可尝试以下步骤:1)检查NameNode节点资源使用率(top命令);2)增加hadoop fs命令的超时时间(如hadoop fs -D dfs.client.socket-timeout=60000 -ls /path);3)若集群负载过高,考虑停止非必要任务或扩展节点资源,若问题持续,需查看NameNode日志($HADOOP_HOME/logs/hadoop-root-namenode-xxx.log)定位具体错误。