Python抓取招聘信息是当前数据分析和求职领域常见的需求,通过编写爬虫程序可以高效获取各大招聘平台的岗位数据,为职业分析、市场研究或个人求职提供支持,以下是详细的技术实现步骤和注意事项。

准备工作

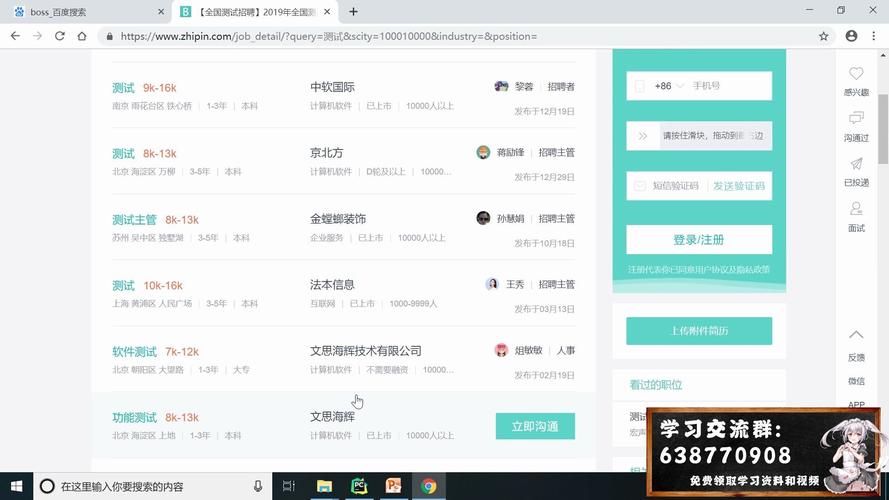

在开始抓取招聘信息前,需要明确目标网站并分析其页面结构,国内常见的招聘平台包括BOSS直聘、智联招聘、前程无忧等,不同网站的反爬策略不同,需针对性设计爬虫,需安装必要的Python库,如requests用于发送HTTP请求,BeautifulSoup或lxml用于解析HTML,pandas用于数据存储,以及selenium用于处理动态加载的页面,安装命令为pip install requests beautifulsoup4 pandas selenium。

基础爬虫实现

以静态页面为例,抓取步骤如下:使用requests库发送GET请求,通过headers参数模拟浏览器访问,避免被识别为爬虫。

import requests

url = "https://example.com/jobs"

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36"}

response = requests.get(url, headers=headers)

html = response.text

若目标网站有反爬机制(如验证码、IP限制),需设置代理IP或使用selenium模拟浏览器行为,动态页面抓取示例:

from selenium import webdriver driver = webdriver.Chrome() driver.get(url) html = driver.page_source driver.quit()

数据解析与提取

获取HTML后,使用BeautifulSoup解析页面结构,通过浏览器开发者工具定位目标元素(如岗位名称、薪资、公司信息等),提取数据。

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html.parser")

jobs = soup.find_all("div", class_="job-item")

for job in jobs:= job.find("h3", class_="title").text.strip()

salary = job.find("span", class_="salary").text.strip()

company = job.find("p", class_="company").text.strip()

print(f"岗位:{title},薪资:{salary},公司:{company}")

数据存储与处理

提取的数据可存储为CSV、Excel或数据库,使用pandas保存为CSV示例:

import pandas as pd

data = []

for job in jobs:

data.append({

"title": title,

"salary": salary,

"company": company

})

df = pd.DataFrame(data)

df.to_csv("jobs.csv", index=False, encoding="utf-8-sig")

反爬应对策略

- User-Agent轮换:维护一个User-Agent列表,每次请求随机选择。

- IP代理池:使用免费或付费代理IP,避免单一IP被封。

- 请求频率控制:通过

time.sleep()设置请求间隔,模拟人类操作。 - 验证码处理:简单验证码可通过第三方接口识别,复杂验证码需人工干预或使用OCR工具。

动态页面处理

对于JavaScript渲染的页面(如BOSS直聘),需使用selenium或Playwright,示例代码:

from selenium.webdriver.common.by import By

driver = webdriver.Chrome()

driver.get("https://www.zhipin.com/job_detail")

jobs = driver.find_elements(By.CLASS_NAME, "job-card-wrapper")

for job in jobs:= job.find_element(By.CLASS_NAME, "job-name").text

print(title)

driver.quit()

法律与道德注意事项

爬虫开发需遵守目标网站的robots.txt协议(如https://www.zhipin.com/robots.txt),避免抓取禁止访问的页面,控制抓取频率,避免对服务器造成过大压力,商业用途需确保数据合法性,必要时联系平台获取授权。

常见问题与优化

- 数据重复抓取:通过记录已抓取的URL或时间戳去重。

- 数据清洗:使用正则表达式或字符串处理方法统一数据格式(如薪资范围标准化)。

- 多线程/异步抓取:使用

concurrent.futures或asyncio提高效率,但需注意目标网站的并发限制。

相关问答FAQs

Q1: 如何应对招聘网站的IP封锁?

A1: 可采用以下方法:① 使用代理IP池,定期更换IP地址;② 降低请求频率,例如每两次请求间隔3-5秒;③ 模拟登录操作,维持会话状态(如使用requests.Session);④ 若封锁严重,可考虑分布式爬虫框架(如Scrapy-Redis)。

Q2: 抓取的数据如何进行有效分析?

A2: 可通过以下步骤分析:① 使用pandas清洗数据(处理缺失值、标准化薪资格式);② 用matplotlib或seaborn可视化薪资分布、行业需求趋势;③ 结合jieba分词库进行岗位描述关键词提取,分析热门技能;④ 通过scikit-learn构建模型预测薪资影响因素,分析结果可生成报告或动态仪表盘(如使用Plotly)。