阿里Spark招聘是阿里巴巴集团针对大数据计算引擎Spark相关岗位的人才招募活动,旨在吸引具备分布式系统、大数据处理、高性能计算等技术能力的专业人才,支撑阿里在大数据领域的业务创新和技术突破,作为全球领先的科技公司,阿里巴巴每天需要处理海量的业务数据,包括用户行为、交易记录、物流信息等,这些数据的存储、计算和分析离不开高效的大数据技术栈,而Spark作为其中的核心引擎,其性能优化、架构升级和应用落地对阿里业务发展至关重要。

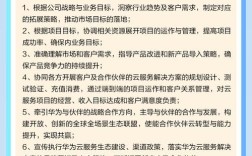

在招聘需求方面,阿里Spark岗位涵盖多个技术方向,以满足不同业务场景的需求,从技术深度来看,岗位可分为Spark内核研发工程师、Spark平台开发工程师、Spark应用优化工程师等,内核研发工程师主要负责Spark框架本身的性能调优、新特性开发,比如改进任务调度机制、优化内存管理、提升Shuffle效率等,需要深入理解Spark源码和分布式系统原理;平台开发工程师则聚焦于构建基于Spark的大数据平台,负责平台的稳定性、易用性和扩展性,例如设计统一的任务提交界面、开发监控告警系统、集成其他大数据组件等;应用优化工程师更贴近业务,需要针对阿里具体业务场景(如推荐系统、实时计算、离线数据分析)设计Spark解决方案,解决数据倾斜、性能瓶颈等问题,提升数据处理效率,随着云原生和实时计算的发展,阿里也急需具备Spark on Kubernetes、Spark Structured Streaming、Spark MLlib机器学习应用等能力的复合型人才。

在任职要求上,阿里Spark岗位通常对候选人的技术背景、工程能力和业务理解力有较高标准,学历方面,本科及以上学历是基本要求,硕士或博士在知名院校相关专业(计算机科学、软件工程、数据科学等)毕业的候选人更具竞争力,技术能力上,扎实的Java/Scala编程基础是必备条件,熟悉JVM原理、多线程编程和分布式算法;深入理解Spark核心模块(如Core、SQL、Streaming、MLlib)的架构和工作原理,具备源码阅读和二次开发能力;熟悉Hadoop、Hive、Flink、Kafka等大数据生态组件,了解它们与Spark的协同工作方式;掌握性能优化方法,能够通过Spark UI、 profiling工具定位并解决内存泄漏、GC频繁、任务倾斜等问题;对于高级岗位,还需具备大规模集群(千节点以上)运维经验,或对云原生技术(如Kubernetes、容器化)有深入实践,良好的问题解决能力、沟通协作能力和对业务的敏感度也是阿里非常看重的素质,毕竟技术最终要服务于业务,比如在双11等大促活动中,Spark集群的稳定性和高效直接关系到业务体验。

阿里为Spark人才提供了具有竞争力的薪酬福利和广阔的发展空间,薪酬方面,根据岗位级别和候选人经验,薪资范围通常在30k-80k/月甚至更高,同时包含年终奖、股票期权等长期激励,确保优秀人才能够获得与能力相匹配的回报,福利体系上,除五险一金、补充商业保险、带薪年假等常规福利外,还提供免费三餐、年度体检、住房补贴、子女教育辅助等,解决员工的后顾之忧,职业发展方面,阿里建立了完善的工程师成长体系,从初级工程师到资深技术专家、架构师,再到技术管理者,都有清晰的晋升路径,员工可以参与阿里内部的技术分享、培训课程,接触全球领先的大数据项目,比如支撑双11实时交易数据处理、构建智能推荐系统的底层计算引擎等,在实践中快速提升技术能力,阿里鼓励技术创新,员工可以申请专利、发表论文,参与开源社区贡献,甚至主导Spark相关的新项目孵化,实现个人价值与技术的共同成长。

对于求职者而言,准备阿里Spark面试需要系统性地梳理知识体系,并结合实际项目经验进行深化,技术面试通常包括基础知识点考察、编程能力测试、场景题分析和系统设计题,基础知识点可能涉及Spark的RDD、DataFrame、Dataset的区别与联系,宽依赖与窄依赖的影响,Shuffle的过程优化,内存管理机制(如堆内内存、堆外内存、Tungsten优化)等;编程能力可能要求现场编写Spark SQL优化代码或Scala程序解决特定问题;场景题可能针对数据倾斜、动态资源分配、实时流处理中的 Exactly-Once 保障等实际问题,考察候选人的问题解决思路;系统设计题则可能要求设计一个基于Spark的大数据处理平台,需要考虑高可用、可扩展性、成本控制等多个维度,除了技术能力,面试官还会关注候选人的项目经验,比如是否负责过千万级数据量的Spark项目,如何解决性能瓶颈,是否有过开源贡献或技术博客等,这些都能体现候选人的实践热情和技术沉淀。

相关问答FAQs:

-

问:阿里Spark岗位对学历和毕业院校有硬性要求吗?非名校毕业生有机会吗?

答:阿里招聘更看重候选人的实际技术能力和项目经验,学历和毕业院校是参考因素之一,但并非硬性要求,非名校毕业生如果具备扎实的Spark技术功底,有大规模项目实战经验(如主导过百节点以上Spark集群的性能优化),或在开源社区有贡献(如提交Spark PR、发表技术博客),同样有机会通过面试,建议非名校候选人重点准备技术面试,用实际能力和项目成果证明自己的价值。 -

问:没有Spark相关经验,但有Hadoop和Flink基础,适合投递阿里Spark岗位吗?

答:具备Hadoop和Flink基础是优势,因为大数据技术栈相通,理解分布式计算原理、熟悉数据流转过程有助于快速上手Spark,虽然缺乏直接经验,但可以通过系统学习弥补:建议深入学习Spark官方文档、阅读《Spark内核设计解析》等书籍,动手实践Spark项目(如用Spark SQL处理公开数据集、实现实时流处理任务),并在简历中突出自己的分布式系统基础和快速学习能力,投递时可选择Spark平台开发或应用优化等对综合能力要求较高的岗位,面试中重点展示自己的技术潜力和学习成果。