创作者关心的问题,这直接关系到内容的曝光度和流量获取,百度作为国内最大的搜索引擎,其抓取机制决定了哪些内容能够被收录并展示给用户,要理解百度如何抓取文章,需要从抓取原理、影响因素、优化策略等多个维度进行分析。

百度抓取文章的过程可以概括为三个主要环节:发现、抓取和收录,首先是发现环节,百度通过多种途径发现新的网页或更新内容,其中最常见的是通过已收录页面的链接(即外链和内链)进行爬取,这类似于“蜘蛛爬行”的过程,百度也会主动抓取高质量网站的新内容,以及通过站长平台提交的URL来发现页面,其次是抓取环节,百度蜘蛛根据页面的重要性、更新频率等因素决定是否抓取,并使用分布式爬虫架构高效获取页面内容,最后是收录环节,抓取到的页面会经过百度搜索引擎的索引系统处理,分析页面内容、关键词相关性、用户体验等指标,判断是否将其纳入搜索结果库。

影响百度抓取文章的因素主要包括网站基础质量、内容价值和外部信号,网站基础质量方面,网站的打开速度、移动端适配性、服务器稳定性等都会影响抓取效率,如果网站加载缓慢或频繁崩溃,百度蜘蛛可能会减少抓取频率,内容价值是核心,原创度高、信息密度大、解决用户实际需求的内容更容易被百度青睐,而重复、低质或spam内容则可能被过滤,外部信号主要指其他网站对页面的引用,即高质量的外链能够提升页面的权重,从而增加被百度抓取和收录的概率。

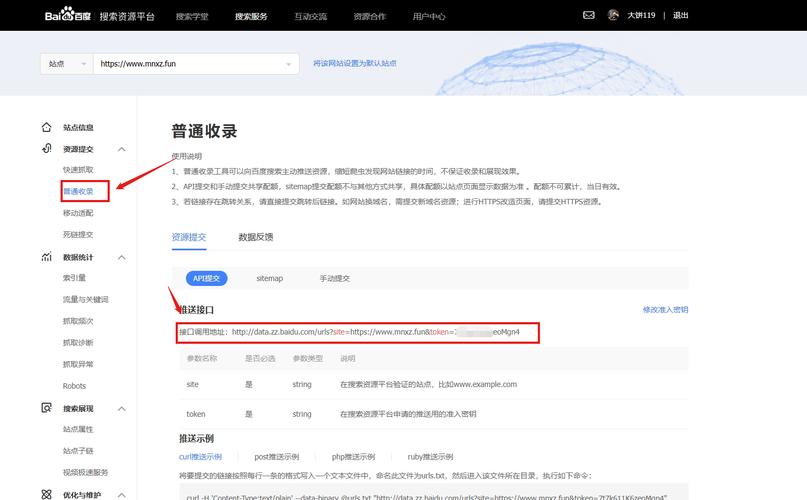

针对百度抓取文章的优化策略,可以从技术优化和内容优化两方面入手,技术优化包括确保网站结构清晰,使用扁平化的目录结构,让百度蜘蛛能够通过内链快速遍历所有重要页面;优化robots.txt文件,合理设置允许或禁止抓取的目录,避免资源浪费;创建并提交sitemap.xml,主动向百度推送网站地图,帮助蜘蛛全面发现页面内容;避免使用Flash、JavaScript等技术可能阻碍抓取的元素,确保HTML代码简洁规范,内容优化则需要坚持原创性,避免抄袭或洗稿,因为百度对原创内容的识别能力不断提升;注重内容深度,提供全面、权威的信息,满足用户的搜索意图;合理布局关键词,在标题、正文、描述等自然融入核心关键词,避免堆砌;定期更新高质量内容,保持网站的活跃度,能够吸引百度蜘蛛更频繁地访问。

为了更直观地展示百度抓取文章的关键优化点,以下通过表格对比不同优化措施的具体内容和作用:

| 优化维度 | 具体措施 | 作用说明 |

|---|---|---|

| 网站结构 | 扁平化目录、内链布局 | 减少抓取层级,帮助蜘蛛快速发现和索引页面 |

| 技术配置 | robots.txt、sitemap.xml | 引导蜘蛛抓取方向,主动推送重要页面 |

| 用户体验 | 打开速度、移动端适配 | 确保蜘蛛能够顺利抓取,同时满足用户访问需求 |

除了上述策略,利用百度站长工具也是提升抓取效率的重要手段,通过站长工具,可以提交URL、查看抓取诊断数据、分析索引量变化,及时发现并解决抓取异常问题,如果某篇文章长期未被收录,可以通过工具检查是否存在抓取失败、robots.txt禁止或内容质量过低等情况,关注百度官方的算法更新动态,如“冰桶算法”“飓风算法”等,避免触碰作弊行为(如堆砌关键词、买卖链接等),也是确保文章能够被正常抓取和收录的必要条件。

需要注意的是,百度抓取和收录之间存在时间差,即使页面被成功抓取,也不一定会立即收录,这取决于页面的综合质量和搜索需求,高质量内容的收录速度较快,而低质或同质化内容可能需要更长时间甚至无法收录,运营者应保持耐心,持续优化网站和内容,而非单纯追求收录数量。

相关问答FAQs:

-

问:为什么我的文章在百度上搜不到,但通过site命令查显示已收录?

答:这种情况通常是因为页面虽然被百度收录,但尚未进入搜索结果库,百度收录和索引是两个环节,收录仅表示页面内容被存储,而索引则表示页面被赋予关键词排名权限,可能原因包括页面权重较低、内容质量不足、竞争关键词难度过大等,建议持续优化页面内容,增加高质量外链,并通过百度站长工具提交该页面,等待百度进一步处理。 (图片来源网络,侵删)

(图片来源网络,侵删) -

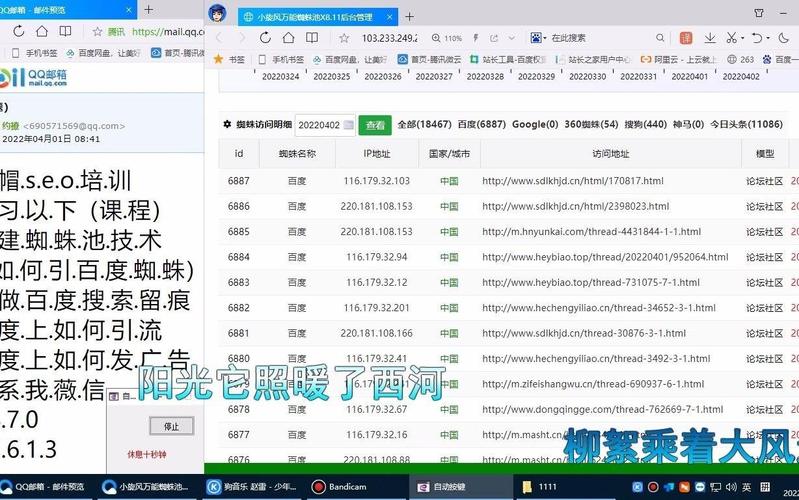

问:如何判断百度蜘蛛是否正常抓取我的网站?

答:可以通过以下方式判断:一是查看网站服务器日志,搜索“Baiduspider”标识,分析抓取频率、抓取页面类型和抓取时间;二是使用百度站长工具的“抓取诊断”功能,测试页面的可抓取性;三是观察网站在百度搜索中的收录量和索引量变化,若长期无更新或收录量下降,可能表明蜘蛛抓取异常,若发现问题,可检查网站robots.txt设置、服务器稳定性及内容更新频率,必要时联系百度站长平台反馈问题。