要探究关键词关系密度,首先需要明确这一概念的核心内涵,关键词关系密度并非单一指标,而是指在特定文本集合或领域内,核心关键词与其他相关词汇之间关联紧密程度的综合体现,它反映了词汇之间的共现频率、语义距离及逻辑依赖性,通过分析关键词关系密度,可以精准把握主题脉络、挖掘潜在关联词、优化内容布局,甚至为搜索引擎优化(SEO)、知识图谱构建、市场趋势分析等提供数据支撑,以下将从数据准备、分析方法、工具应用及结果解读等维度,详细阐述如何系统性地搜索和分析关键词关系密度。

数据准备:构建高质量分析基础

关键词关系密度的分析始于全面且精准的数据采集,首先需明确分析目标,例如是针对特定行业、竞品内容,还是全网范围内的主题讨论,根据目标确定数据源,常见的包括搜索引擎日志、社交媒体平台(如微博、知乎)、行业垂直论坛、电商平台评论、学术数据库等,若分析“新能源汽车”的关键词关系密度,可采集汽车之家论坛的用户讨论帖、微博相关话题下的博文及电商平台的产品描述文本。

数据采集后需进行预处理,这是确保分析准确性的关键步骤,预处理包括:文本清洗(去除HTML标签、特殊字符、广告信息等)、分词处理(使用结巴、HanLP等工具将连续文本切分为独立词汇,需注意处理专业术语和新词)、去停用词(去除“的”“是”等无实际意义的虚词)、词性标注(筛选名词、动词等有效词性)及词形还原(将“跑”“跑了”统一为“跑”),预处理后的数据应转化为结构化格式,如每行代表一个文本单元,每个单元包含分词后的词汇列表,为后续分析奠定基础。

关系挖掘:从共现到语义的深度关联

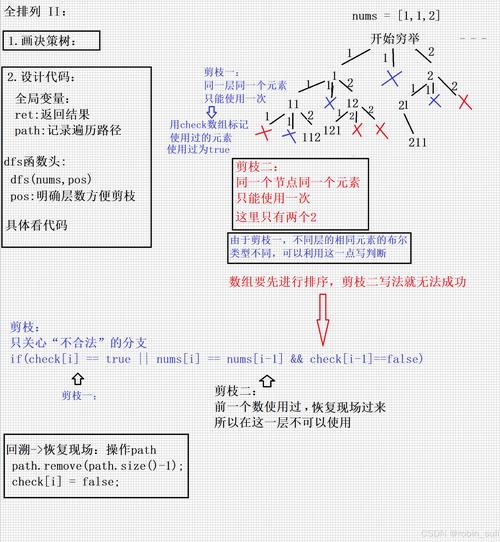

关键词关系密度的核心在于“关系”的挖掘,需从表层共现和深层语义两个层面展开,表层共现分析关注词汇在同一文本窗口(如一句话、一个段落)内的共现频率,高频共现的词汇往往具有直接关联性。“新能源汽车”常与“续航里程”“充电桩”“电池技术”等词汇共现,这些词汇的共现频次可作为关系密度的直接指标,深层语义分析则需借助自然语言处理技术,如词向量(Word2Vec、BERT)计算词汇间的余弦相似度,或使用主题模型(LDA)挖掘文本隐含主题,识别出虽不频繁共现但语义紧密相关的词汇,如“智能座舱”与“语音交互”可能在不同段落中出现,但通过语义分析可发现其强关联性。

为量化关系密度,可构建关键词共现矩阵,矩阵的行和列分别代表不同的关键词,矩阵中的值表示对应关键词在数据集中的共现次数,若“新能源汽车”与“续航里程”在1000篇文本中共同出现,共现矩阵中对应位置的值为1000,基于该矩阵,可进一步计算关系密度指标,如点互信息(PMI)、TF-IDF加权共现频率等,以排除低频词汇的干扰,突出有意义的关联关系。

工具应用:高效实现关系密度分析

分析关键词关系密度需借助专业工具,提升效率与准确性,对于中小规模数据,可使用Python编程语言结合NLTK、spaCy、jieba等库实现自动化分析,通过Python的collections.Counter统计词汇共现次数,使用scikit-learn计算TF-IDF值,或调用gensim库训练词向量模型,以下是一个简化的共现矩阵构建示例代码:

from collections import defaultdict

import jieba

# 假设preprocessed_data是预处理后的分词文本列表

preprocessed_data = [["新能源汽车", "续航", "充电桩"], ["电池", "新能源汽车", "安全"]]

# 构建共现矩阵

cooccurrence_matrix = defaultdict(lambda: defaultdict(int))

window_size = 1 # 定义共现窗口大小,如相邻1个词

for text in preprocessed_data:

for i in range(len(text)):

current_word = text[i]

# 遍历窗口内的其他词

for j in range(max(0, i-window_size), min(len(text), i+window_size+1)):

if i != j:

neighbor_word = text[j]

cooccurrence_matrix[current_word][neighbor_word] += 1

# 输出共现矩阵

for word1, neighbors in cooccurrence_matrix.items():

for word2, count in neighbors.items():

print(f"{word1} - {word2}: {count}")

对于大规模数据,可使用专业文本分析工具如KNIME、RapidMiner,或云服务(如阿里云机器学习PAI、腾讯云TI平台)进行分布式计算,知识图谱可视化工具(如Neo4j、Gephi)可将关系密度结果以图形化方式呈现,节点大小代表关键词重要性,连线粗细代表关系密度,直观展示词汇关联网络。

结果解读:从数据到 actionable insights

分析完成后,需对结果进行多维度解读,识别核心关键词及其直接关联词,通过共现频率或相似度排序,确定主题下的核心概念群。“新能源汽车”的核心关联词可能包括“电池”“电机”“电控”三大核心技术,以及“补贴”“政策”“市场”等外部因素,分析关键词的层次结构,区分强关联词(如“续航里程”与“新能源汽车”)和弱关联词(如“新能源汽车”与“二手车”),明确主题边界,关注动态变化,通过时间序列分析观察关键词关系密度的演变,新能源汽车”与“智能化”的关系密度是否随时间上升,反映技术趋势变化。

基于关系密度分析结果,可制定针对性策略:在内容创作中,增加高密度关联词的布局,提升内容与主题的相关性;在SEO优化中,围绕核心关键词及其关联词构建长尾关键词体系;在市场调研中,通过关联词挖掘用户潜在需求,如发现“充电焦虑”与“新能源汽车”高关联,可针对性推出充电解决方案。

相关问答FAQs

Q1:关键词关系密度与关键词密度有何区别?

A:关键词密度(Keyword Density)指某一关键词在文本中出现的频率占文本总词数的比例,主要用于衡量单个关键词在页面中的集中程度,属于微观层面的指标,而关键词关系密度(Keyword Relationship Density)则关注核心关键词与其他词汇之间的关联紧密程度,涉及共现频率、语义距离等多维度关系,属于宏观层面的网络分析,前者侧重“词频”,后者侧重“关系”,前者可独立存在,后者需在词汇关联网络中体现。

Q2:如何避免关键词关系密度分析中的数据偏差?

A:数据偏差主要来源于数据源单一、样本代表性不足及预处理不当,为避免偏差,首先需确保数据源的多样性,如结合搜索引擎、社交媒体、行业报告等多渠道数据;采用分层抽样等方法保证样本覆盖不同观点、时间段和用户群体;优化预处理流程,如使用专业领域词典提升分词准确性,合理设置停用词列表避免过滤有效词汇,可通过交叉验证(如对比不同工具的分析结果)或引入人工标注校验,确保结果的客观性。