招聘Hadoop相关人才是企业大数据建设中的关键环节,需要从需求梳理、渠道选择、流程设计到候选人评估等多个维度系统规划,以下从具体操作层面展开详细说明。

明确招聘需求与岗位画像

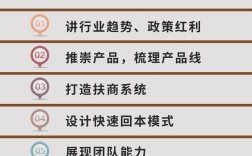

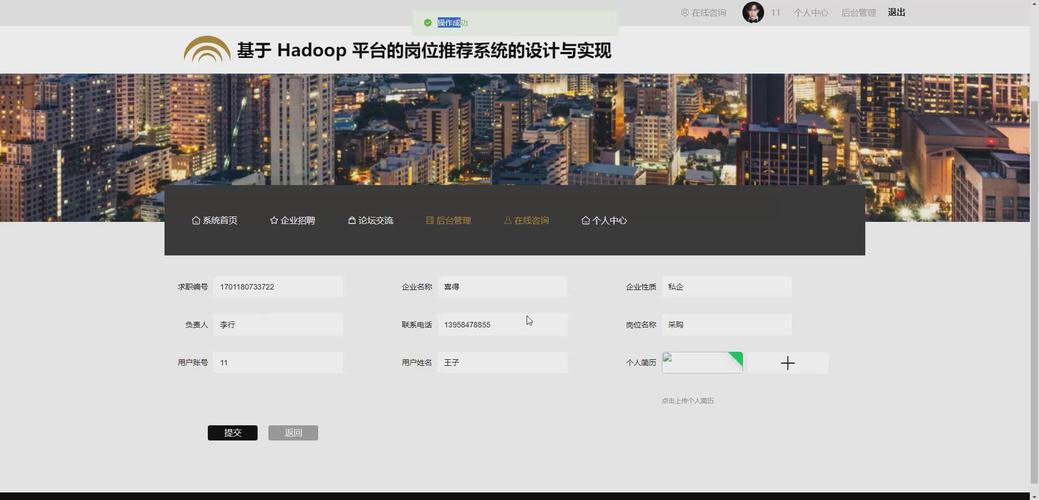

在启动招聘前,需清晰定义岗位职责与任职要求,Hadoop生态岗位通常分为开发工程师、数据工程师、平台运维工程师、数据分析师等方向,不同方向的能力模型差异较大。

- Hadoop开发工程师:需掌握Java/Scala编程,熟悉HDFS、MapReduce、YARN核心组件,了解Hive、HBase等工具的二次开发;

- 数据工程师:侧重ETL流程设计,需熟练使用Sqoop、Flume、Kafka等数据采集工具,掌握Spark/Flink等计算框架;

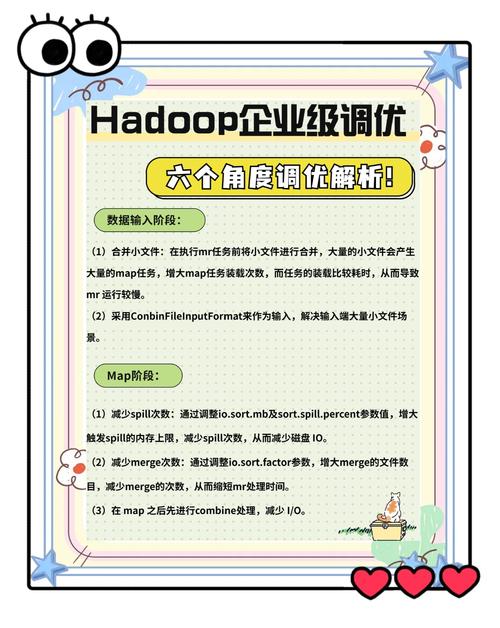

- 平台运维工程师:要求具备Linux系统管理经验,理解Hadoop集群部署、调优、故障排查,熟悉Ambari等运维工具。

建议通过技能矩阵梳理核心能力(如Hadoop底层原理、实战项目经验、业务理解能力)和加分项(如云计算平台经验、机器学习知识),形成可量化的评估标准,对于初级岗位,可侧重基础理论与实践操作能力;对于资深岗位,需考察架构设计能力和复杂问题解决能力。

选择高效的招聘渠道

针对Hadoop技术人才的特点,需组合使用线上与线下渠道:

- 专业招聘平台:在拉勾网、BOSS直聘等平台发布岗位时,需突出技术栈细节(如“负责日均PB级数据处理的Hadoop集群优化”),吸引目标候选人,猎聘等高端平台适合招聘架构师级别人才。

- 技术社区与开源平台:在CSDN、博客园、GitHub等平台发布技术文章或开源项目,可吸引被动求职者,Stack Overflow Careers、Hadoop官方社区也是精准触达开发者的渠道。

- 校园招聘与内推:与高校合作开设大数据实训课程,储备应届生资源;同时建立内推奖励机制(如推荐成功奖励5000-20000元),通过员工网络扩大人才触达范围。

- 行业会议与沙龙:参与Hadoop Summit、中国大数据技术大会等活动,既可展示企业技术实力,又能直接接触行业专家。

设计科学的招聘流程

简历筛选阶段

重点关注候选人的项目经验描述,需包含具体场景(如“解决Hadoop小文件问题”)、技术方案(如“采用HAR归档+SequenceFile优化”)和量化成果(如“任务执行效率提升30%”),对于学历背景一般的候选人,可通过GitHub代码仓库或技术博客评估其实际能力。

技术面试环节

建议采用分层面试法:

- 初试(技术基础):通过在线编程平台(如LeetCode)考察MapReduce编程能力,或设置Hive SQL优化、Hadoop集群故障排查等场景题;

- 复试(深度与广度):由技术负责人进行现场编程(如实现自定义Partitioner),并考察对YARN资源调度、HDFS读写流程等底层原理的理解;

- 终试(综合能力):结合企业实际业务场景,设计“如何设计用户行为分析系统”等开放性问题,评估架构设计能力与业务契合度。

背景调查与薪酬谈判

技术背景调查需重点核实项目真实性,可通过询问具体技术细节(如“集群宕机时的恢复步骤”)判断候选人履历真实性,薪酬谈判需结合市场行情(参考拉勾网2023年数据,Hadoop开发工程师年薪范围15-40万元)和候选人能力溢价,可采用“基本工资+项目奖金+股票期权”的组合薪酬结构。

优化候选人体验

在面试结束后24小时内反馈结果,对未通过者提供改进建议;发放offer时附上技术团队介绍和发展路径图;入职前安排技术导师制定3个月培养计划,包括Hadoop集群搭建实战、业务系统对接等培训内容。

人才保留与培养

招聘完成后,需通过技术分享会、内部竞赛(如Hadoop性能优化大赛)等方式保持团队活力,建立清晰的晋升通道(如初级工程师→技术专家→架构师),避免人才流失。

常见招聘问题与解决方案

Q1:如何识别简历中的“水分”?

A:可通过以下方式验证:1)要求候选人提供GitHub项目链接或技术博客,评估代码质量;2)面试中追问项目细节,如“Hadoop集群的DataNode宕机次数及处理措施”;3)设置实际操作测试,如要求现场编写MapReduce程序处理特定数据集。

Q2:应届生缺乏Hadoop项目经验怎么办?

A:可通过“理论+实训”模式培养:1)筛选具备扎实数据结构、算法基础和Linux操作能力的应届生;2)安排为期1个月的Hadoop生态培训(包括集群部署、MapReduce开发等);3)设置模拟项目(如电商用户行为分析系统),通过导师带教积累实战经验。