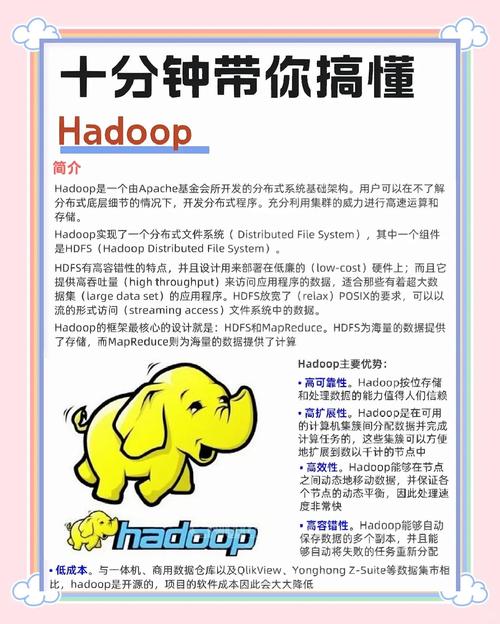

招聘Hadoop相关人才需要系统性的策略,从需求定义到渠道选择、面试评估再到入职培养,每个环节都需精准把控,企业需明确Hadoop岗位的具体需求,包括技术栈方向(如HDFS、MapReduce、YARN、Hive、HBase、Spark等)、项目经验要求(如大数据平台搭建、数据仓库建设、实时数据处理等)以及团队协作能力,根据岗位层级(初级、中级、高级)细化职责,例如初级工程师可能侧重基础组件的使用和ETL开发,而高级工程师则需要具备架构设计、性能优化和团队管理能力,在明确需求后,需制定清晰的岗位说明书,突出技术要求和软性技能,如问题解决能力、沟通能力等,吸引合适的候选人。

招聘渠道的选择直接影响人才获取效率,线上渠道中,专业招聘平台(如拉勾网、BOSS直聘)的IT板块精准度高,可设置Hadoop相关关键词筛选;技术社区(如CSDN、博客园、GitHub)聚集了大量开发者,可通过发布技术文章、参与开源项目或举办线上技术沙龙吸引人才;猎聘渠道适合中高端岗位,猎头凭借人脉资源可快速触达被动求职者,线下渠道方面,行业技术峰会(如Hadoop Summit、中国大数据技术大会)是结识顶尖人才的机会,高校合作(如实习基地、校园招聘)则有助于培养初级人才储备,内部推荐也是高效渠道,通过员工网络推荐往往能找到文化契合度高的候选人,可设置推荐奖励机制激励参与。

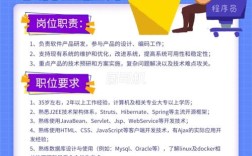

简历筛选阶段需重点关注候选人的技术背景和项目经验,首先查看学历和专业背景(计算机相关专业优先),但更应关注实际项目案例,例如是否参与过Hadoop集群搭建(规模、节点数)、数据处理量级(TB/PB级)、使用的核心组件及解决的问题(如性能优化、故障排查),技术博客或GitHub贡献可作为加分项,反映候选人的技术热情和持续学习能力,对于高级岗位,需考察架构设计能力,如是否设计过分布式数据解决方案,如何平衡性能、成本和可扩展性。

面试环节需采用多维度评估方式,技术面试可通过编程题(如MapReduce实现词频统计)、场景题(如处理数据倾斜的方案)和深度提问(如HDFS的读写流程、YARN的资源调度机制)考察专业能力;项目面试要求候选人详细描述项目背景、技术选型、遇到的挑战及解决方案,评估其实战经验;行为面试则通过情景问题(如如何与团队协作解决技术分歧)判断沟通能力和团队适应性,对于高级岗位,可增加技术答辩环节,考察其技术视野和行业趋势理解。

入职后的培养机制同样重要,企业应为新人提供系统的Hadoop技术培训,包括组件原理、实践操作和项目实战;安排导师制,由资深工程师指导快速融入团队;设置明确的晋升路径,鼓励考取相关认证(如ClouderaCCA、HortonworksHDP),提升专业能力,营造开放的技术氛围,鼓励参与技术分享和开源项目,保持团队技术活力。

相关问答FAQs

Q1:Hadoop招聘中,学历和经验哪个更重要?

A1:两者需综合评估,但经验通常更重要,对于初级岗位,学历可作为筛选基础,但实际项目经验(如实习、个人项目)更能体现动手能力;中高级岗位则更看重经验,包括项目规模、技术深度和解决问题的能力,学历可适当放宽,一个有3年PB级数据处理经验的候选人,即使学历普通,其价值也可能高于应届硕士。

Q2:如何判断候选人是否具备真实的Hadoop项目经验?

A2:可通过细节追问验证,“请描述你参与的Hadoop集群规模,遇到过哪些性能问题,如何优化?”“你在项目中使用的Hive版本,是否遇到过元数据管理问题,如何解决?”“能否举例说明Spark与MapReduce在项目中的选型依据?”真实项目经验会有具体的技术细节、数据支撑和反思总结,而夸大或虚构经验的候选人往往回答模糊,缺乏逻辑性。