当发现网站没有robots.txt文件时,这一问题看似微小,但实际上可能对网站的搜索引擎优化(SEO)、内容抓取效率乃至隐私保护产生一系列连锁影响,robots.txt文件作为搜索引擎爬虫访问网站时的“第一道指令”,其缺失可能导致搜索引擎无法准确理解网站的抓取意图,甚至因过度抓取而消耗服务器资源,解决这一问题需要系统性的排查、创建与维护,以下从问题影响、解决方案、最佳实践及后续管理等多个维度展开详细说明。

网站没有robots.txt的潜在影响

robots.txt文件的主要作用是告知搜索引擎爬虫哪些页面可以抓取,哪些页面需要禁止抓取,当该文件缺失时,搜索引擎会默认抓取网站中所有可访问的公开链接,这可能带来以下问题:

- SEO效率降低:搜索引擎可能因无法识别网站的核心内容或优先级页面,而将抓取资源分配给非重要页面(如搜索结果页、归档页等),导致关键页面收录延迟或权重下降。

- 服务器资源浪费:搜索引擎爬虫频繁抓取大型动态页面或重复内容,可能增加服务器负载,尤其在网站流量较大时,甚至可能导致访问速度变慢或宕机。

- 隐私泄露风险:若网站存在后台管理页面、测试环境或用户隐私数据目录等敏感路径,robots.txt的缺失可能导致这些页面被搜索引擎索引,进而引发信息安全问题。

- 问题:对于存在多个版本URL的网站(如http与https、带www与不带www),搜索引擎可能因缺乏指令而同时收录不同版本,导致内容稀释,影响SEO表现。

解决网站没有robots.txt的具体步骤

(一)确认robots.txt的缺失状态

首先需要明确网站是否真的没有robots.txt文件,可通过以下方式验证:

- 在浏览器地址栏输入

https://www.yourdomain.com/robots.txt(将yourdomain.com替换为实际域名),若返回404错误或空白页面,则确认文件缺失。 - 使用站长工具(如Google Search Console、百度搜索资源平台)的“robots.txt测试”功能,检查文件是否存在及语法是否正确。

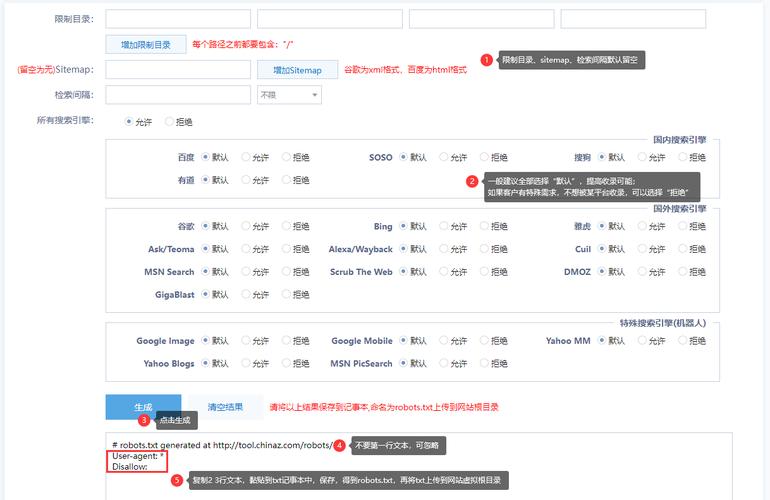

(二)创建符合规范的robots.txt文件

若确认文件缺失,需立即创建并上传至网站根目录(即域名直接指向的文件夹,如public_html或www),创建步骤如下:

-

确定网站结构与抓取需求

在创建文件前,需梳理网站结构,明确以下内容: (图片来源网络,侵删)

(图片来源网络,侵删)- 允许抓取的目录:如公开的文章、产品页面等。

- 禁止抓取的目录:如后台管理页(

/admin/)、动态参数页(如?id=)、重复内容页(如打印版页面/print/)。 - 抓取优先级:通过

Crawl-delay指令控制爬抓取间隔(适用于部分搜索引擎,如百度)。

-

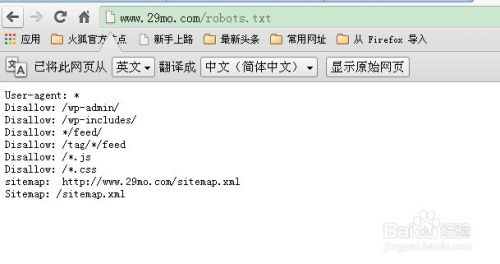

编写robots.txt语法

robots.txt文件基于简单的文本语法,常用指令包括:User-agent:指定搜索引擎爬虫名称(如代表所有爬虫,Googlebot代表谷歌爬虫)。Allow/Disallow:允许或禁止抓取的路径(Disallow:表示禁止所有,Disallow:表示允许所有)。Sitemap:指定网站地图的路径(可选,但推荐添加)。

示例代码:

User-agent: * Allow: / Disallow: /admin/ Disallow: /test/ Disallow: /*.php$ Crawl-delay: 1 Sitemap: https://www.yourdomain.com/sitemap.xml语法注意事项:

- 指令区分大小写(如

User-agent与user-agent不同),路径区分大小写(Linux服务器环境下)。 - 禁止抓取动态参数时,需使用通配符(如

Disallow: /*?id=)。 - 若需允许所有抓取,可写

User-agent: *\nDisallow:或直接不写Disallow指令。

-

上传文件至服务器

创建完成后,通过FTP工具(如FileZilla)或网站后台文件管理器,将robots.txt文件上传至根目录,确保文件名全为小写且无扩展名(如.txt后缀可能导致部分搜索引擎无法识别)。 (图片来源网络,侵删)

(图片来源网络,侵删)

(三)验证robots.txt的有效性

文件上传后,需再次通过以下方式验证:

- 手动测试:在浏览器访问

/robots.txt是否正确显示。 - 工具验证:使用Google Search Console的“robots.txt测试器”或百度搜索资源平台的“robots.txt文件检测”,查看是否存在语法错误或路径冲突。

- 搜索引擎抓取模拟:通过“抓取方式”中的“以Googlebot抓取”功能,模拟搜索引擎行为,确认禁止抓取的路径是否被正确拦截。

(四)定期维护与更新

robots.txt并非一成不变,需随网站结构调整进行维护:

- 网站改版或结构调整时:及时更新禁止/允许抓取的路径,避免因旧路径失效导致404错误。

- 新增敏感内容时:如临时测试页面或用户数据目录,需立即添加

Disallow指令。 - 监控robots.txt状态:通过站长工具设置警报,当文件被意外删除或修改时及时收到通知。

robots.txt创建的最佳实践

| 场景 | 推荐配置 |

|---|---|

| 新闻资讯类网站 | 允许抓取文章目录(/articles/),禁止抓取广告页(/ads/)、搜索结果页(/search?=) |

| 电商类网站 | 允许抓取商品详情页(/products/),禁止抓取购物车(/cart/)、用户评价(/reviews/temp/) |

| 企业官网 | 允许抓取所有公开页面,禁止抓取后台(/admin/)、邮箱(/contact.php中的邮箱参数) |

| 多语言/移动端适配网站 | 指定主版本URL(如Disallow: /mobile/),避免重复内容 |

相关问答FAQs

问题1:robots.txt文件禁止抓取的页面是否还会被搜索引擎收录?

解答:不一定,robots.txt仅禁止爬虫抓取页面内容,但若该页面已被其他网站链接或通过sitemap提交,搜索引擎仍可能通过其他途径发现并尝试收录,robots.txt不禁止用户直接访问,因此敏感内容仍需配合noindex标签或密码保护才能真正隐藏。

问题2:robots.txt文件中的Sitemap指令必须添加吗?它和站点地图有什么区别?

解答:Sitemap指令非强制,但强烈推荐添加,它的作用是引导搜索引擎快速找到网站地图文件(如sitemap.xml),从而更高效地发现所有页面,与robots.txt的区别在于:robots.txt是“抓取规则”,而sitemap是“页面清单”,两者互补使用可最大化SEO效果,即使robots.txt禁止了部分目录,sitemap仍可列出允许抓取的页面,确保重要内容不被遗漏。