随着大数据技术的快速发展,Spark作为分布式计算框架的核心工具,已成为企业数据处理与分析领域的重要技术栈,相关岗位需求持续攀升,Spark开发招聘不仅要求候选人掌握核心原理,还需具备工程实践与场景落地的综合能力,以下从岗位需求、技能要求、招聘流程及发展趋势等方面展开分析。

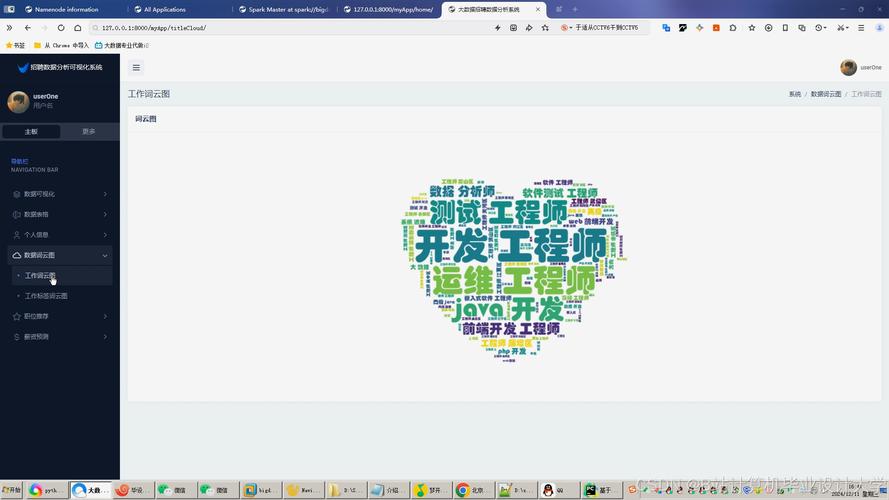

在岗位需求层面,Spark开发工程师通常分为数据开发、实时计算、机器学习工程化等方向,数据开发方向侧重离线数据处理,负责设计ETL流程、构建数据仓库,要求熟悉Spark SQL、DataFrame操作及调度工具;实时计算方向聚焦Flink与Spark Streaming的协同,需掌握Kafka数据源、Exactly-Once语义及状态管理;机器学习工程化则要求结合Spark MLlib实现模型训练与部署,了解特征工程、模型评估等全流程,大型企业常要求候选人具备行业知识,如金融领域的风控模型、电商领域的用户画像等,以推动技术业务深度融合。

技能要求方面,技术基础是核心门槛,Spark原理需深入理解RDD、DAG调度、内存管理机制,能优化Shuffle性能、解决数据倾斜问题;编程语言以Scala为主(需掌握函数式编程、模式匹配),同时兼顾Python(PySpark)生态;工程能力则包括与Hadoop、Hive、HBase等组件的协同,以及YARN资源调优、动态分区配置等实践,工具链上,需熟悉Airflow、Oozie调度系统,Git版本控制,Docker容器化部署,以及Prometheus监控体系,软技能方面,强调问题定位能力(如通过Spark UI分析任务瓶颈)、跨团队协作意识及文档撰写能力,以保障项目高效交付。

招聘流程通常分为简历初筛、技术面试、综合面试及HR面,简历初筛重点关注项目经验描述,需明确Spark版本、数据处理量级(如日处理TB级数据)、性能优化案例(如将任务运行时间从3小时缩短至30分钟),技术面试以笔试+现场编程为主,笔试题涵盖Spark核心概念(如宽窄依赖区别)、SQL优化(如谓词下推、分区裁剪)及故障排查(如内存溢出、序列化问题);编程题常实现TopN统计、关联查询等场景,综合面试考察业务理解能力,例如针对“如何设计实时用户行为分析系统”问题,需从数据采集、清洗、实时计算到结果展示给出完整方案,HR面则关注职业稳定性,如对技术趋势的判断(如Spark Structured Streaming与Flink的对比)及团队适配度。

Spark开发招聘将呈现三大趋势:一是云原生与Serverless结合,要求候选人掌握Spark on Kubernetes、EMR Serverless等云服务;二是AI融合,需结合LLM实现智能数据处理,如使用Spark SQL生成代码、自动化调优;三是实时批一体,Structured Streaming与Batch API的统一将成为重点,候选人需具备流批一体的架构设计能力。

相关问答FAQs

Q1:Spark开发岗位中,Scala和Python哪个更重要?

A1:两者各有侧重,Scala是Spark的原生语言,掌握Scala能更深入理解Spark底层机制(如源码级优化),适合从事框架开发、性能调优等核心岗位;Python凭借易用性和PySpark生态,在数据探索、快速原型开发中应用广泛,对于业务型数据开发岗位更为实用,建议根据岗位方向选择:技术深耕优先Scala,业务落地优先Python,同时掌握两者更具备竞争力。

Q2:如何准备Spark开发岗位的技术面试?

A2:分三阶段准备:一是理论巩固,系统梳理Spark核心概念(如RDD vs DataFrame、Shuffle原理)、常用API及调优参数(如spark.sql.shuffle.partitions、executor-memory);二是项目复盘,提炼1-2个深度参与的项目,重点说明技术难点(如数据倾斜解决方案)、优化效果(如资源利用率提升30%)及业务价值;三是实战练习,通过LeetCode数据库题、Spark官方示例(如《Spark权威指南》案例)提升编码能力,同时熟悉Spark UI、日志分析等工具的使用,确保能快速定位问题。