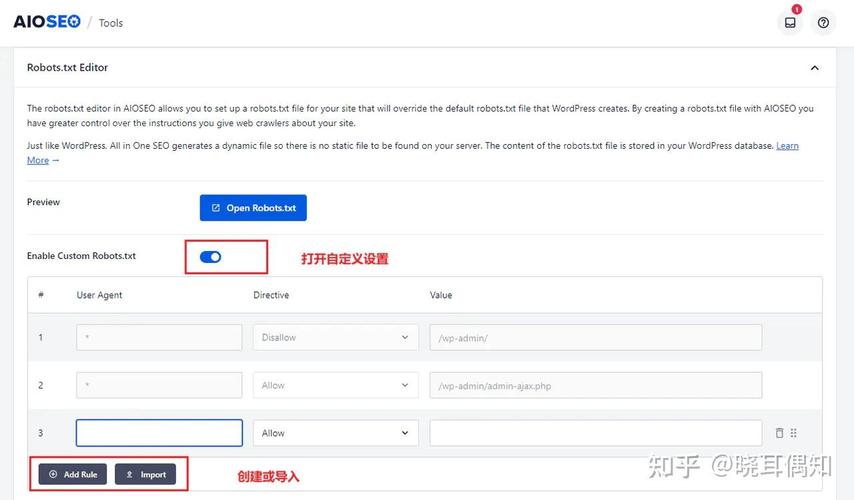

要查看网站的robots.txt文件,可以通过多种方法实现,这一文件通常位于网站根目录下,用于指导搜索引擎爬虫的抓取行为,以下是详细的操作步骤和注意事项:

通过浏览器直接访问

最简单的方式是在浏览器地址栏中输入目标网站的robots.txt路径,要查看百度网站的robots.txt,可直接访问“https://www.baidu.com/robots.txt”,浏览器会显示文件内容,通常包含User-agent(指定爬虫名称)、Disallow(禁止抓取的路径)、Allow(允许抓取的路径)以及Sitemap(网站地图链接)等指令,若网站未设置robots.txt,访问时会返回404错误,此时说明该文件不存在。

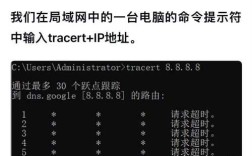

使用命令行工具

对于开发者或技术用户,可通过命令行工具快速查看,以Windows系统为例,打开命令提示符(CMD),输入命令curl 网站域名/robots.txt(如curl https://www.example.com/robots.txt),即可在终端获取文件内容,Linux或macOS系统同样支持此方法,若未安装curl,也可使用wget -O - 网站域名/robots.txt替代。

借助SEO工具或在线平台

非技术用户可通过在线工具便捷查看,如“robots.txt Checker”“SEMrush”或“Ahrefs”等SEO分析平台,只需输入目标网站域名,工具会自动解析并展示robots.txt内容,部分工具还会检测文件语法错误或冲突规则,浏览器插件如“SEO Meta in 1 Click”也支持直接查看当前网站的robots.txt文件。

通过网站源代码查看

在浏览器中打开目标网站,按下F12键打开开发者工具,切换至“网络”(Network)选项卡,刷新页面后,在筛选框中输入“robots.txt”,找到对应的请求并点击查看响应内容,即可获取文件详情,此方法适用于需要调试或分析文件加载情况的场景。

注意事项

- 文件位置:robots.txt必须位于网站根目录(如https://example.com/robots.txt),子目录下的同名文件无效。

- 大小限制:文件大小一般不超过500KB,过大的文件可能导致搜索引擎无法完全解析。

- 指令规范:需遵循语法规则,如Disallow与后的路径是否带斜杠(/)可能影响匹配范围(如“/disallow/”与“/disallow”效果不同)。

- 敏感信息:robots.txt仅建议爬虫抓取路径,不保证安全性,敏感内容仍需通过其他方式(如密码保护)限制访问。

以下为常见robots.txt指令示例及说明:

| 指令类型 | 示例 | 说明 |

|---|---|---|

| User-agent | User-agent: * | 针对所有搜索引擎爬虫 |

| Disallow | Disallow: /private/ | 禁止抓取/private/目录下的所有页面 |

| Allow | Allow: /public/images/ | 允许抓取/public/images/目录 |

| Sitemap | Sitemap: https://example.com/sitemap.xml | 指向网站地图的URL |

相关问答FAQs

Q1: 如果robots.txt文件不存在,网站会怎样?

A1: 若网站未设置robots.txt,搜索引擎爬虫默认可抓取所有公开页面,但建议主动创建该文件,明确抓取规则,避免误抓敏感内容或重复页面,同时通过Sitemap指令引导搜索引擎收录重要页面。

Q2: 如何验证robots.txt是否生效?

A2: 可使用Google Search Console的“robots.txt测试工具”输入网站域名,系统会模拟爬虫行为展示抓取结果;或通过“site:网站域名”指令在搜索引擎中查看实际收录情况,对比robots.txt中的禁止规则是否生效。