在Java程序中执行Hadoop命令是大数据开发中常见的需求,通常用于自动化任务管理、文件操作或集群监控,以下是详细的实现方法、代码示例及注意事项。

Java执行Hadoop命令的核心思路是通过Java的Runtime.getRuntime().exec()方法或ProcessBuilder类启动子进程,调用Hadoop的Shell命令(如hdfs dfs -ls、hadoop jar等),由于Hadoop命令依赖于Hadoop环境变量和JAR包,需确保Java程序运行环境中已正确配置Hadoop。

实现方法

使用Runtime类执行命令

Runtime类提供了exec()方法来执行系统命令,基本步骤如下:

- 构建命令字符串,需包含Hadoop命令及其参数。

- 通过

Runtime.getRuntime().exec(command)启动进程。 - 获取进程的输入流(命令输出)和错误流(错误信息)。

- 等待进程执行完毕并检查返回值。

示例代码:

import java.io.BufferedReader;

import java.io.InputStreamReader;

public class HadoopCommandExecutor {

public static void main(String[] args) {

String hadoopCommand = "hdfs dfs -ls /";

try {

Process process = Runtime.getRuntime().exec(hadoopCommand);

BufferedReader reader = new BufferedReader(new InputStreamReader(process.getInputStream()));

String line;

while ((line = reader.readLine()) != null) {

System.out.println(line);

}

int exitCode = process.waitFor();

System.out.println("Exit Code: " + exitCode);

} catch (Exception e) {

e.printStackTrace();

}

}

}

使用ProcessBuilder类(推荐)

ProcessBuilder提供了更灵活的进程管理方式,支持设置工作目录和环境变量,示例代码:

import java.io.BufferedReader;

import java.io.File;

import java.io.InputStreamReader;

import java.util.Map;

public class HadoopCommandExecutor {

public static void main(String[] args) {

String[] command = {"hdfs", "dfs", "-ls", "/"};

try {

ProcessBuilder pb = new ProcessBuilder(command);

// 设置Hadoop环境变量(需根据实际路径修改)

Map<String, String> env = pb.environment();

env.put("HADOOP_HOME", "/path/to/hadoop");

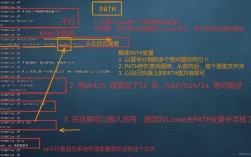

env.put("PATH", env.get("PATH") + ":/path/to/hadoop/bin");

// 启动进程

Process process = pb.start();

BufferedReader reader = new BufferedReader(new InputStreamReader(process.getInputStream()));

String line;

while ((line = reader.readLine()) != null) {

System.out.println(line);

}

int exitCode = process.waitFor();

System.out.println("Exit Code: " + exitCode);

} catch (Exception e) {

e.printStackTrace();

}

}

}

关键注意事项

-

环境变量配置

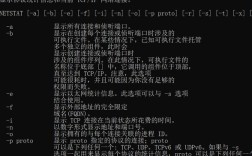

Java进程需能访问Hadoop的bin目录和配置文件(如core-site.xml),可通过ProcessBuilder的environment()方法设置环境变量,或确保Hadoop已添加到系统PATH中。 -

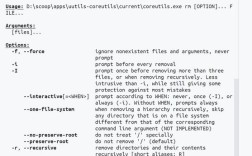

命令参数处理

Hadoop命令中的路径或参数包含空格时,需用数组形式传递参数(如String[]{"hdfs", "dfs", "-ls", "/path with space"}),避免使用字符串拼接。 -

流资源管理

进程的输入流(InputStream)和错误流(ErrorStream)需及时关闭,否则可能导致进程阻塞,建议使用try-with-resources或单独线程读取流。 -

异常处理

需捕获IOException(命令执行失败)、InterruptedException(线程被中断)等异常,并处理非零退出码(表示命令执行失败)。 (图片来源网络,侵删)

(图片来源网络,侵删) -

分布式环境权限

若Hadoop集群启用了Kerberos认证,需在Java程序中配置票据(如使用kinit或JAAS配置),否则命令会因权限问题失败。

常见场景与优化

执行HDFS文件操作

如上传文件到HDFS:

String[] command = {"hadoop", "fs", "-put", "/local/path", "/hdfs/path"};

Process process = new ProcessBuilder(command).start();

运行Hadoop MapReduce作业

String[] command = {

"hadoop", "jar", "mr.jar",

"com.example.MyJob",

"-input", "/input",

"-output", "/output"

};

并发执行多个命令

使用线程池管理多个Process实例,避免阻塞主线程:

ExecutorService executor = Executors.newFixedThreadPool(5);

for (String cmd : commands) {

executor.submit(() -> {

Process process = Runtime.getRuntime().exec(cmd);

// 处理输出

});

}

FAQs

Q1: 为什么执行Hadoop命令时提示“command not found”?

A: 通常是因为Java进程无法找到Hadoop命令,解决方案:

- 检查Hadoop是否已添加到系统PATH环境变量。

- 在

ProcessBuilder中显式设置HADOOP_HOME和PATH环境变量。 - 确保Hadoop版本与Java程序运行环境兼容(如Hadoop 3.x需Java 8+)。

Q2: 如何处理Hadoop命令执行时的中文乱码问题?

A: 乱码通常由于进程输出流的编码与系统默认编码不一致导致,解决方案:

- 指定

InputStreamReader的编码为UTF-8:BufferedReader reader = new BufferedReader(new InputStreamReader(process.getInputStream(), "UTF-8"));

- 确保Hadoop集群的配置文件(如

core-site.xml)中io.file.buffer.size和hadoop.tmp.dir等参数未强制使用非UTF-8编码。 - 若命令参数包含中文,需对参数进行URL编码(如

URLEncoder.encode())后再传递。