在使用Hadoop分布式文件系统(HDFS)时,用户可能会遇到“hdfs命令找不到”的问题,这通常是由于环境变量配置不当、Hadoop未正确安装或路径未添加到系统PATH中导致的,以下将详细分析可能的原因及解决方法,并提供常见问题的解答。

可能的原因及解决方法

-

环境变量未配置或配置错误

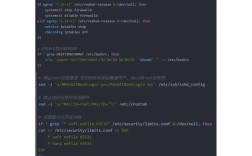

HDFS命令依赖于HADOOP_HOME和PATH环境变量,如果未正确设置,系统将无法识别hdfs命令。- 检查

HADOOP_HOME:确保该变量指向Hadoop的安装目录。export HADOOP_HOME=/usr/local/hadoop

- 检查

PATH变量:将$HADOOP_HOME/bin添加到PATH中,以便系统可执行文件:export PATH=$PATH:$HADOOP_HOME/bin

- 永久生效:将上述命令添加到

~/.bashrc或~/.bash_profile文件中,然后执行source ~/.bashrc使配置生效。

- 检查

-

Hadoop未正确安装或文件缺失

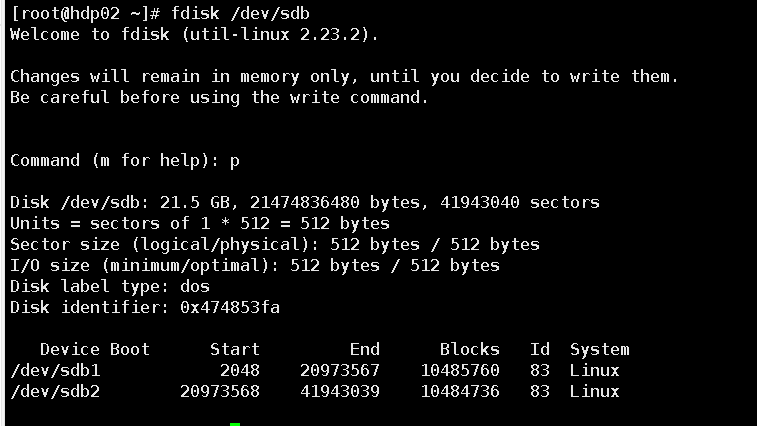

若Hadoop安装不完整或bin目录下缺少hdfs脚本,也会导致命令无法找到。- 验证安装:进入

$HADOOP_HOME/bin目录,检查是否存在hdfs可执行文件:ls $HADOOP_HOME/bin | grep hdfs

- 重新安装:若文件缺失,需重新下载并安装Hadoop,确保选择与系统匹配的版本。

- 验证安装:进入

-

权限问题

即使文件存在,若执行权限不足,系统也无法运行命令。- 添加权限:为

hdfs脚本添加可执行权限:chmod +x $HADOOP_HOME/bin/hdfs

- 添加权限:为

-

多版本Hadoop冲突

系统中可能存在多个Hadoop版本,导致PATH中优先指向了错误的目录。 (图片来源网络,侵删)

(图片来源网络,侵删)- 检查PATH:使用

echo $PATH查看当前PATH中的路径顺序,确保正确的Hadoop版本优先级更高。 - 清理冗余路径:移除其他Hadoop版本的路径或调整PATH顺序。

- 检查PATH:使用

-

Shell配置问题

某些Shell(如zsh)可能需要单独配置环境变量。- 适配zsh:若使用zsh,将环境变量添加到

~/.zshrc文件中,并执行source ~/.zshrc。

- 适配zsh:若使用zsh,将环境变量添加到

故障排查步骤总结

| 步骤 | 操作 | 命令示例 |

|---|---|---|

| 1 | 检查HADOOP_HOME |

echo $HADOOP_HOME |

| 2 | 检查PATH是否包含Hadoop bin目录 |

echo $PATH |

| 3 | 验证hdfs脚本是否存在 |

ls $HADOOP_HOME/bin/hdfs |

| 4 | 添加执行权限 | chmod +x $HADOOP_HOME/bin/hdfs |

| 5 | 重新加载环境变量 | source ~/.bashrc |

相关问答FAQs

Q1: 为什么配置了环境变量后,hdfs命令仍然找不到?

A1: 可能的原因包括:

- 未重新加载环境变量(需执行

source ~/.bashrc)。 - Shell配置文件路径错误(如误用了

~/.profile而非~/.bashrc)。 - Hadoop安装目录权限不足,导致用户无法访问。

- 系统存在多个Hadoop版本,PATH中优先指向了错误的路径,建议检查

which hdfs命令的输出,确认实际指向的路径。

Q2: 如何确认Hadoop是否已正确安装并可用?

A2: 可通过以下步骤验证:

- 检查Hadoop版本:

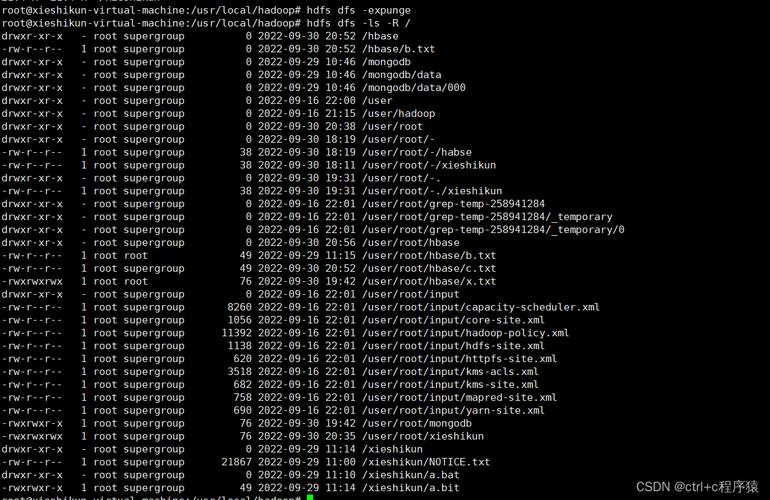

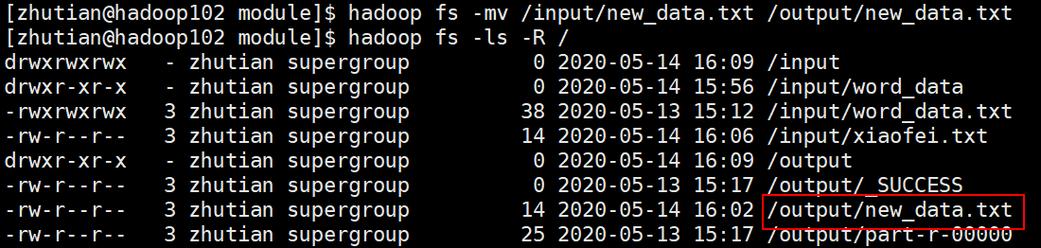

hadoop version,若显示版本信息则基本正常。 - 测试HDFS命令:

hdfs dfs -ls /,若能列出根目录内容或提示“Permission denied”,说明HDFS服务已启动但需配置权限。 - 检查日志文件:查看

$HADOOP_HOME/logs目录下的日志,排查启动错误,若命令仍报“command not found”,需重新检查环境变量和文件完整性。