在当今数据驱动的时代,爬虫技术作为数据采集的核心手段,在各行各业的应用愈发广泛,Python凭借其简洁的语法、丰富的库生态和强大的社区支持,已成为爬虫开发的首选语言,掌握Python爬虫技术的开发者在就业市场上备受青睐,薪资待遇和发展空间均十分可观,Python爬虫工程师的招聘需求主要集中在互联网、金融、电商、科研等领域,岗位名称通常包括爬虫工程师、数据采集工程师、Python开发工程师(数据方向)等。

从技能要求来看,Python爬虫招聘的核心要素包括基础语法、网络知识、爬虫框架和反反爬策略,扎实的Python基础是必备条件,需熟悉数据类型、函数、面向对象编程、异常处理等,同时掌握常用的数据处理库如Pandas、NumPy,以及HTTP请求库如Requests、Urllib,网络协议知识至关重要,需深入理解HTTP/HTTPS协议,包括请求方法(GET/POST)、请求头(Headers)、响应状态码、Cookie与Session机制,以及Ajax异步加载原理,在爬虫框架方面,Scrapy是主流选择,需掌握其核心组件(Spider、Item Pipeline、Downloader Middlewares等)的使用,以及分布式爬虫的实现(如结合Scrapy-Redis),动态网页渲染技术如Selenium、Pyppeteer也是高频考点,用于模拟浏览器行为抓取JavaScript渲染的内容。

反反爬策略是爬虫工程师的核心竞争力,涉及IP代理池的构建(如使用Requests-Proxy、Scrapy-ProxyPool)、User-Agent池的随机切换、验证码识别(OCR技术如Tesseract-OCR,或对接打码平台如打码API)、登录态维持(Cookie池、模拟登录)以及分布式架构下的去重(如Bloom Filter、Redis去重),对于大规模数据采集,还需掌握数据库存储技术,如关系型数据库MySQL(需熟悉SQL语句优化)和非关系型数据库MongoDB(适合存储非结构化数据),以及消息队列如RabbitMQ、Kafka用于任务调度。

不同行业对爬虫技术的侧重点有所不同,互联网公司通常要求高并发、分布式爬虫架构,强调数据采集效率和稳定性;金融行业更关注数据安全性和合规性,需熟悉《网络安全法》《数据安全法》等法规,避免采集敏感信息;电商领域侧重商品价格、评论等动态数据的实时监控,要求快速响应和反反爬能力;科研机构则可能需要爬取学术文献、公开数据集,对数据清洗和分析能力要求较高,薪资方面,初级爬虫工程师(1-2年经验)月薪普遍在10-20K,中级工程师(3-5年经验)可达20-40K,高级工程师或团队负责人薪资更高,且通常包含项目奖金和股票期权。

职业发展路径上,Python爬虫工程师可向数据分析师、数据工程师、算法工程师等方向转型,也可晋升为技术主管或架构师,持续学习是关键,需关注新兴技术如深度学习在反爬中的应用、大模型辅助爬虫开发等,同时提升工程化能力,如容器化部署(Docker/K8s)、云服务(AWS/Aliyun)的使用,以适应行业对复合型人才的需求。

| 技能类别 | |

|---|---|

| Python基础 | 数据类型、函数、面向对象、异常处理、Pandas/NumPy |

| 网络协议 | HTTP/HTTPS、请求/响应、Cookie/Session、Ajax原理 |

| 爬虫框架 | Scrapy框架(Spider/Pipeline/Middlewares)、Scrapy-Redis分布式 |

| 动态网页渲染 | Selenium(WebDriver)、Pyppeteer(无头浏览器) |

| 反反爬技术 | IP代理池、User-Agent池、验证码识别、登录态维持、分布式去重 |

| 数据存储 | MySQL(SQL优化)、MongoDB(非结构化数据)、Redis(缓存/去重) |

| 工具与部署 | Git版本控制、Docker容器化、Linux服务器运维、云服务使用 |

相关问答FAQs

-

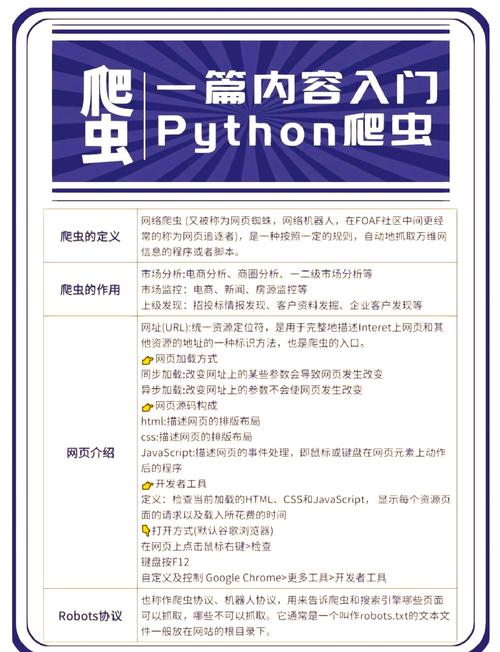

问:学习Python爬虫需要具备哪些基础知识?

答:学习Python爬虫前需掌握Python基础语法(变量、循环、函数、类等),了解网络协议(HTTP请求/响应、URL结构、Cookie/Session机制),熟悉常用数据结构(列表、字典、集合等),了解HTML和CSS基础有助于解析网页结构,掌握基本数据库操作(如MySQL增删改查)对数据存储也有帮助。 -

问:Python爬虫工程师如何应对网站的反爬机制?

答:应对反爬需多维度策略:①设置合理的请求间隔(如time.sleep)避免高频请求;②使用代理IP池(如免费代理、付费代理服务)防止IP被封;③随机切换User-Agent模拟不同浏览器;④处理验证码(OCR识别或对接打码平台);⑤模拟登录维持Cookie或Session;⑥使用Selenium/Pyppeteer渲染动态页面;⑦采用分布式架构(Scrapy-Redis)降低单机压力,并通过Bloom Filter实现去重,同时需遵守网站robots协议和法律法规,避免过度采集。