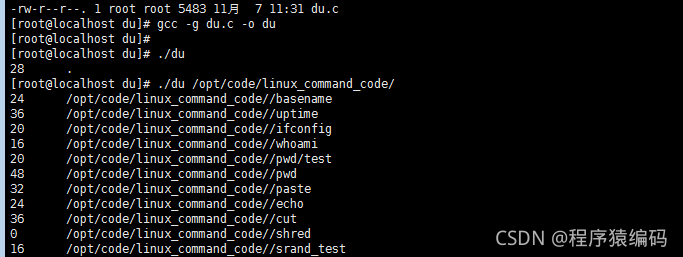

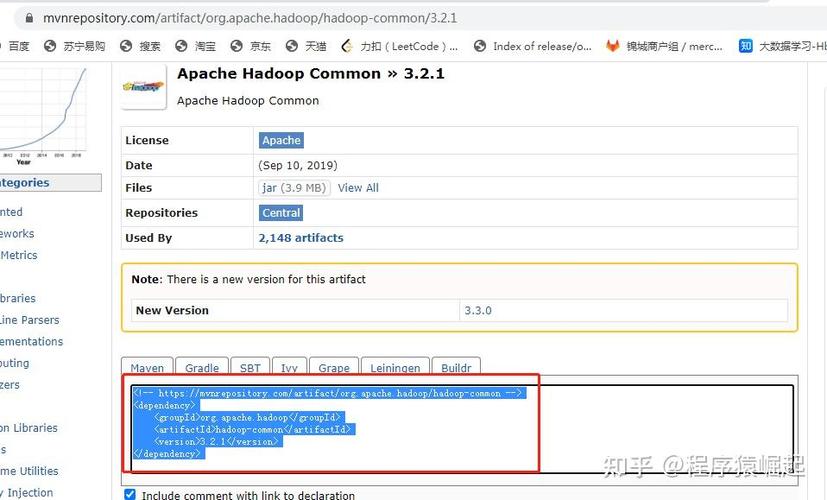

HDFS(Hadoop Distributed File System)作为大数据生态系统的核心存储组件,其命令行工具提供了丰富的操作接口,用于管理分布式文件系统中的数据。hdfs dfs -du 命令是用户日常运维和数据分析中高频使用的工具,主要用于查看文件或目录的磁盘占用情况,通过该命令,管理员和开发者可以快速定位大文件、分析存储使用模式、优化数据分布,从而有效管理HDFS集群的存储资源,本文将围绕hdfs dfs -du命令的功能、语法、参数、使用场景及注意事项展开详细说明,并结合实例帮助用户深入理解其应用方法。

hdfs dfs -du命令的基本功能与语法

hdfs dfs -du命令的核心功能是显示HDFS指定路径下文件或目录的大小信息,与Linux文件系统中的du命令类似,它以字节为单位返回数据占用的空间,但针对分布式环境的特点,HDFS的du命令会额外考虑副本因子、块存储位置等分布式特性,其基本语法格式如下:

hdfs dfs -du [-s] [-h] [-v] [-x] <paths>...

<paths>为必选参数,可以是一个或多个文件/目录路径,支持通配符(如/user/data/*.txt),可选参数则用于控制输出格式和内容,具体参数说明如下表所示:

| 参数 | 全称 | 功能描述 |

|---|---|---|

-s |

summarize | 汇总显示指定路径下所有文件和子目录的总大小,而非逐个列出文件大小。 |

-h |

human-readable | 以人类可读格式显示大小(如KB、MB、GB),默认以字节为单位输出。 |

-v |

verbose | 显示详细信息,包括文件副本数、块大小、存储节点等元数据(需结合HDFS高级配置)。 |

-x |

exclude | 排除指定匹配模式的文件或目录(需配合--pathPattern使用,较新版本支持)。 |

命令参数详解与使用示例

基础用法:查看单个文件或目录大小

当不添加任何参数时,hdfs dfs -du会递归列出指定路径下所有文件和子目录的大小,并显示每个文件的完整路径及其占用字节数,查看/user/data目录下的文件大小:

hdfs dfs -du /user/data

输出示例:

2023 /user/data/file1.txt

5120 /user/data/file2.log

10240 /user/data/subdir/上述输出表示file1.txt占用2023字节,file2.log占用5120字节,subdir目录占用10240字节(包含其子文件总大小)。

使用-s参数汇总目录总大小

若仅需查看目录的总存储占用(不包含子目录明细),可通过-s参数实现,汇总/user/data目录的总大小:

hdfs dfs -du -s /user/data

输出示例:

17383 /user/data此时输出仅显示目录路径及其总占用字节数(17383=2023+5120+10240)。

使用-h参数优化可读性

默认情况下,hdfs dfs -du以字节为单位输出,对于大文件可读性较差,添加-h参数后,结果会自动转换为KB、MB或GB等单位。

hdfs dfs -du -h /user/data

输出示例:

0K /user/data/file1.txt

5.0K /user/data/file2.log

10.0K /user/data/subdir/结合-s和-h参数实现汇总与可读性兼顾

在实际运维中,常需同时汇总目录大小并优化显示格式,此时可组合使用-s和-h参数。

hdfs dfs -du -sh /user/data

输出示例:

0K /user/data高级应用场景与注意事项

分析集群存储使用情况

hdfs dfs -du命令常用于排查集群存储瓶颈,通过查看用户目录的存储占用,定位占用空间过大的用户或目录:

hdfs dfs -du -sh /user/* | sort -hr | head -10

上述命令会按存储大小降序排列前10个用户目录,帮助管理员快速识别存储大户。

验证文件副本对存储的影响

HDFS中文件默认存储3个副本,因此实际物理占用为文件大小的3倍,通过hdfs dfs -du计算逻辑大小(副本数×文件大小)与物理大小的差异,可验证副本配置是否合理。

hdfs dfs -du /user/data/largefile

若输出为1073741824 /user/data/largefile,表示文件逻辑大小为1GB,实际物理占用为3GB(假设副本数为3)。

注意事项

- 递归查询性能:对大目录(如包含百万级文件)使用

hdfs dfs -du时,递归查询可能较慢,建议结合-s参数减少输出数据量。 - 快照与回收站影响:若目录包含HDFS快照或回收站文件,

hdfs dfs -du默认会计算这些文件的大小,需通过-Ddfs.snapshot.delete.option=skip等参数排除。 - 权限问题:仅对有读取权限的路径有效,若路径权限不足,命令会报错

Permission denied。

相关问答FAQs

Q1: hdfs dfs -du与hdfs dfs -dus有什么区别?

A: hdfs dfs -dus是hdfs dfs -du -s的旧式写法,功能完全相同,均用于汇总指定路径的总大小,新版本Hadoop推荐使用-s参数,-dus已逐渐废弃,但为兼容性仍可使用。

Q2: 如何使用hdfs dfs -du排除特定文件(如.log文件)?

A: 可通过-x参数结合通配符排除匹配模式的文件,查看/user/data目录大小,排除所有.log文件:

hdfs dfs -du -sh -x "*.log" /user/data

若需排除多个模式,可多次使用-x参数,或使用正则表达式(需Hadoop版本支持--pathPattern参数)。