在互联网行业快速发展的背景下,企业招聘数据的采集与分析已成为人力资源领域的重要课题,针对腾讯招聘平台的爬虫技术应用,因其数据价值高、技术挑战性强,成为许多开发者和数据分析师关注的焦点,腾讯作为中国领先的互联网企业,其招聘平台汇聚了大量高端职位信息,包括技术研发、产品运营、市场营销等多个领域,这些数据不仅能为求职者提供行业趋势参考,也能为企业人力资源战略制定提供数据支持。

腾讯招聘爬虫的核心目标是从官网(如careers.tencent.com)结构化地提取职位信息,通常包括职位名称、工作地点、学历要求、薪资范围、岗位职责、任职资格等字段,为实现这一目标,开发者需综合运用多种技术手段,网络请求模拟是基础环节,由于腾讯招聘网站具备反爬虫机制,直接使用requests库发送请求可能被识别为异常行为,需通过设置User-Agent、使用代理IP池、模拟浏览器行为(如添加headers中的Referer、Cookie等信息)来降低被拦截的风险,可构造如下请求头:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

'Referer': 'https://careers.tencent.com/'

}

HTML解析与数据提取是关键步骤,腾讯招聘页面采用动态加载技术,部分职位数据通过JavaScript渲染,此时直接抓取静态HTML可能无法获取完整信息,解决方案包括两种:一是分析接口请求,通过开发者工具定位数据加载的API接口(如通过XHR请求获取的JSON数据),直接调用接口获取结构化数据;二是使用Selenium或Playwright等自动化工具模拟浏览器操作,等待页面渲染完成后提取内容,以解析职位列表为例,可通过BeautifulSoup库定位DOM节点:

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'html.parser')

job_list = soup.find_all('div', class_='recruit-list')

for job in job_list:= job.find('h4', class_='recruit-title').text.strip()

location = job.find('span', class='recruit-area').text.strip()

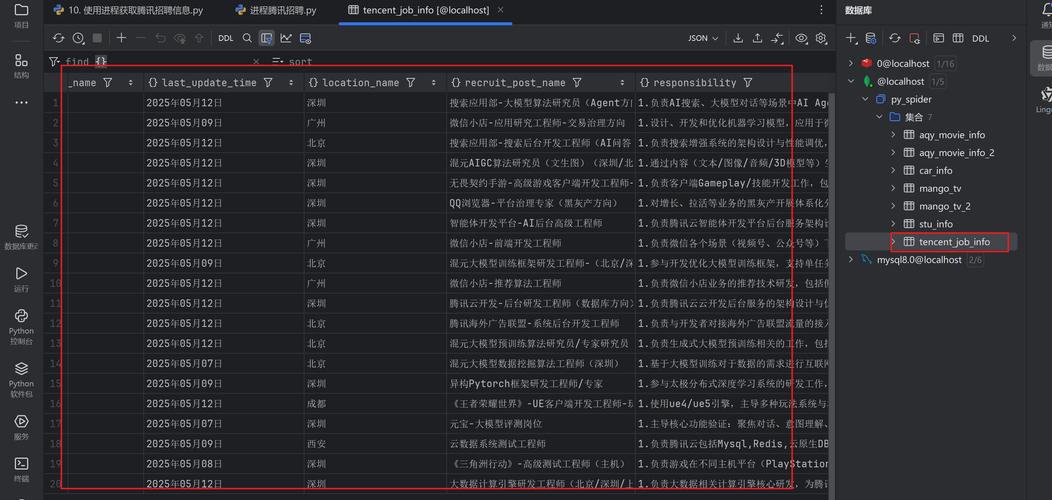

数据处理与存储是爬虫应用的最终目的,采集到的原始数据往往存在格式不统一、信息冗余等问题,需进行清洗和标准化,将薪资范围统一为“min-max”格式,对工作地点进行去重处理,存储方式可根据需求选择,MySQL等关系型数据库适合结构化数据的存储,而MongoDB等NoSQL数据库则更适合处理非结构化或半结构化数据,以下是常见数据字段的存储示例:

| 字段名 | 数据类型 | 说明 |

|---|---|---|

| job_id | VARCHAR(50) | 职位唯一标识 |

| department | VARCHAR(50) | 所属部门 |

| location | VARCHAR(50) | 工作地点 |

| salary_range | VARCHAR(30) | 薪资范围(如"15k-25k") |

| experience | VARCHAR(20) | 工作经验要求 |

| education | VARCHAR(20) | 学历要求 |

| publish_time | DATETIME | 发布时间 |

值得注意的是,腾讯招聘爬虫的应用需严格遵守法律法规与道德规范,根据《中华人民共和国网络安全法》及《个人信息保护法》,爬虫行为不得侵犯企业商业秘密或个人隐私,需设置合理的请求频率(如添加time.sleep()避免高频请求),并在robots.txt中明确爬取范围,部分企业会通过IP封禁、验证码等反爬虫技术加强防护,开发者需持续优化策略,如使用分布式爬虫、验证码识别技术等,以确保数据采集的可持续性。

相关问答FAQs:

-

问:使用腾讯招聘爬虫是否违法?

答:需根据具体行为判断,若仅采集公开的职位信息且未用于商业用途,且遵守robots协议和网站服务条款,通常属于合法行为;但若用于恶意竞争、数据倒卖或侵犯隐私,则可能构成违法,建议在使用前咨询法律意见,确保合规性。 -

问:如何应对腾讯招聘的反爬虫机制?

答:可通过以下方法应对:①使用代理IP池轮换IP地址;②降低请求频率,避免短时间高频访问;③模拟真实浏览器行为,如设置完整的headers、处理cookies;④对于动态加载页面,使用Selenium等工具模拟用户操作;⑤定期更新爬虫策略,适应网站反爬虫规则的调整。