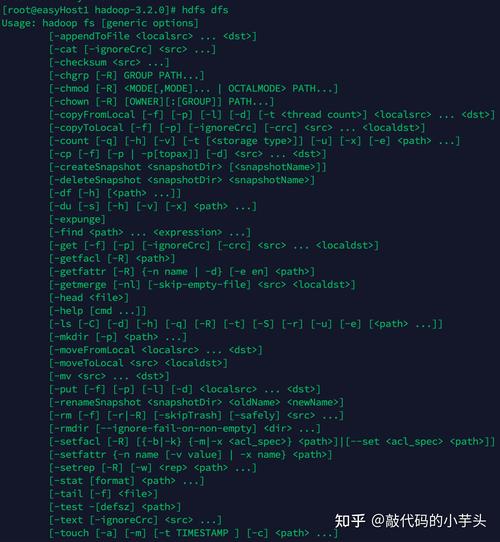

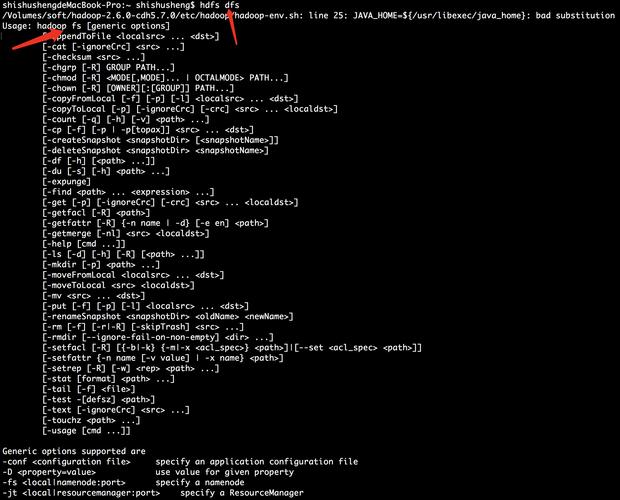

在Hadoop分布式文件系统(HDFS)中,查看文件内容是日常运维和开发中的常见操作,掌握相关命令能高效地完成文件浏览、内容检查等任务,HDFS提供了多种命令用于查看文件,这些命令功能各异,适用于不同的场景,如查看文件内容、获取文件元数据、查看目录结构等,以下将详细介绍常用的HDFS查看文件命令,包括其语法、功能、使用示例及注意事项。

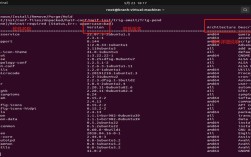

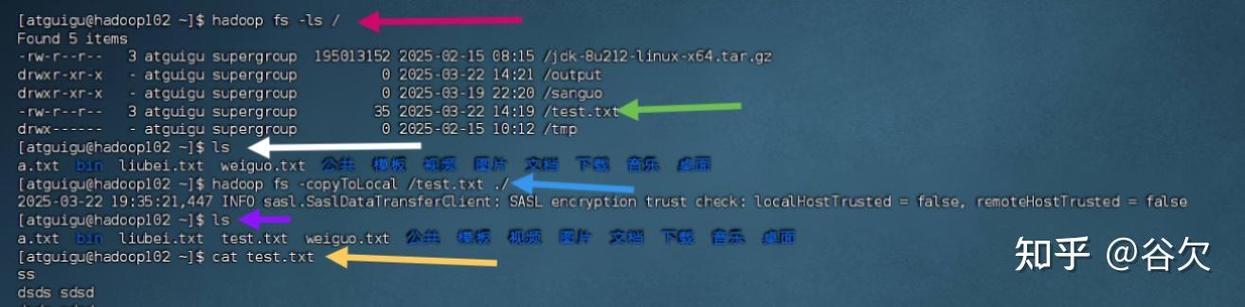

最基础且常用的命令是hdfs dfs -cat,该命令用于查看HDFS文件的内容,类似于Linux中的cat命令,其基本语法为hdfs dfs -cat <路径>,其中<路径>可以是HDFS上的文件路径,如/user/hadoop/input.txt,执行该命令后,文件的内容会直接输出到终端。hdfs dfs -cat /user/hadoop/data.txt会显示data.txt文件的完整内容,需要注意的是,如果文件较大,终端可能会因输出过多而显得混乱,此时可以通过管道结合more或less命令进行分页显示,如hdfs dfs -cat /user/hadoop/bigfile.txt | more。-cat命令只能用于查看文件,若路径指向目录,则会报错。

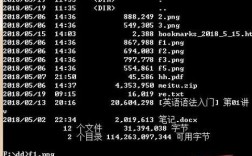

hdfs dfs -ls命令用于列出HDFS指定目录下的文件和子目录信息,类似于Linux中的ls命令,其语法为hdfs dfs -ls <路径>,默认情况下,会显示文件的权限、所有者、大小、修改时间及名称等信息。hdfs dfs -ls /user/hadoop会列出/user/hadoop目录下的所有文件和子目录,若需查看详细信息,可结合-h参数以人类可读的格式显示文件大小(如KB、MB),如hdfs dfs -ls -h /user/hadoop,该命令还可用于检查文件是否存在,若路径指向文件,则会显示该文件的元数据信息;若路径不存在,则会提示错误。

对于需要查看文件部分内容的场景,hdfs dfs -tail命令非常实用,它类似于Linux中的tail命令,用于显示文件的末尾部分,默认情况下,hdfs dfs -tail <路径>会显示文件的最后1000行内容,可通过-n参数指定行数,如hdfs dfs -tail -n 200 /user/hadoop/log.txt显示文件的最后200行,该命令特别适用于查看日志文件的最新内容,无需加载整个文件,节省资源,需要注意的是,-tail命令仅适用于文件,若路径为目录,则会报错。

若需查看文件的文本内容并进行交互式操作,hdfs dfs -text命令是更好的选择,该命令会自动识别文件类型,对于文本文件(如.txt、.csv、.log)直接显示内容,对于二进制文件(如.seq、.avro)会尝试以文本格式解析并显示,其语法为hdfs dfs -text <路径>,例如hdfs dfs -text /user/hadoop/data.seq会尝试以文本形式显示SequenceFile的内容,与-cat相比,-text命令更灵活,能处理多种格式的文件,但若文件为非结构化二进制文件,输出可能难以阅读。

hdfs dfs -stat命令用于获取文件的元数据信息,如文件大小、修改时间、权限等,其语法为hdfs dfs -stat [格式选项] <路径>,默认情况下,会显示文件的权限、所有者、大小和修改时间,如hdfs dfs -stat /user/hadoop/data.txt,通过-c参数可自定义输出格式,例如hdfs dfs -stat -c "%n %s %y" /user/hadoop/data.txt会显示文件名、大小和修改时间,该命令适用于需要快速获取文件属性的场景,而不需要查看文件内容。

对于大文件的分块查看,HDFS没有直接的分页命令,但可通过hdfs dfs -cat结合split和head/tail命令间接实现,将文件按行分割后查看某一部分:hdfs dfs -cat /user/hadoop/bigfile.txt | split -l 1000 - split_part_,然后查看split_part_aa文件的前100行,这种方法适用于需要分段处理大文件的场景,但操作相对复杂。

以下是常用HDFS查看文件命令的总结表格:

| 命令 | 语法示例 | 功能描述 | 适用场景 |

|---|---|---|---|

hdfs dfs -cat |

hdfs dfs -cat /path/file.txt |

显示文件全部内容 | 查看小文件或完整内容 |

hdfs dfs -ls |

hdfs dfs -ls -h /path/dir |

列出目录文件及元数据 | 浏览目录结构、检查文件信息 |

hdfs dfs -tail |

hdfs dfs -tail -n 200 /path/file |

显示文件末尾部分内容 | 查看日志最新内容 |

hdfs dfs -text |

hdfs dfs -text /path/file.seq |

以文本格式显示文件内容(支持多种格式) | 查看文本或二进制解析文件 |

hdfs dfs -stat |

hdfs dfs -stat -c "%s" /path/file |

获取文件元数据(大小、时间等) | 快速检查文件属性 |

在使用这些命令时,需要注意以下几点:一是确保当前用户对目标路径有读取权限,否则会提示“Permission denied”;二是文件路径需使用HDFS的完整路径(如/user/hadoop/file.txt),而非本地路径;三是对于大文件,避免使用-cat直接输出到终端,以免导致终端卡顿或资源耗尽;四是HDFS命令区分大小写,参数需正确书写。

相关问答FAQs:

Q1: 使用hdfs dfs -cat查看大文件时终端卡住怎么办?

A: 若文件较大,直接使用hdfs dfs -cat会导致终端输出过多而卡顿,建议通过管道结合分页工具处理,如hdfs dfs -cat /path/bigfile.txt | less或hdfs dfs -cat /path/bigfile.txt | head -n 1000,分页或限制输出行数,避免一次性加载全部内容,可考虑使用hdfs dfs -tail查看文件末尾部分,或通过Hadoop的Web界面(如http://

Q2: hdfs dfs -text和hdfs dfs -cat有什么区别?

A: 两者的主要区别在于文件格式支持:hdfs dfs -cat仅适用于纯文本文件,直接输出文件内容;而hdfs dfs -text能自动识别文件类型,除文本文件外,还可处理SequenceFile、Avro等二进制格式文件,并尝试以文本形式解析输出。-text命令适用范围更广,适合查看多种格式的文件,而-cat更简单直接,仅适用于普通文本文件。