获取服务器日志是系统管理、故障排查、安全审计和性能优化的核心环节,无论是运维工程师、开发人员还是安全分析师,都需要掌握多种日志获取方法,本文将系统介绍服务器日志的获取途径、具体操作步骤、注意事项及不同场景下的最佳实践,帮助读者高效、准确地获取所需日志信息。

服务器日志的基础认知

服务器日志是记录系统运行状态、应用程序行为、用户操作及网络活动的文件,通常包含时间戳、事件类型、来源IP、操作内容等关键信息,常见的日志类型包括系统日志(如Linux的syslog、Windows的Event Log)、应用程序日志(如Nginx的access.log、MySQL的error.log)、安全日志(如防火墙日志、登录日志)等,获取日志前,需明确日志类型、存储位置及时间范围,避免盲目操作。

本地直接获取日志

通过命令行工具实时查看

对于本地服务器,最直接的方式是使用命令行工具实时查看日志输出。

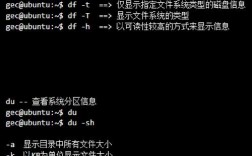

- Linux系统:

tail -f /var/log/nginx/access.log:实时追踪Nginx访问日志,适用于监控实时流量。journalctl -u nginx -f:通过systemd查看Nginx服务的日志,支持按服务名过滤。grep "error" /var/log/syslog:在系统日志中搜索包含"error"的行,快速定位错误信息。

- Windows系统:

Get-EventLog -LogName Application -Newest 100:使用PowerShell查看最新100条应用程序日志。- 事件查看器(eventvwr.msc):图形化界面,可按类型、时间筛选日志,导出为CSV或EVTX格式。

查看历史日志文件

若需分析历史数据,可直接读取日志文件:

cat /var/log/mysql/mysql.log:查看MySQL完整日志,适合全量分析。less /var/log/auth.log:分页查看Linux认证日志,支持上下翻页和关键词搜索(/键搜索)。wevtutil qe Security /c:100 /rd:true:Windows命令行查询安全日志最新100条记录。

日志归档与压缩

大型服务器日志可能被分割或压缩,需使用对应工具处理:

zcat /var/log/syslog.1.gz:查看压缩的旧日志文件(.gz格式)。tar -tf logs.tar.gz:查看归档日志文件列表,再通过tar -xf logs.tar.gz解压特定文件。

远程获取服务器日志

当无法直接访问服务器时,需通过远程方式获取日志。

使用SSH/SFTP协议传输

- SSH远程查看:

ssh user@server_ip "tail -n 500 /var/log/apache2/error.log":通过SSH命令远程查看Apache错误日志最后500行,避免登录服务器。 - SFTP下载日志:

使用sftp user@server_ip连接后,通过get /var/log/kern.log ./kern.log下载日志文件到本地。

通过日志管理工具集中收集

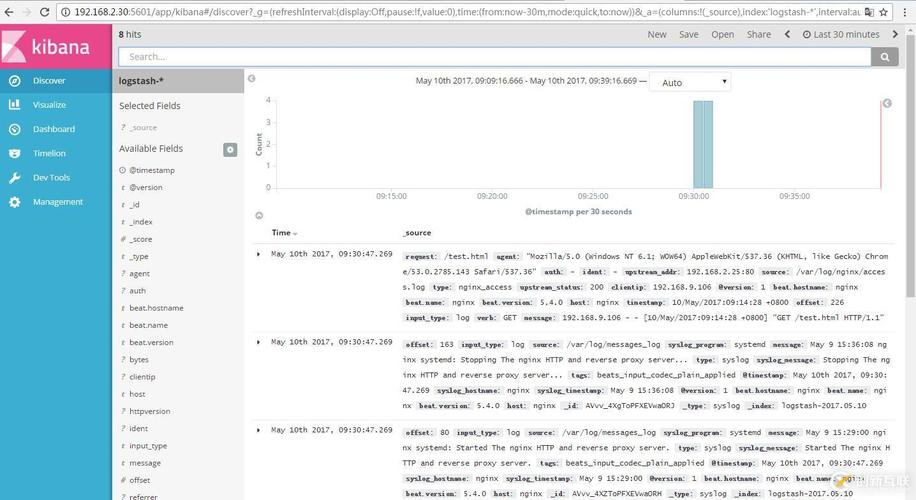

- ELK Stack(Elasticsearch+Logstash+Kibana):

在服务器部署Logstash收集日志,发送至Elasticsearch存储,通过Kibana可视化查询,适合大规模日志管理,支持实时检索和过滤。 - Graylog:

开源日志管理系统,通过Graylog Collector Agent收集日志,支持告警和报表生成,配置较ELK更简单。 - Splunk:

商业日志分析平台,支持多种数据源接入,提供强大的搜索和可视化功能,适合企业级应用。

云平台日志服务

- AWS CloudWatch Logs:

在EC2实例上安装CloudWatch Agent,将系统或应用日志发送至CloudWatch,可通过控制台或CLI查询,支持设置告警规则。 - 阿里云日志服务:

通过Logtail采集服务器日志,存储在Logstore中,使用SQL语句分析日志,如select count(*) as error_count from logstore where level='error'。 - 腾讯云CLS:

类似阿里云日志服务,支持日志实时采集、多维度分析,与腾讯云产品(如CVM、容器服务)深度集成。

自动化日志获取脚本

对于定期日志收集需求,可编写自动化脚本:

-

Shell脚本示例:

#!/bin/bash DATE=$(date +%Y%m%d) LOG_DIR="/backup/logs" mkdir -p $LOG_DIR scp user@server_ip:/var/log/nginx/access.log $LOG_DIR/access_$DATE.log gzip $LOG_DIR/access_$DATE.log

该脚本通过SCP将远程Nginx日志备份至本地,并自动压缩,可配合cron定时任务执行(如每天凌晨2点运行)。

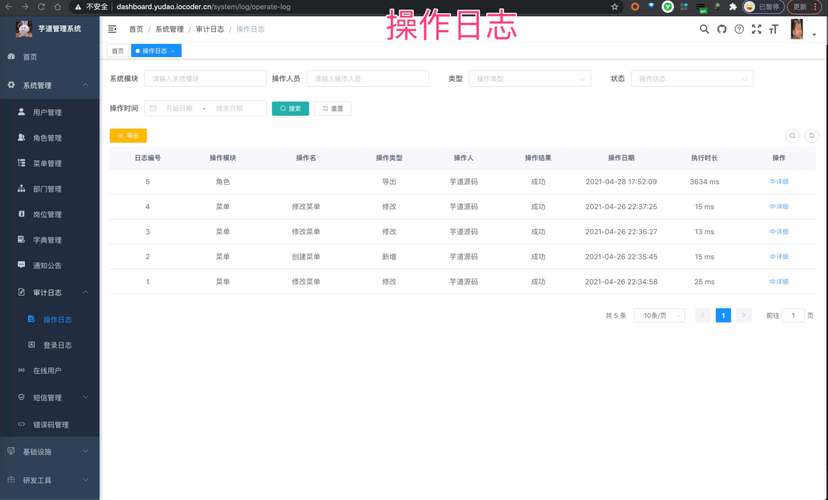

(图片来源网络,侵删)

(图片来源网络,侵删) -

Python脚本示例:

使用paramiko库通过SSH获取日志:import paramiko ssh = paramiko.SSHClient() ssh.set_missing_host_key_policy(paramiko.AutoAddPolicy()) ssh.connect('server_ip', username='user', password='password') stdin, stdout, stderr = ssh.exec_command('tail -n 1000 /var/log/syslog') with open('local_syslog.log', 'w') as f: f.write(stdout.read().decode()) ssh.close()

日志获取的注意事项

- 权限控制:确保执行日志操作的用户具有足够权限(如root或sudo权限),避免因权限不足导致读取失败。

- 日志轮转:Linux系统通过logrotate管理日志轮转,需检查

/etc/logrotate.conf配置,避免旧日志被自动清理。 - 敏感信息过滤:日志中可能包含密码、IP等敏感数据,获取后需通过

sed 's/.*password.*/****/g'等命令脱敏处理。 - 性能影响:实时大量读取日志可能影响服务器性能,建议在业务低峰期操作,或使用

rsync增量同步减少负载。

不同场景下的日志获取策略

| 场景 | 推荐方法 | 工具/命令示例 |

|---|---|---|

| 实时故障排查 | 本地/SSH实时查看 | tail -f、journalctl -f |

| 历史错误分析 | 下载日志文件并搜索 | grep、awk、Excel筛选 |

| 多服务器日志统一管理 | 部署日志管理系统 | ELK、Graylog、Splunk |

| 云服务器日志 | 使用云平台日志服务 | AWS CloudWatch、阿里云CLS |

| 定期备份日志 | 编写自动化脚本 | Shell+SCP、Python+paramiko |

相关问答FAQs

Q1: 如何快速定位服务器日志中的特定错误信息?

A1: 可根据日志类型选择高效搜索方式:

- Linux系统日志:使用

grep -i "error" /var/log/syslog(忽略大小写)或journalctl -p err查看所有错误级别日志。 - 应用程序日志:若日志为JSON格式(如Nginx access.log),可通过

jq工具解析,如cat access.log | jq '.message | select(contains("error"))'。 - Windows日志:通过事件查看器筛选“错误”级别事件,或使用

wevtutil qe Application /q:"*[System[(EventID=1001)]]"查询特定ID事件。

Q2: 服务器日志存储空间不足,如何高效获取旧日志?

A2: 可采取以下步骤:

- 检查日志轮转配置:确认

logrotate是否已启用(通常位于/etc/logrotate.d/),旧日志可能被压缩为.gz或.xz格式,使用zcat或xzcat查看。 - 按需下载:通过

scp或rsync仅下载指定时间段的日志,如scp user@server_ip:/var/log/syslog.1.gz ./。 - 清理无用日志:在获取后删除本地已分析日志,或使用

find /var/log -name "*.log.*" -mtime +30 -delete清理30天前的旧日志释放空间。 - 启用日志归档:配置日志服务(如ELK)将冷数据转储至低成本存储(如AWS S3),避免占用服务器本地空间。