在Linux系统中,下载文件是日常操作和服务器管理中的常见需求,Linux提供了多种下载命令工具,它们各具特色,适用于不同的场景和需求,这些命令通常通过命令行界面操作,具有高效、灵活且可脚本化的优势,能够满足从简单文件下载到复杂批量任务的多种需求。

最基础和常用的下载命令是wget,它是一个免费的网络文件下载工具,支持HTTP、HTTPS和FTP协议,其特点是功能强大、稳定可靠且支持后台下载,使用wget时,基本语法为wget [选项] URL,例如wget https://example.com/file.zip即可下载指定文件。wget的常用选项包括-b或--background,用于将下载任务置于后台执行,适合下载大文件;-c或--continue,支持断点续传,当下载中断后可以继续从上次停止的位置下载,避免重新开始;-r或--recursive,用于递归下载,可下载整个网站或目录结构,配合-l选项可限制递归深度;-p或--page-requisites,在递归下载时获取完成页面所需的全部文件,如图片、样式表等;-A或--accept,指定下载的文件扩展名,例如-A pdf,doc仅下载PDF和Word文档。wget还支持通过-i选项从文件中读取URL列表进行批量下载,或使用--limit-rate限制下载速度,避免占用过多网络带宽。

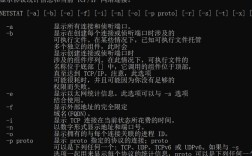

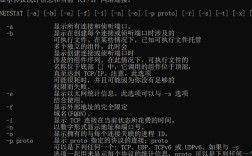

另一个强大的下载工具是curl,它最初设计用于传输数据,支持几乎所有的网络协议,包括HTTP、HTTPS、FTP、SCP、SFTP等,功能比wget更为全面。curl的基本语法为curl [选项] URL,例如curl -O https://example.com/file.zip中的-O选项表示以远程文件名保存本地。curl的常用选项包括-L或--location,当服务器返回重定向(如301、302)时自动跟随跳转;-C -或--continue-at -,实现断点续传,与wget的-c类似;-o或--output,指定本地保存文件名,例如curl -o myfile.txt https://example.com/data.txt;-u或--user,用于需要身份验证的下载,例如curl -u username:password ftp://example.com/file.zip;或--progress-bar,显示下载进度条,提升用户体验。curl还支持通过-X POST等选项模拟HTTP请求,适合需要与服务器交互的复杂下载场景,例如下载需要POST提交表单的数据。

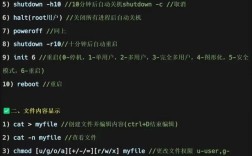

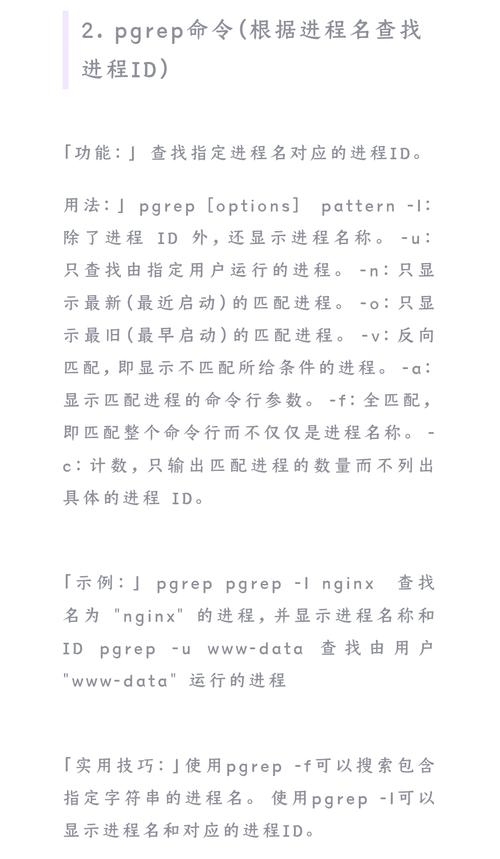

除了wget和curl,Linux中还提供了一些其他下载工具,适用于特定场景,例如aria2,它是一个轻量级的多协议和多源命令行下载工具,支持HTTP、HTTPS、FTP、BitTorrent和Metalink,最大的特点是支持多线程下载,能显著提高下载速度,使用aria2时,基本语法为aria2c [选项] URL,例如aria2c -x 16 -s 16 https://example.com/largefile.iso中的-x选项设置最大线程数,-s选项设置 splits 数量(类似分块下载)。aria2还支持同时下载多个URL、通过.torrent文件进行BT下载,以及配置RPC服务实现远程管理,对于简单的文件复制,Linux系统还提供了scp(secure copy)和sftp(SSH file transfer protocol)工具,它们基于SSH协议,用于在本地与远程服务器之间安全传输文件,语法分别为scp [选项] [user@host:]source_file [user@host:]destination_file和sftp [user@host],后者会进入交互式命令行界面,支持类似FTP的操作命令如get(下载)、put(上传)等。

为了更直观地比较这些工具的特点,以下是一个简要的对比表格:

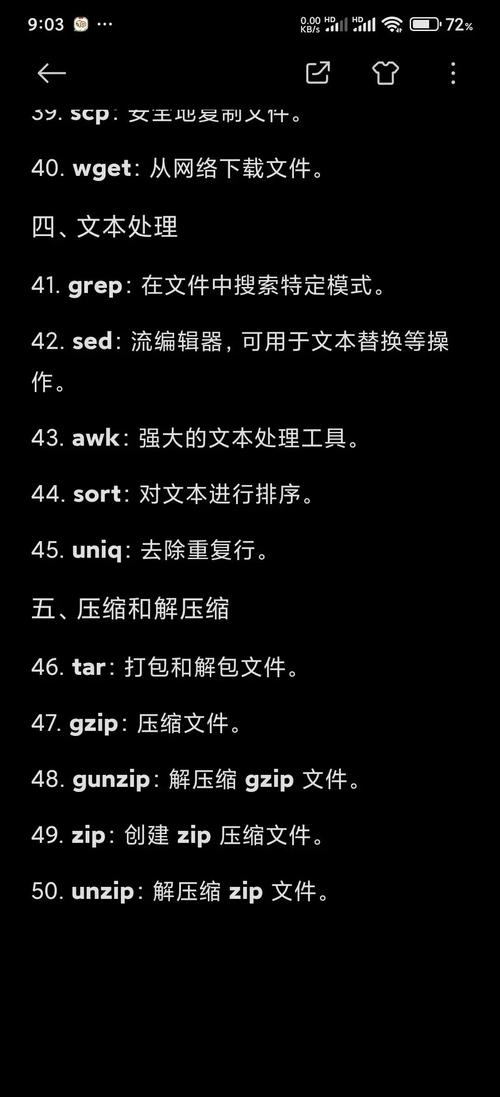

| 工具名称 | 支持协议 | 核心特点 | 适用场景 |

|---|---|---|---|

| wget | HTTP, HTTPS, FTP | 简单易用、支持递归下载、断点续传 | 常规文件下载、网站镜像 |

| curl | HTTP, HTTPS, FTP, SCP, SFTP等 | 协议支持广、支持复杂请求、进度显示友好 | 需要交互式下载、模拟请求、多协议传输 |

| aria2 | HTTP, HTTPS, FTP, BitTorrent等 | 多线程加速、支持多协议、BT下载 | 大文件下载、BT任务、需要高下载速度场景 |

| scp/sftp | 基于SSH | 安全加密、远程文件传输 | 本地与远程服务器间的安全文件传输 |

在实际使用中,选择合适的下载工具需要根据具体需求决定,下载普通网页文件时,wget的简洁性足够应对;需要处理HTTPS或复杂请求时,curl的灵活性更具优势;下载大文件或BT资源时,aria2的多线程能力能显著提升效率;而涉及远程服务器安全传输时,scp或sftp则是首选,这些工具通常可以通过管道、脚本与其他命令结合,实现自动化下载任务,例如结合find命令批量下载特定类型的文件,或通过cron定时任务定期更新下载内容,充分发挥Linux命令行的强大功能。

相关问答FAQs

Q1: wget和curl的主要区别是什么?如何选择?

A1: wget和curl的核心区别在于设计理念和功能侧重,wget专注于文件下载,支持递归下载、网站镜像等批量操作,语法更简单,适合“下载整个资源”的场景;curl则是一个全能的传输工具,支持更多协议(如SCP、SFTP),能模拟HTTP请求(如POST、PUT),并支持与服务器交互,适合需要精细控制传输过程的场景,选择时,若只需简单下载文件或镜像网站,wget更便捷;若涉及复杂请求、多协议传输或需要与服务器交互,curl更合适。

Q2: 如何使用aria2实现多线程下载?如何限制下载速度?

A2: 使用aria2实现多线程下载需通过-x(或--max-connections-per-server)选项设置最大连接数,例如aria2c -x 8 https://example.com/largefile.zip表示开启8个线程下载,限制下载速度可使用-t(或--max-overall-download-limit)选项,例如aria2c --max-overall-download-limit=100K https://example.com/file.zip将总下载速度限制在100KB/s。-s(或--split)选项可设置分块数,通常与-x配合使用以优化多线程性能。