在网站管理和维护过程中,死链接(即失效的URL)不仅会影响用户体验,还可能导致搜索引擎爬虫抓取效率降低,进而影响网站SEO排名,定期检测并删除死链接是网站优化的重要环节,本文将详细介绍如何在源码中删除死链接,包括具体操作步骤、注意事项及实用工具,帮助网站管理员高效完成这项工作。

要删除源码中的死链接,首先需要明确死链接的来源,死链接通常由以下几种情况产生:网页被删除但未被正确重定向、URL拼写错误、目标资源移动位置但未更新链接、外部链接失效等,针对不同原因,删除死链接的方法也有所不同,以下是具体的操作步骤:

通过代码编辑工具定位死链接

-

使用文本编辑器或IDE打开源码文件

网站源码通常存储在本地服务器或开发环境中,使用代码编辑工具(如VS Code、Sublime Text、Dreamweaver等)打开网站的HTML、PHP、JavaScript等文件,对于大型网站,建议使用支持全局搜索的编辑器,以提高效率。 -

全局搜索可疑链接

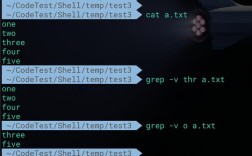

通过编辑器的“查找”功能(快捷键Ctrl+F或Cmd+F)输入可能包含死链接的关键词,如“http”、“href”、“src”等,搜索“href=”可以快速定位所有内部链接,对于动态网站(如PHP、ASP.NET),还需检查数据库中存储的URL字段。 -

识别并标记死链接

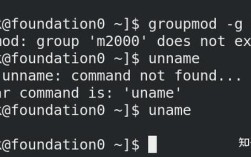

在搜索结果中,逐一检查链接是否指向有效资源,可通过手动访问链接或使用浏览器开发者工具(F12)的“网络”标签页查看请求状态,若返回404、403或500等错误状态码,则可判定为死链接,将需要删除的链接标记出来,避免误删有效链接。 (图片来源网络,侵删)

(图片来源网络,侵删)

直接删除源码中的死链接

-

静态网页(HTML/CSS/JS)

- 对于HTML文件中的死链接(如

<a href="invalid-url">),直接删除整个<a>标签或替换为有效链接。 - 若死链接出现在图片资源(如

<img src="missing-image.jpg">),需检查图片路径是否正确,或删除未使用的图片标签以减少冗余代码。 - JavaScript文件中的死链接(如AJAX请求的URL)需通过

fetch()或XMLHttpRequest方法验证,确保URL有效后保留或修改。

- 对于HTML文件中的死链接(如

-

动态网页(PHP/Python/Java等)

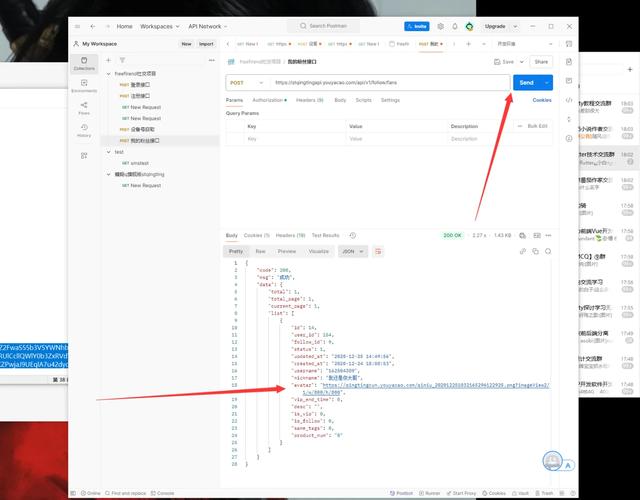

- 对于PHP文件中的死链接,需检查数据库查询结果,若链接从数据库动态生成,需执行SQL查询定位无效记录:

SELECT * FROM articles WHERE url LIKE '%invalid-url%';

找到记录后,通过

DELETE语句删除或更新url字段。 - 若死链接由变量拼接产生(如

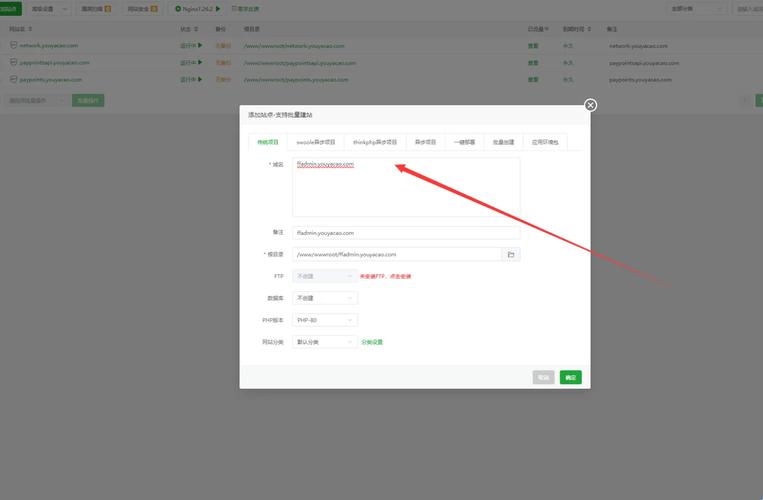

$base_url . $page_id),需检查变量赋值逻辑,确保拼接后的URL有效。 管理系统(CMS)** - 对于WordPress等CMS平台,死链接可能存在于文章、页面或自定义字段中,可通过数据库管理工具(如phpMyAdmin)直接编辑

wp_posts或wp_postmeta表,删除无效的guid或meta_value。 - 插件(如“Broken Link Checker”)可辅助检测死链接,但手动删除仍需进入源码或后台编辑器操作。

- 对于PHP文件中的死链接,需检查数据库查询结果,若链接从数据库动态生成,需执行SQL查询定位无效记录:

批量处理与自动化工具

当网站规模较大时,手动删除死链接效率低下,可借助以下工具实现批量处理:

| 工具类型 | 推荐工具 | 功能说明 |

|---|---|---|

| 链接检测工具 | Screaming Frog SEO Spider | 爬取整个网站,生成死链接报告,支持导出CSV格式供批量处理。 |

| 代码编辑器插件 | VS Code + “Find in Files”扩展 | 支持多文件全局搜索,可正则匹配URL模式,快速定位死链接位置。 |

| 自动化脚本 | Python + BeautifulSoup | 编写脚本解析HTML,遍历所有链接并验证有效性,自动标记或删除死链接。 |

使用Python脚本批量检测并删除死链接的示例代码如下:

from bs4 import BeautifulSoup

import requests

def remove_dead_links(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

content = f.read()

soup = BeautifulSoup(content, 'html.parser')

for link in soup.find_all('a', href=True):

url = link['href']

try:

response = requests.head(url, timeout=5)

if response.status_code == 404:

link.decompose() # 删除死链接标签

except requests.exceptions.RequestException:

link.decompose()

with open(file_path, 'w', encoding='utf-8') as f:

f.write(str(soup))

remove_dead_links('index.html')

注意事项

- 备份源码:删除操作前务必备份源码文件,避免误删导致网站功能异常。

- 测试环境验证:先在本地测试环境执行删除操作,确认无误后再部署到生产服务器。

- 重定向替代:若删除的链接曾包含重要流量,建议设置301重定向至新页面,避免用户流失。

- 定期检查:建议每月使用工具扫描一次死链接,及时维护网站健康度。

相关问答FAQs

Q1:如何区分内部死链接和外部死链接?处理方式有何不同?

A1:内部死链接指向网站自身资源(如/blog/missing-post),外部死链接指向第三方网站(如http://example.com),处理时,内部链接需直接从源码中删除或修复;外部链接则需评估重要性,若为低价值链接可直接删除,高价值链接可尝试联系对方网站修复,或通过rel="nofollow"属性避免传递权重。

Q2:删除死链接后,是否需要向搜索引擎提交Sitemap更新?

A2:是的,删除死链接后,建议重新生成Sitemap文件并通过搜索引擎站长工具(如Google Search Console、百度搜索资源平台)提交,这有助于搜索引擎快速更新索引,避免继续抓取无效URL,从而提升网站抓取效率。